Pour chaque humain visitant ton site web, il y a 3 robots.

Surpris ? Nous aussi.

Mais selon nos données internes, nous avons observé en moyenne 71,5% de trafic de bots depuis janvier 2025.

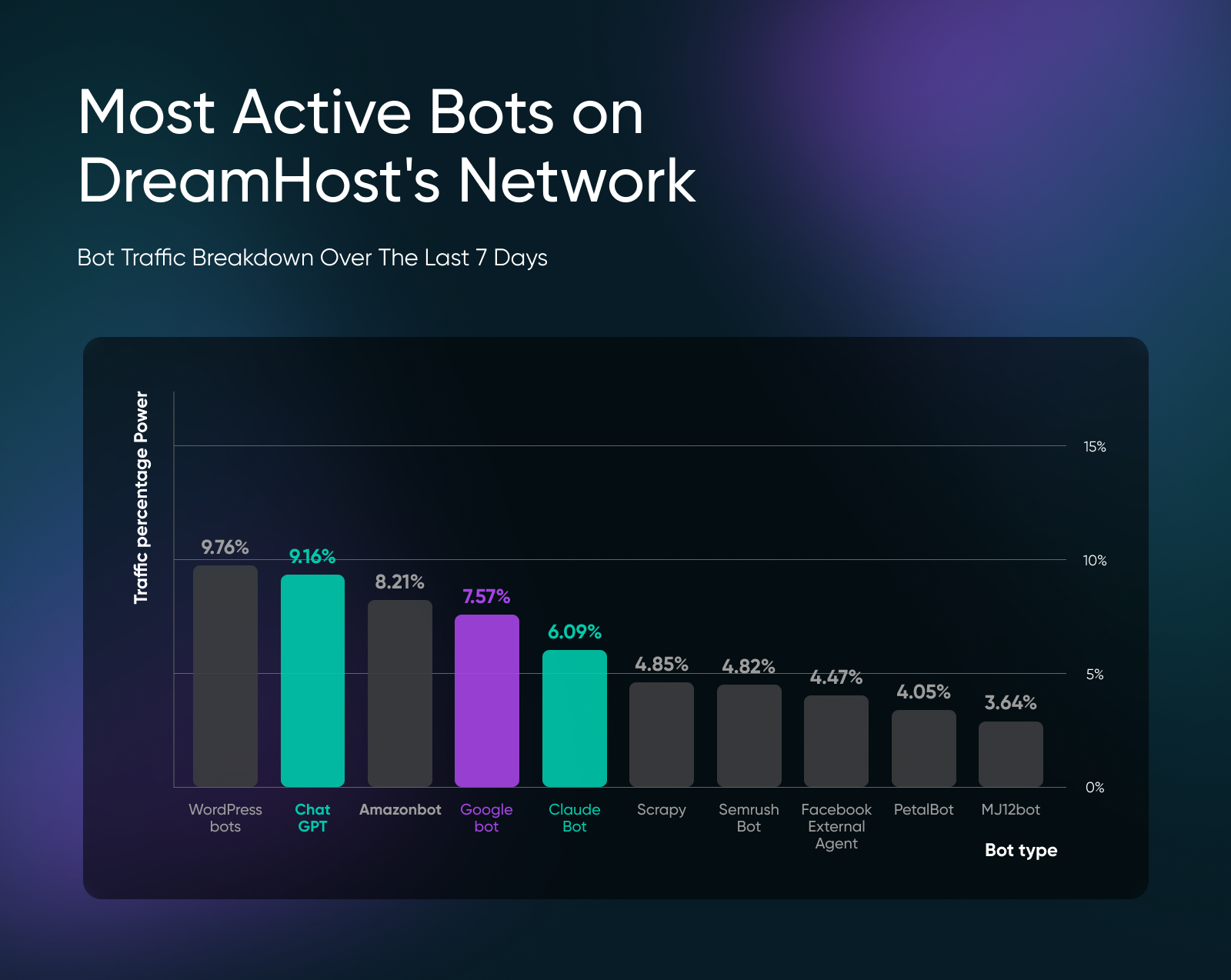

Les robots d’indexation IA de ChatGPT (9,16 %), Claude (6,09 %) et d’autres LLM apparaissent régulièrement dans nos données de trafic des robots, tandis que les robots des moteurs de recherche comme Googlebot représentent seulement 7,57 % du trafic.

Nous ne pouvons pas tous les bloquer car la plupart des bots sont nécessaires. Par exemple, Googlebot aide ton site à apparaître dans les recherches, ou le bot ChatGPT cite ta marque comme source dans les réponses.

Mais si tu constates des pics de trafic ou des entrées de spam dans tes formulaires de contact, c’est là que tu dois agir.

À Quel Point L’augmentation Du Trafic Des Bots Est-elle Grave ?

Voici un résumé du trafic de bots que nous observons sur les sites web de nos clients sur le réseau DreamHost :

Les modèles géographiques que nous avons observés sont également très intéressants.

L’Irlande mène le trafic des bots avec 40,70 % des visites quotidiennes, suivie de Singapour avec 13,04 %. Cette concentration géographique n’est pas juste une coïncidence.

L’Irlande accueille les sièges européens de presque toutes les principales entreprises technologiques américaines – Google, Apple, Microsoft, Amazon et Facebook – attirées par l’accès à l’UE, les faibles impôts sur les sociétés et une main-d’œuvre anglophone.

Pendant ce temps, Singapour est le centre de données pour l’Asie-Pacifique, avec AWS, Microsoft Azure et Google Cloud exploitant des installations majeures pour servir les marchés asiatiques avec une latence réduite. Lorsque les robots d’indexation IA et les services Cloud analysent les sites web, ils fonctionnent souvent à partir de fermes de serveurs concentrées dans ces deux emplacements stratégiques.

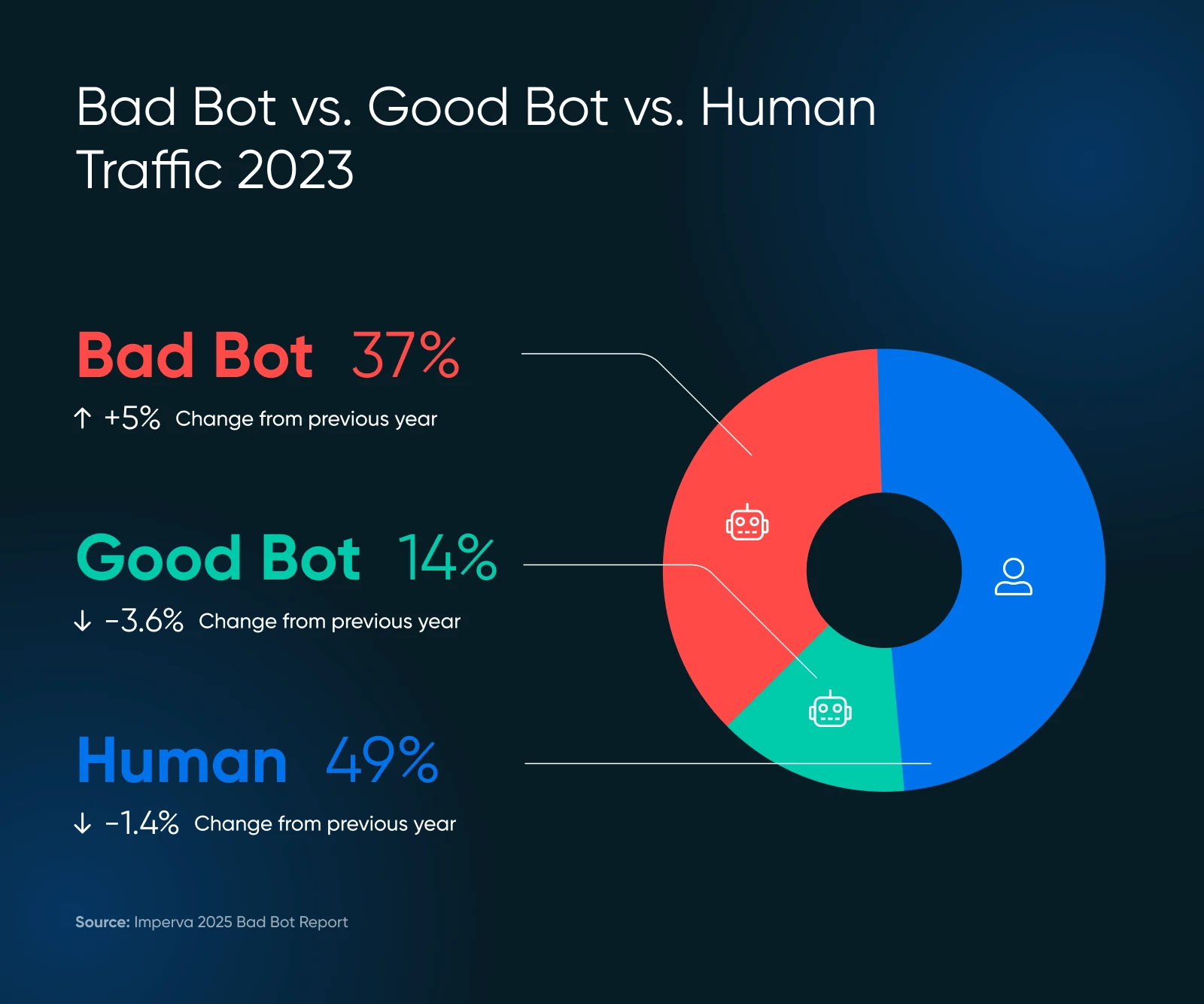

Nos résultats sont tout à fait cohérents avec le Rapport sur les mauvais bots d’Imperva 2025, où 51% du trafic internet provient désormais de sources automatisées, dont 37% sont classifiés comme des bots malveillants.

Le défi se situe dans la zone grise.

Certains robots d’indexation pour l’entraînement IA (comme GPTBot) collectent ton contenu pour entraîner des modèles linguistiques sans fournir de bénéfices directs en termes de trafic retour à ton site.

Mais que ces derniers représentent des “bons” ou des “mauvais” robots dépend de ce que tu penses des entreprises d’IA utilisant ton contenu à des fins commerciales.

Bons Bots vs. Mauvais Bots : Quelle est la Différence

Tout le trafic automatisé ne mérite pas d’être bloqué. Tu dois savoir quels bots aident ton entreprise et lesquels lui nuisent avant de prendre des mesures pour gérer les bots sur ton site web.

Bons Bots Qui Profitent À Ton Site

- Robots d’indexation des moteurs de recherche : Par exemple, Googlebot et Bingbot indexent ton contenu pour les résultats de recherche.

- Robots des réseaux sociaux : Comme FacebookExternalAgent qui génère des aperçus de liens lorsque les utilisateurs partagent ton contenu.

- Services de surveillance : Ceux-ci vérifient la disponibilité et la performance de ton site.

- Robots de recherche IA : Comme ChatGPT-User et Perplexity-User qui citent ton contenu lorsqu’ils répondent aux requêtes des utilisateurs.

Mauvais Bots Qui Épuisent Tes Ressources

- Robots de récupération de contenu : Ceux-ci volent vos articles, descriptions de produits et images.

- Robots de spam de formulaire : Ils inondent les formulaires de contact avec des soumissions indésirables.

- Robots de surveillance des prix : Utilisés par des concurrents pour suivre vos stratégies de tarification.

- Robots d’accumulation de stocks : Ceux-ci ajoutent des produits aux paniers sans acheter.

- Robots de bourrage d’identifiants : Ils tentent de s’introduire dans les comptes utilisateurs.

Les Coûts Cachés Impactant Ton Site De Petite Entreprise

Indépendamment du type de bot, le trafic automatisé impacte ton site web dans trois domaines critiques :

- Dépenses d’hébergement

- Risques de sécurité

- Exactitude des données

Chaque visite de bot consomme des ressources serveur tout comme un visiteur humain, mais sans aucune possibilité de conversions, d’engagement ou de revenus.

1. Tes coûts d’infrastructure ne cessent d’augmenter

Chaque requête de bot utilise ta bande passante, ta puissance de traitement, et ton stockage.

Si tu as un site riche en contenu ou une plateforme de commerce électronique, tu risques de voir cela impacter rapidement ton portefeuille.

Le projet Read the Docs a réduit le trafic de 75% après avoir bloqué les robots d’indexation IA et est passé de 800 Go à 200 Go quotidiens, économisant 1 500 $ par mois en coûts de bande passante.

Si tu es sur un plan d’hébergement partagé, tu ne verras pas de coûts directs.

Un trafic excessif de bots peut toutefois amener ton hôte à limiter les performances du site. Une activité de bots plus agressive peut te pousser à nécessiter des solutions d’VPS ou d’hébergement dédié plus tôt que prévu.

2. Les Problèmes de Sécurité et de Spam S’aggravent

Des bots malveillants ciblent tes formulaires de contact, pages de connexion, et processus de paiement.

Ils recherchent des vulnérabilités, tentent des attaques par bourrage d’identifiants et inondent également les formulaires de soumissions inutiles. Comme la plupart des sites web disposent uniquement d’une sécurité de base, ils deviennent une cible attrayante.

Si tes formulaires de contact ou commentaires de blog ont des entrées de spam, je te suggère d’installer Askimet immédiatement pour voir si les entrées de spam diminuent. N’oublie pas, cependant, que Askimet ne bloque pas le trafic des bots.

Tu dois prendre des mesures pour bloquer les bots toi-même (plus de détails à ce sujet dans un instant).

3. Tes Données Analytiques Sont Contaminées

Le trafic des bots perturbe les analyses de ton site web.

Quand les bots visitent des pages, ils n’interagissent pas avec le contenu, créant artificiellement des chiffres de trafic élevés avec zéro taux de conversion.

Cette contamination rend presque impossible pour toi de mesurer le comportement réel des utilisateurs, d’optimiser les entonnoirs de conversion, ou de prendre des décisions marketing basées sur les données.

Et même si Google Analytics te permet de filtrer le trafic pour affiner l’analyse, il est difficile de distinguer le trafic de bots des visiteurs humains réguliers.

Où Chercher le Trafic de Bot sur Ton Site

Il n’existe actuellement aucun moyen infaillible de détecter tout le trafic des bots, car les bots avancés sont pratiquement indiscernables des visiteurs humains.

Mais il y a certaines étapes que tu peux suivre pour commencer à surveiller.

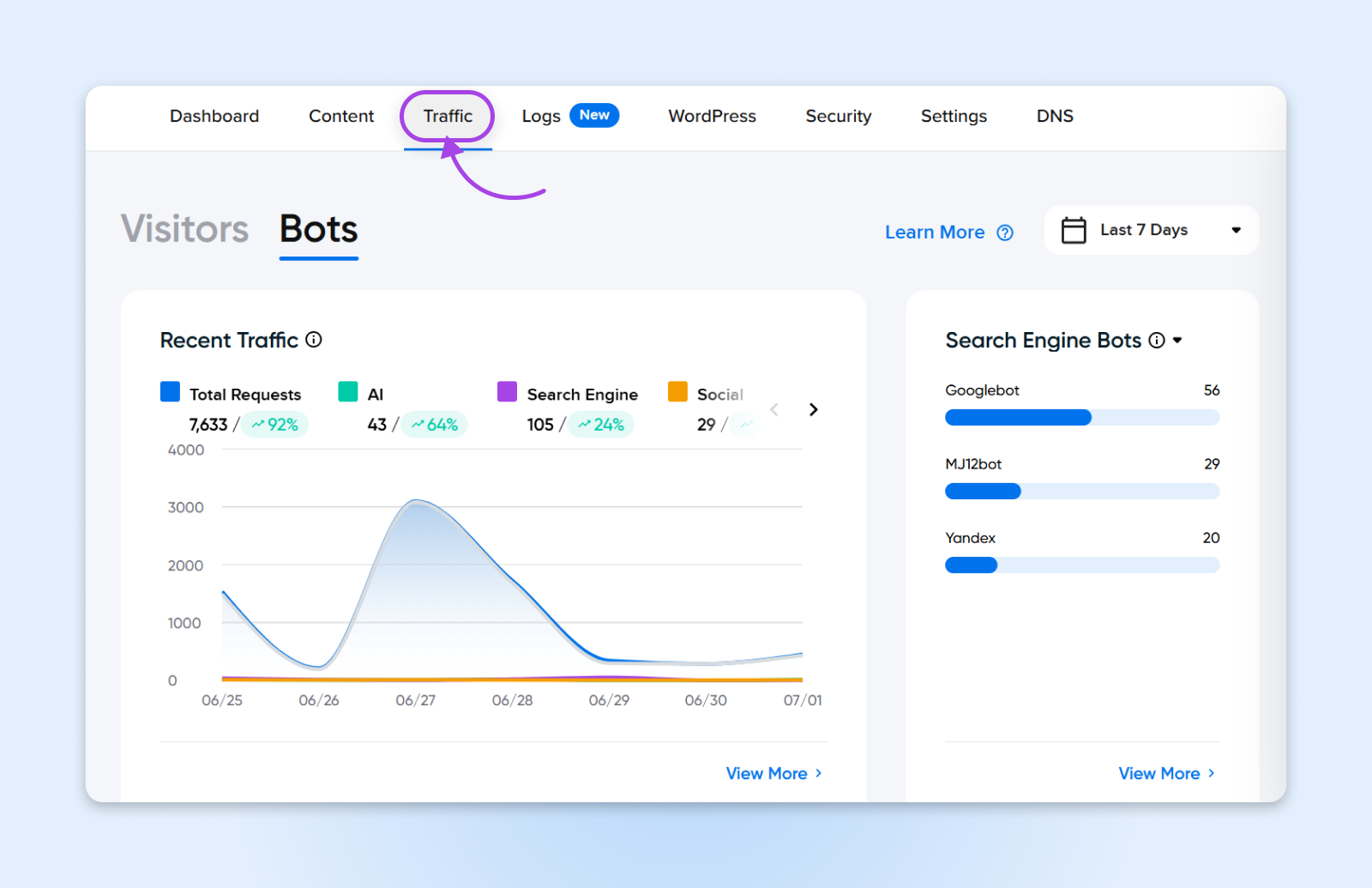

1. Commencez Avec Le Tableau De Bord De Trafic Du Panel DreamHost

Si tu héberges avec DreamHost, tu es déjà une longueur d’avance. L’onglet Trafic dans ton panel DreamHost t’offre une vue claire de l’activité du trafic, y compris le comportement des bots. Tu peux surveiller les pics, détecter les anomalies et suivre combien de bots peuvent impacter ton site, tout cela sans nécessiter d’outil tiers.

Notre panel t’aide à :

- Distingue instantanément le trafic humain du trafic de Bot

- Vois le trafic par IP, référent ou agent utilisateur

- Repère les motifs rapidement pour agir vite

Cela est particulièrement utile pour les utilisateurs qui préfèrent les outils intégrés aux tableaux de bord compliqués. Bonus – Aucune configuration supplémentaire n’est nécessaire !

2. Plongez dans Google Analytics

Regarde ton Google Analytics tableau de bord pour ces signes révélateurs d’une activité intense des bots :

- Pics de trafic avec augmentation correspondante du taux de rebond

- Nombre élevé de vues de page avec zéro temps passé sur la page

- Modèles de trafic géographique inhabituels (trafic soudain de pays où tu n’opères pas)

- Spam de référents provenant de domaines inconnus

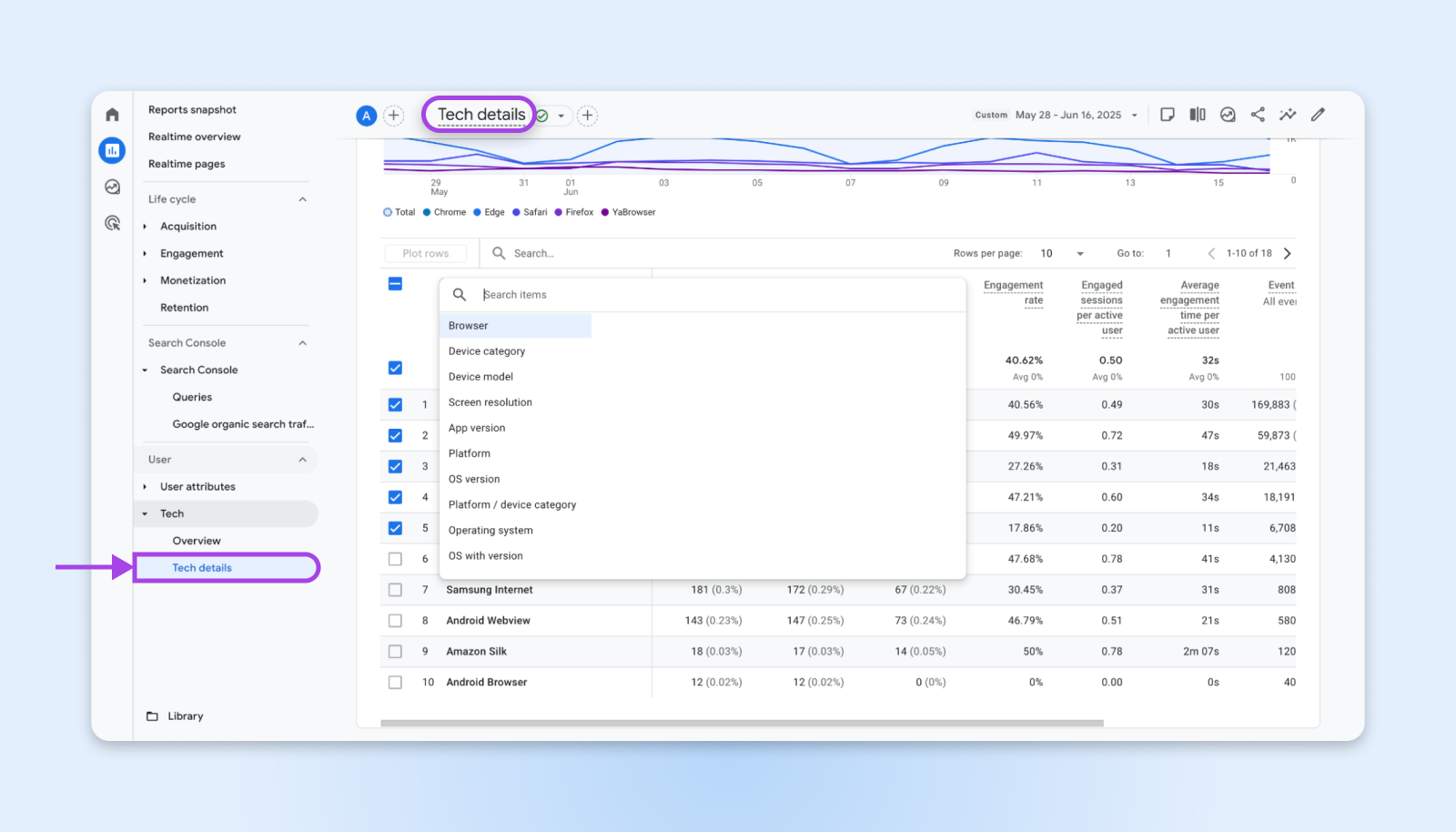

Rends-toi dans Rapports → Tech et utilise le filtrage tech de GA4 pour te concentrer sur la technologie utilisateur.

Ici, tu peux commencer à filtrer par navigateur et système d’exploitation, résolutions d’écran, appareil, versions d’applications, etc. Ce que tu cherches, ce sont des navigateurs peu communs, des systèmes d’exploitation étranges, et des résolutions d’écran peu communes comme :

- 1024 x 768

- 1366 x 768

- 1600 x 864

- 800 x 600

- 1600 x 1200

- 1024 x 667

- Non Spécifié

Cela exclurait certains visiteurs réels de ton suivi, mais tu verras également beaucoup moins d’entrées de bots dans les données d’analyse.

Note : Les bots avancés peuvent utiliser des résolutions normales et les dernières versions de dispositifs pour dissimuler leur activité. Ils sont extrêmement difficiles à filtrer pour l’analyse à moins que tu ne commences à filtrer les visiteurs avant qu’ils puissent voir ton site web.

3. Vérifie Tes Logs Serveur

Si tu as accès à ton panneau de contrôle d’hébergement, regarde tes logs d’accès serveur pour des motifs qui indiquent un trafic automatisé :

- Requêtes rapides provenant d’adresses IP uniques.

- Requêtes vers des pages inexistante (souvent des bots sondant les vulnérabilités).

- Agents utilisateurs s’identifiant comme robots d’indexation connus (bons et mauvais).

- Requêtes sans information de référenceur.

De nombreux fournisseurs d’hébergement, y compris DreamHost, proposent des outils d’analyse de logs dans leurs panneaux de contrôle. Recherche des pics inhabituels dans l’utilisation de la bande passante qui ne correspondent pas à des campagnes de marketing ou des mises à jour de contenu.

Une fois que tu as une liste d’adresses IP qui semblent être des récidivistes, tu peux commencer à bloquer les adresses IP soit depuis ton serveur web, comme NGINX ou Apache, soit depuis un CDN.

CDN

CDN est l’abréviation de u201cRéseau de Livraison de Contenuu201d. Il désigne un réseau de serveurs web distribué géographiquement (et leurs centres de données). Les entités qui composent un CDN collaborent pour garantir une livraison rapide du contenu via internet.

En savoir plus4. Utilise Des Outils De Surveillance Tiers

Parfois, tu peux seulement identifier une certaine quantité de trafic. C’est pourquoi il existe des outils tiers gratuits, comme Cloudflare Analytics (si tu utilises leur service), qui fournissent des détails sur le trafic des bots.

Il existe également d’autres applications complètes telles que :

- Wordfence: Pour les sites WordPress ; identifie les tentatives malveillantes de bot

- Sucuri: Offre des services de pare-feu pour sites web avec détection de bot

- MonsterInsights: Fournit des rapports Google Analytics améliorés avec filtrage de bot

Gérer Et Bloquer Les Mauvais Bots Sans Nuire Aux Bons

Je recommande de procéder lentement pour bloquer le trafic des bots car tu pourrais accidentellement bloquer également de vrais utilisateurs. Et tu as aussi besoin d’une approche équilibrée qui bloque le trafic automatisé nuisible tout en préservant les robots d’indexation bénéfiques.

Voici comment je mettrais en œuvre la gestion des bots sans bloquer accidentellement les moteurs de recherche ou les services légitimes.

Configure Ton Fichier robots.txt

Ton fichier robots.txt sert de première ligne de défense contre les robots d’indexation indésirables.

Crée ou met à jour le fichier dans le répertoire racine de ton site web avec des instructions spécifiques pour différents types de bots :

# Bloquer les robots d'indexation pour l'entraînement de l'IA

User-agent: GPTBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Google-Extended

Disallow: /

# Autoriser les moteurs de recherche

User-agent: Googlebot

Allow: /

User-agent: Bingbot

Allow: /

# Autoriser les robots de recherche IA qui citent les sources

User-agent: ChatGPT-User

Allow: /

User-agent: PerplexityBot

Allow: /Si tu n’as pas d’accès direct au fichier robots.txt et que tu utilises WordPress, tu pourrais essayer d’utiliser le Plugin WP Robots Txt qui te permet d’éditer le fichier depuis ton tableau de bord WordPress.

Garde à l’esprit que le fichier robots.txt fonctionne sur un système d’honneur. Les robots d’indexation bien élevés respectent ces directives, mais les bots malveillants ignorent souvent complètement le fichier.

Implémenter un pare-feu de site web

Pour une sécurité de site web plus agressive, implémente un Pare-feu d’Application Web (WAF) qui peut bloquer les bots au niveau du serveur.

Tu as également quelques options supplémentaires en tant que propriétaire d’une petite entreprise gérant des sites à faible volume.

Plan Gratuit Cloudflare :

- Fournit des capacités de base de lutte contre les bots

- Bloque automatiquement le trafic manifestement malveillant

- Propose des règles de pare-feu personnalisables pour des menaces spécifiques

Wordfence (Utilisateurs WordPress) :

- Inclut des fonctionnalités de détection et de blocage des bots

- Mises à jour en temps réel de l’intelligence sur les menaces

- Limitation de débit personnalisable pour éviter les requêtes en rafale

Limitation du Débit au Niveau du Serveur

De nombreux fournisseurs d’hébergement proposent des fonctionnalités de limitation de débit qui ralentissent automatiquement ou bloquent les adresses IP effectuant trop de requêtes sur de courts intervalles de temps. Tu peux configurer ces limiteurs de débit pour bloquer les adresses IP qui consultent trop de pages sur une période très courte.

Par exemple, une personne normale aurait besoin de quelques secondes pour regarder autour d’elle sur une page avant de cliquer sur différents liens. Un bot prendrait des millisecondes pour faire la même chose.

Solutions de Plugins pour les Sites WordPress

Si tu utilises WordPress, tu as des options supplémentaires pour la gestion des bots :

- Akismet: Filtre automatiquement les spams de commentaires et de formulaires avec une précision de 99,99% en utilisant un filtrage avancé par IA. Essentiel pour tout site WordPress acceptant des soumissions d’utilisateurs.

- WP Cerber Security: Offre une protection complète contre les bots, incluant la limitation des tentatives de connexion, le blocage d’IP et des algorithmes avancés de détection de bots.

- All-In-One Security (AIOS): Propose des fonctionnalités de pare-feu et des capacités de blocage de bots adaptées aux sites web de petites entreprises.

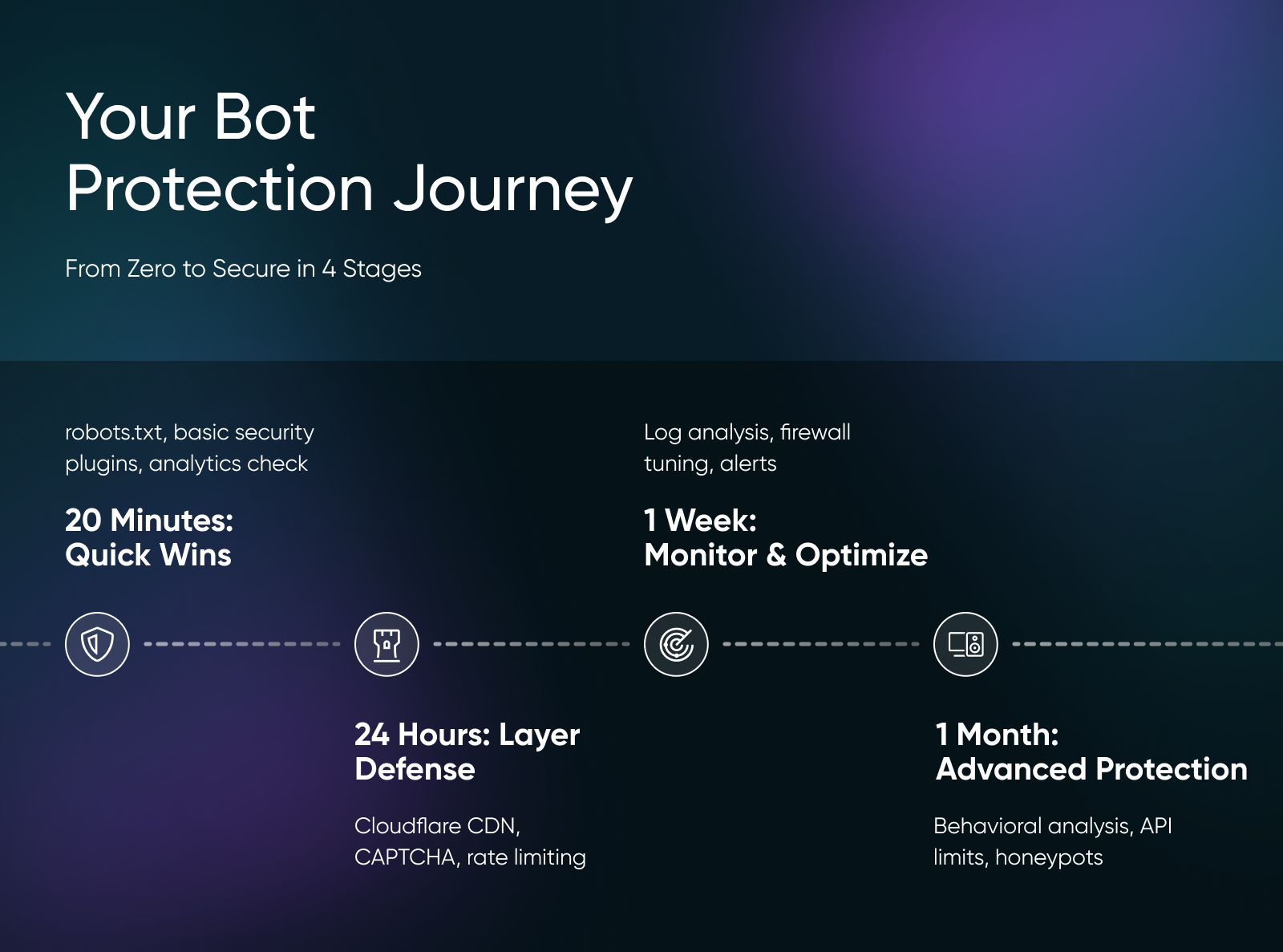

Votre Parcours Complet D’implémentation De Protection Contre Les Bots

J’ai divisé ce plan de mise en œuvre pour qu’il s’adapte à des emplois du temps serrés et t’aide à passer de zéro protection à une défense contre les bots fonctionnelle en peu de temps.

20 Minutes : Victoires Rapides

- Mettre à jour le fichier robots.txt

- Activer les plugins de sécurité de base

- Vérifier les motifs de bot dans Google Analytics

Commence avec ton fichier robots.txt car c’est la première étape la plus simple. Connecte-toi au gestionnaire de fichiers de ton site web (ou utilise FTP) et crée ou mets à jour le fichier robots.txt dans ton répertoire racine. Copie la configuration de robots.txt mentionnée plus tôt dans cet article et colle-la.

Si tu utilises WordPress, installe et active le plugin de sécurité Wordfence dès maintenant. La version gratuite inclut une protection de base contre les bots et commencera à bloquer immédiatement le trafic malveillant évident.

Ouvre Google Analytics pour vérifier tes sources de trafic à la recherche de modèles inhabituels. Recherche des pays que tu ne dessers pas, des pics de trafic soudains ou des taux de rebond élevés avec une durée de session nulle.

24 Heures : Superposez Votre Défense

- Crée un compte Cloudflare gratuit

- Configure la limitation de taux

- Ajoute un CAPTCHA aux formulaires

- Active la modération des commentaires

Inscris-toi pour un compte Cloudflare gratuit et ajoute ton site web. Cloudflare se place entre ton site et les visiteurs, bloquant automatiquement le trafic de bots évident avant qu’il n’atteigne ton serveur. La configuration prend environ 30 minutes et inclut la modification des paramètres DNS, mais Cloudflare te guide à chaque étape.

Définis une limitation de taux via ton hôte pour ralentir ou bloquer automatiquement les adresses IP effectuant trop de demandes. Configure des limites qui permettent une navigation normale (quelques secondes par page) mais arrêtent les robots d’indexation agressifs (plusieurs pages par seconde).

Ajoute un CAPTCHA aux formulaires vulnérables en utilisant le plugin reCAPTCHA pour WordPress ou Cloudflare Turnstile. Ajoute un CAPTCHA invisible aux formulaires de contact, aux sections de commentaires et aux pages d’enregistrement des utilisateurs pour arrêter les soumissions automatisées sans ennuyer les vrais utilisateurs.

Une Semaine : Surveiller et Optimiser

- Analyse des logs serveur

- Ajuster les règles du pare-feu

- Mettre en place des alertes de surveillance

- Bloquer les plages d’IP problématiques

Analyse tes logs d’accès serveur pour identifier les motifs de bots spécifiques à ton site. Recherche des requêtes en rafale provenant d’adresses IP uniques, des requêtes vers des pages inexistantes et des chaînes d’agents utilisateur suspects. La plupart des panneaux de contrôle d’hébergement incluent des outils d’analyse de logs qui facilitent cette tâche.

Utilise cette donnée pour créer des règles de pare-feu personnalisées dans Cloudflare ou ton plugin de sécurité. Par exemple, si tu remarques que des bots de pays spécifiques causent constamment des problèmes, tu peux bloquer des régions géographiques entières. Ou si certains agents utilisateurs frappent ton site de manière agressive, bloque ces chaînes spécifiques.

Configure des alertes de surveillance pour savoir quand les pics de trafic de bots se produisent. Des outils comme UptimeRobot ou Pingdom peuvent t’alerter sur des motifs de trafic inhabituels, des temps de chargement lents ou des pics de ressources serveur qui pourraient indiquer une attaque de bots.

Un Mois : Protection Avancée

- Implémenter une analyse comportementale

- Déployer une limitation de débit API

- Mettre en place un Cache CDN

- Créer des pots de miel pour bots

Ajoute des outils d’analyse comportementale comme DataDome ou Imperva qui détectent les bots en analysant les mouvements de la souris, les modèles de frappe et le timing des interactions avec la page. Ces outils capturent des bots sophistiqués qui imitent le comportement humain.

Utilise un CDN pour mettre en cache les ressources statiques de manière agressive. De cette façon, le trafic des bots touche le cache, pas ton hôte, réduisant la charge des demandes répétées.

Une de mes techniques préférées est la création de pots de miel pour bots. Si tu constates beaucoup de spam dans les formulaires, ajoute un champ caché au formulaire. Comme les bots examinent le HTML de la page lorsqu’ils remplissent les formulaires, ils verront ce champ caché et y ajouteront des données. Tu peux supprimer en toute sécurité toutes les entrées de formulaire qui contiennent du texte dans le champ caché, car un visiteur humain ne peut pas le voir.

L’Avenir de la Gestion du Trafic des Bots

Le trafic des bots ne disparaît pas. Avec 71,5 % des visites sur notre réseau provenant de sources automatisées, les robots sont désormais trois fois plus nombreux que les humains sur Internet.

Mais alors que la plupart des propriétaires de sites web essaient encore de comprendre ce qui se passe, tu as tout ce qu’il te faut pour renverser ce chaos de bots pour ton entreprise et même tirer profit des bons bots.

Alors va de l’avant et commence à mettre en place des systèmes de gestion de bots pendant que tes concurrents paniquent encore à propos du trafic factice !