Für jeden Menschen, der deine Website besucht, gibt es 3 Bots.

Überrascht? Wir auch.

Aber laut unseren internen Daten haben wir seit Januar 2025 einen durchschnittlichen Bot-Verkehr von 71,5% festgestellt.

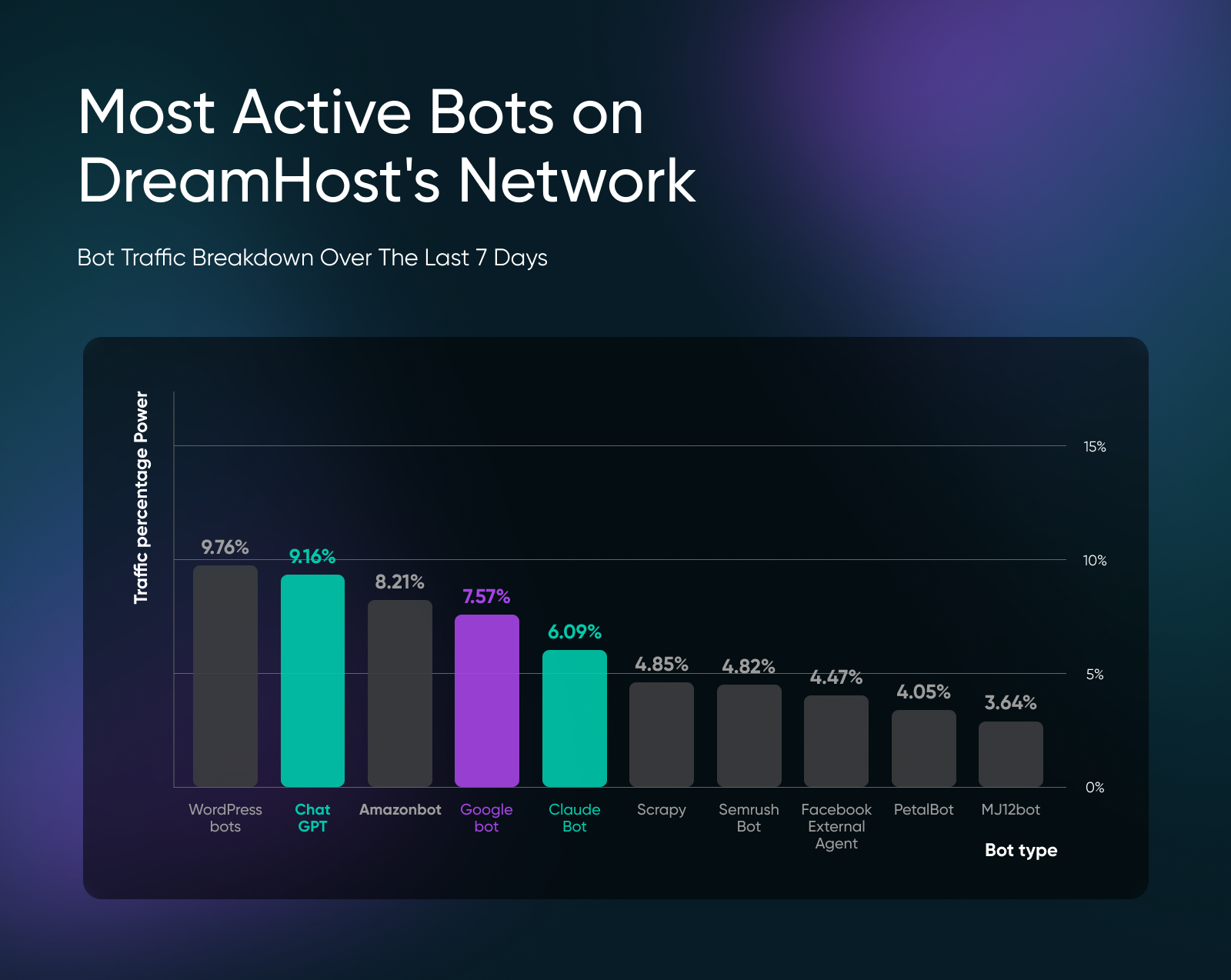

AI-Crawler von ChatGPT (9,16 %), Claude (6,09 %) und anderen LLMs tauchen regelmäßig in unseren Bot-Traffic-Daten auf, während Suchmaschinen-Bots wie Googlebot nur 7,57 % des Traffics ausmachen.

Wir können sie nicht einfach alle blockieren, da die meisten Bots notwendig sind. Zum Beispiel hilft Googlebot deiner Website, in der Suche zu erscheinen, oder ChatGPT-Bot zitiert deine Marke als Quelle in Antworten.

Aber wenn Du Verkehrsspitzen oder Spam-Einträge in Deinen Kontaktformularen siehst, dann ist es Zeit zu handeln.

Wie Schlimm Ist Der Anstieg Des Bot-Traffics Geworden?

Hier ist eine Übersicht über den Bot-Verkehr, den wir auf den Kundenwebseiten im DreamHost-Netzwerk sehen:

Die geografischen Muster, die wir beobachtet haben, sind auch sehr interessant.

Irland führt den Bot-Verkehr mit 40,70% der täglichen Besuche an, gefolgt von Singapur mit 13,04%. Diese geografische Konzentration ist kein Zufall.

Irland ist der europäische Hauptsitz fast jedes großen US-Tech-Unternehmens – Google, Apple, Microsoft, Amazon und Facebook – angezogen durch den Zugang zur EU, niedrige Unternehmenssteuern und eine englischsprachige Belegschaft.

Inzwischen ist Singapur das Datenzentrum-Hub im asiatisch-pazifischen Raum, mit AWS, Microsoft Azure und Google Cloud, die dort große Einrichtungen betreiben, um asiatische Märkte mit geringerer Latenz zu bedienen. Wenn AI Crawler und Cloud-Dienste Websites scannen, arbeiten sie oft von Serverfarmen aus, die in diesen beiden strategischen Standorten konzentriert sind.

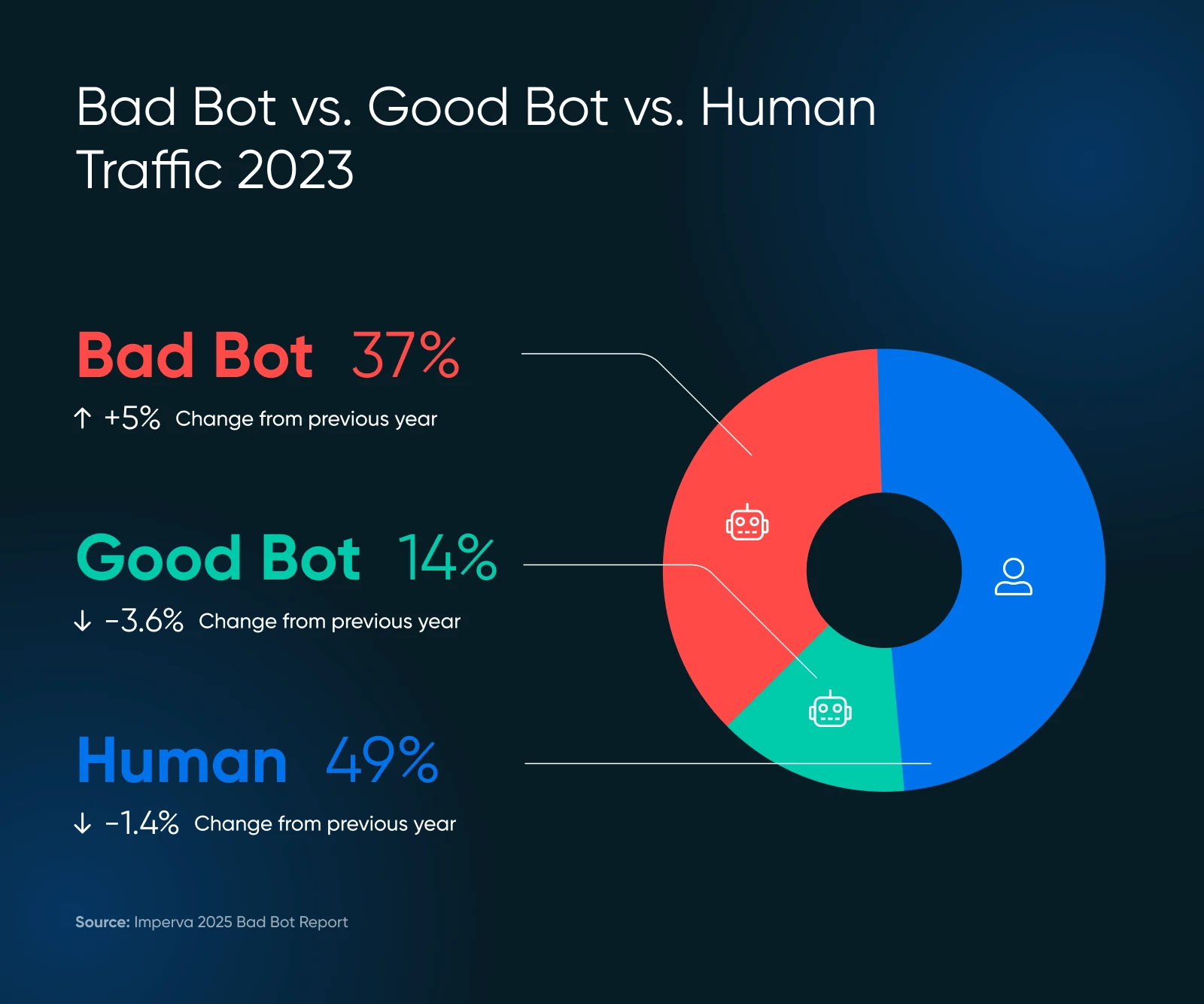

Unsere Ergebnisse stimmen gut mit dem Imperva’s Bad Bot Report 2025 überein, in dem 51% des gesamten Internetverkehrs nun von automatisierten Quellen stammen, von denen 37% als bösartige Bots eingestuft werden.

Die Herausforderung liegt im Graubereich.

Einige KI-Trainings-Crawler (wie GPTBot) sammeln Deine Inhalte, um Sprachmodelle zu trainieren, ohne direkte Traffic-Vorteile für Deine Website zu bieten.

Ob diese „gute“ oder „schlechte“ Bots darstellen, hängt davon ab, wie Du über KI-Unternehmen denkst, die Deine Inhalte für kommerzielle Zwecke verwenden.

Gute Bots vs. Schlechte Bots: Was ist der Unterschied

Nicht aller automatisierte Verkehr verdient eine Blockierung. Du musst wissen, welche Bots Deinem Geschäft helfen und welche es schädigen, bevor Du Maßnahmen ergreifst, um Bots auf Deiner Webseite zu verwalten.

Gute Bots, Die Deiner Seite Nutzen

- Suchmaschinen-Crawler: Beispielsweise indexieren Googlebot und Bingbot deine Inhalte für Suchergebnisse.

- Social Media Bots: Wie FacebookExternalAgent generieren Link-Vorschauen, wenn Nutzer deine Inhalte teilen.

- Überwachungsdienste: Diese überprüfen die Betriebszeit und Leistung deiner Website.

- AI-Such-Crawler: Wie ChatGPT-User und Perplexity-User, die deine Inhalte zitieren, wenn sie Benutzeranfragen beantworten.

Schlechte Bots, Die Deine Ressourcen Verbrauchen

- Content-Scraper: Sie stehlen deine Artikel, Produktbeschreibungen und Bilder.

- Formular-Spam-Bots: Sie fluten Kontaktformulare mit Junk-Einreichungen.

- Preisüberwachungs-Bots: Von Konkurrenten, die deine Preisstrategien verfolgen.

- Warenkorb-Hortungs-Bots: Diese fügen Produkte zu Warenkörben hinzu, ohne sie zu kaufen.

- Credential-Stuffing-Bots: Sie versuchen, in Benutzerkonten einzudringen.

Die Versteckten Kosten, Die Deine Kleine Unternehmensseite Treffen

Unabhängig vom Typ des Bots beeinflusst automatisierter Verkehr Deine Website in drei kritischen Bereichen:

- Hostingkosten

- Sicherheitsrisiken

- Datengenauigkeit

Jeder Bot-Besuch verbraucht Serverressourcen genau wie ein menschlicher Besucher, jedoch ohne Potenzial für Konversionen, Engagement oder Umsatz.

1. Deine Infrastrukturkosten Steigen Weiter

Jede Bot-Anfrage verwendet deine Bandbreite, Rechenleistung und Speicher.

Wenn Du eine inhaltsreiche Website oder eine E-Commerce-Plattform hast, wirst Du wahrscheinlich schnell eine Belastung für Dein Portemonnaie feststellen.

Das Projekt Read the Docs reduzierte den Verkehr um 75% nach dem Blockieren von AI-Crawlern und ging von täglich 800GB auf 200GB über, wodurch monatlich 1.500 $ an Bandbreitenkosten eingespart wurden.

Wenn Du einen Shared Hosting Plan hast, wirst Du keine direkten Kosten sehen.

Übermäßiger Bot-Verkehr kann jedoch dazu führen, dass dein Host die Leistung deiner Website drosselt. Aggressiveres Bot-Verhalten kann dich früher als geplant zu einer VPS oder dedizierten Hosting-Lösung drängen.

2. Sicherheits- und Spamprobleme verschlimmern sich

Bösartige Bots zielen auf deine Kontaktformulare, Anmeldeseiten und Checkout-Prozesse.

Sie suchen nach Schwachstellen, versuchen Angriffe durch Credential Stuffing und fluten Formulare mit sinnlosen Einreichungen. Da die meisten Webseiten nur über grundlegende Sicherheit verfügen, werden sie zu einem attraktiven Ziel.

Wenn deine Kontaktformulare oder Blog-Kommentare Spam-Einträge haben, würde ich dir sofort empfehlen, Askimet zu installieren, um zu sehen, dass die Spam-Einträge zurückgehen. Denke jedoch daran, dass Askimet keinen Bot-Traffic blockiert.

Du musst selbst Maßnahmen ergreifen, um Bots zu blockieren (mehr dazu in Kürze).

3. Deine Analyse-Daten Werden Verunreinigt

Bot-Verkehr verfälscht Deine Website-Analytik.

Wenn Bots Seiten besuchen, interagieren sie nicht mit Inhalten und erzeugen künstlich hohe Besucherzahlen mit null Konversionsraten.

Diese Verunreinigung macht es fast unmöglich für Dich, echtes Nutzerverhalten zu messen, Konversions-Trichter zu optimieren oder datengesteuerte Marketingentscheidungen zu treffen.

Und selbst wenn Google Analytics es Dir ermöglicht, den Verkehr zu filtern, um die Analyse einzugrenzen, ist es schwierig, Bot-Verkehr von regulären menschlichen Besuchern zu unterscheiden.

Wo Man Bot-Traffic Auf Deiner Seite Findet

Derzeit gibt es keinen narrensicheren Weg, um den gesamten Bot-Verkehr zu ermitteln, da fortgeschrittene Bots von menschlichen Besuchern praktisch nicht zu unterscheiden sind.

Aber es gibt bestimmte Schritte, die Du unternehmen kannst, um mit dem Monitoring zu beginnen.

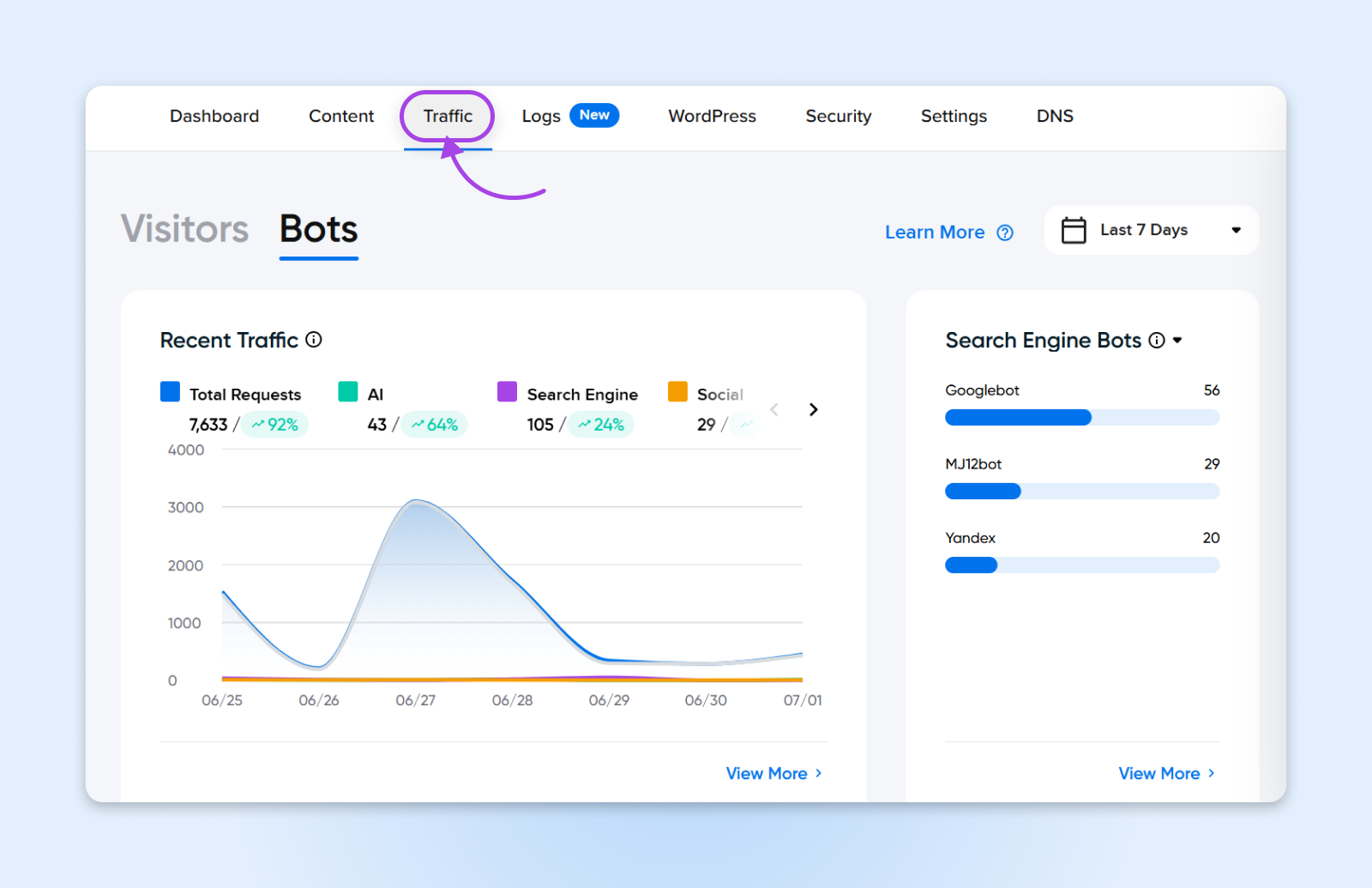

1. Starte Mit Dem Traffic-Dashboard Des DreamHost Panels

Wenn Du bei DreamHost hostest, bist Du bereits einen Schritt voraus. Der Traffic-Tab in Deinem DreamHost-Panel bietet Dir einen klaren Überblick über das Traffic-Verhalten, einschließlich des Verhaltens von Bots. Du kannst Spitzen überwachen, Anomalien erkennen und verfolgen, wie viele Bots möglicherweise Deine Seite beeinflussen, alles ohne die Notwendigkeit eines Drittanbieter-Tools.

Unser Panel hilft dir:

- Unterscheide auf einen Blick zwischen menschlichem und Bot-Verkehr

- Betrachte den Verkehr nach IP, Referrer oder Benutzeragent

- Erkenne frühzeitig Muster, damit Du schnell handeln kannst

Dies ist besonders hilfreich für Nutzer, die eingebaute Werkzeuge gegenüber komplizierten Dashboards bevorzugen. Bonus – Es ist keine zusätzliche Konfiguration erforderlich!

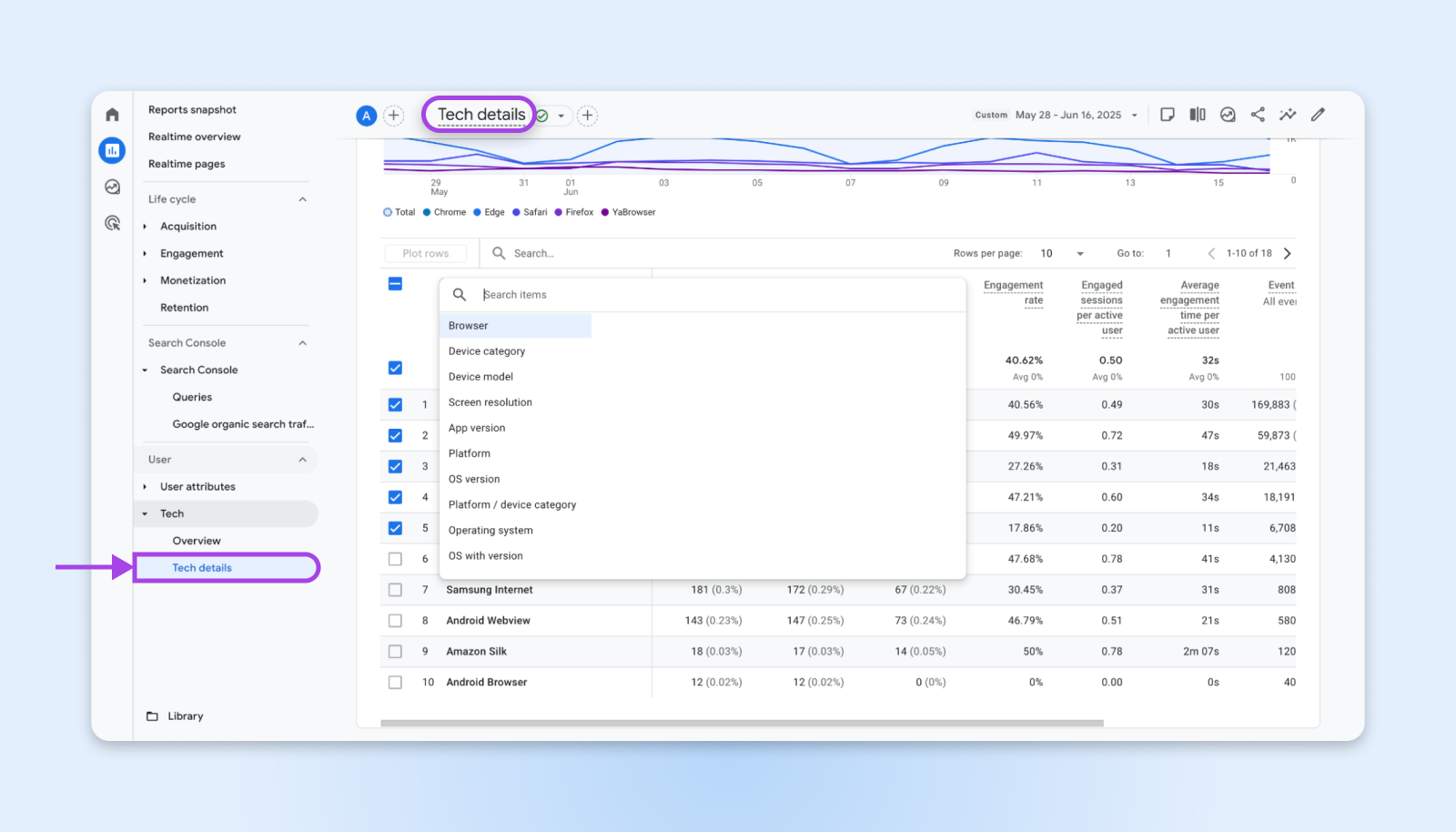

2. Vertiefe Dich Mit Google Analytics

Sieh dir dein Google Analytics Dashboard für diese eindeutigen Anzeichen von starker Bot-Aktivität an:

- Verkehrsspitzen mit entsprechendem Anstieg der Absprungrate

- Hohe Seitenaufrufe mit null Zeit auf der Seite

- Ungewöhnliche geografische Verkehrsmuster (plötzlicher Verkehr aus Ländern, in denen Du nicht tätig bist)

- Referrer-Spam von unbekannten Domains

Geh zu Berichte → Tech und verwende die technische Filterung von GA4, um die Nutzertechnologie einzugrenzen.

Hier kannst Du anfangen, nach Browser und Betriebssystem, Bildschirmauflösungen, Gerät, App-Versionen usw. zu filtern. Wonach Du suchst, sind ungewöhnliche Browser, seltsame Betriebssysteme und ungewöhnliche Bildschirmauflösungen wie:

- 1024 x 768

- 1366 x 768

- 1600 x 864

- 800 x 600

- 1600 x 1200

- 1024 x 667

- Nicht spezifiziert

Dies würde einige echte Besucher aus deinem Tracking ausschließen, aber du würdest auch deutlich weniger Bot-Einträge in den Analyse-Daten sehen.

Hinweis: Fortgeschrittene Bots können normale Auflösungen und die neuesten Geräteversionen nutzen, um ihre Aktivitäten zu tarnen. Diese sind äußerst schwer zu filtern, es sei denn, Du beginnst damit, Besucher zu überprüfen, bevor sie Deine Webseite sehen können.

3. Überprüfe Deine Serverprotokolle

Wenn Du Zugang zu Deinem Hosting Control Panel hast, schaue in die Serverzugriffsprotokolle, um Muster zu erkennen, die auf automatisierten Verkehr hinweisen:

- Schnellfeueranfragen von einzelnen IP-Adressen.

- Anfragen an nicht existierende Seiten (oft Bots, die nach Schwachstellen suchen).

- User-Agents, die sich als bekannte Crawler identifizieren (sowohl gute als auch schlechte).

- Anfragen ohne Referrer-Informationen.

Viele Hosting-Anbieter, einschließlich DreamHost, bieten Analysewerkzeuge für Protokolle in ihren Bedienfeldern an. Achte auf ungewöhnliche Spitzen im Bandbreitenverbrauch, die nicht mit Marketingkampagnen oder Inhaltsaktualisierungen übereinstimmen.

Sobald Du eine Liste von IP-Adressen hast, die wiederholt auffällig sind, kannst Du beginnen, die IP-Adressen entweder von Deinem Webserver, wie NGINX oder Apache, oder von einem CDN zu blockieren.

CDN

CDN ist die Abkürzung für u201cContent Delivery Networku201d. Es bezieht sich auf ein geografisch verteiltes Netzwerk von Webservern (und deren Rechenzentren). Die Einheiten, die ein CDN bilden, arbeiten zusammen, um eine schnelle Inhaltsauslieferung über das Internet zu gewährleisten.

Mehr Lesen4. Verwende Drittanbieter-Überwachungstools

Manchmal kannst Du nur so viel Traffic identifizieren. Deshalb gibt es kostenlose, externe Tools wie Cloudflare Analytics (wenn Du deren Dienst nutzt), die Aufschlüsselungen des Bot-Traffics bieten.

Es gibt auch andere umfassende Apps wie:

- Wordfence: Für WordPress-Seiten; erkennt Versuche von schädlichen Bots

- Sucuri: Bietet Firewall-Dienste für Websites mit Bot-Erkennung

- MonsterInsights: Stellt erweiterte Berichterstattung über Google Analytics mit Bot-Filterung bereit

Verwalten Und Blockieren Von Schlechten Bots, Ohne Die Guten Zu Beeinträchtigen

Ich empfehle, vorsichtig beim Blockieren von Bot-Traffic zu sein, da du auch versehentlich echte Benutzer blockieren könntest. Zudem benötigst du einen ausgewogenen Ansatz, der schädlichen automatisierten Traffic blockiert, während nützliche Crawler erhalten bleiben.

Hier ist, wie ich die Bot-Verwaltung implementieren würde, ohne versehentlich Suchmaschinen oder legitime Dienste zu blockieren.

Richte Deine robots.txt-Datei Ein

Deine robots.txt-Datei dient als erste Verteidigungslinie gegen unerwünschte Crawler.

Erstelle oder aktualisiere die Datei im Root-Verzeichnis deiner Website mit spezifischen Anweisungen für verschiedene Bot-Typen:

# Blockiere das Training von AI-Crawlern

User-agent: GPTBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Google-Extended

Disallow: /

# Erlaube Suchmaschinen

User-agent: Googlebot

Allow: /

User-agent: Bingbot

Allow: /

# Erlaube AI-Suchbots, die Quellen angeben

User-agent: ChatGPT-User

Allow: /

User-agent: PerplexityBot

Allow: /Wenn Du keinen direkten Zugang zur robots.txt-Datei hast und WordPress verwendest, könntest Du versuchen, das WP Robots Txt-Plugin zu verwenden, das es Dir ermöglicht, die Datei von Deinem WordPress-Dashboard aus zu bearbeiten.

Denke daran, dass robots.txt auf einem Ehrensystem basiert. Gutartige Crawler respektieren diese Direktiven, aber bösartige Bots ignorieren die Datei oft vollständig.

Implementiere eine Website-Firewall

Für eine aggressivere Website-Sicherheit implementiere eine Web Application Firewall (WAF), die Bots auf Serverebene blockieren kann.

Du hast auch ein paar weitere Optionen als Kleinunternehmer, der Websites mit geringem Volumen verwaltet.

Cloudflare Kostenloser Tarif:

- Bietet grundlegende Bot-Abwehrfähigkeiten

- Blockiert offensichtlichen Schadverkehr automatisch

- Bietet anpassbare Firewall-Regeln für spezifische Bedrohungen

Wordfence (WordPress-Benutzer):

- Beinhaltet Bot-Erkennung und Blockierfunktionen

- Echtzeit-Updates der Bedrohungsintelligenz

- Anpassbare Ratenbegrenzung zur Verhinderung von Schnellfeuer-Anfragen

Serverseitige Ratenbegrenzung

Viele Hosting-Anbieter bieten Funktionen zur Ratenbegrenzung an, die automatisch IP-Adressen verlangsamen oder blockieren, die zu viele Anfragen in kurzen Zeitrahmen stellen. Du kannst diese Ratenbegrenzer so konfigurieren, dass sie IP-Adressen blockieren, die in sehr kurzer Zeit zu viele Seiten aufrufen.

Zum Beispiel würde eine normale Person ein paar Sekunden brauchen, um auf einer Seite herumzuschauen, bevor sie auf verschiedene Links klickt. Ein Bot würde dafür nur Millisekunden benötigen.

Plugin-Lösungen für WordPress-Seiten

Wenn Du WordPress verwendest, hast Du zusätzliche Optionen für die Bot-Verwaltung:

- Akismet: Filtert automatisch Kommentare und Formular-Spam mit einer Genauigkeit von 99,99% durch fortgeschrittene KI-Filterung. Unverzichtbar für jede WordPress-Seite, die Nutzereingaben akzeptiert.

- WP Cerber Security: Bietet umfassenden Bot-Schutz, einschließlich Limitierung von Anmeldeversuchen, IP-Blockierung und fortschrittlichen Algorithmen zur Bot-Erkennung.

- All-In-One Security (AIOS): Bietet Firewall-Funktionen und Bot-Blockierungsmöglichkeiten, die für kleine Unternehmenswebseiten geeignet sind.

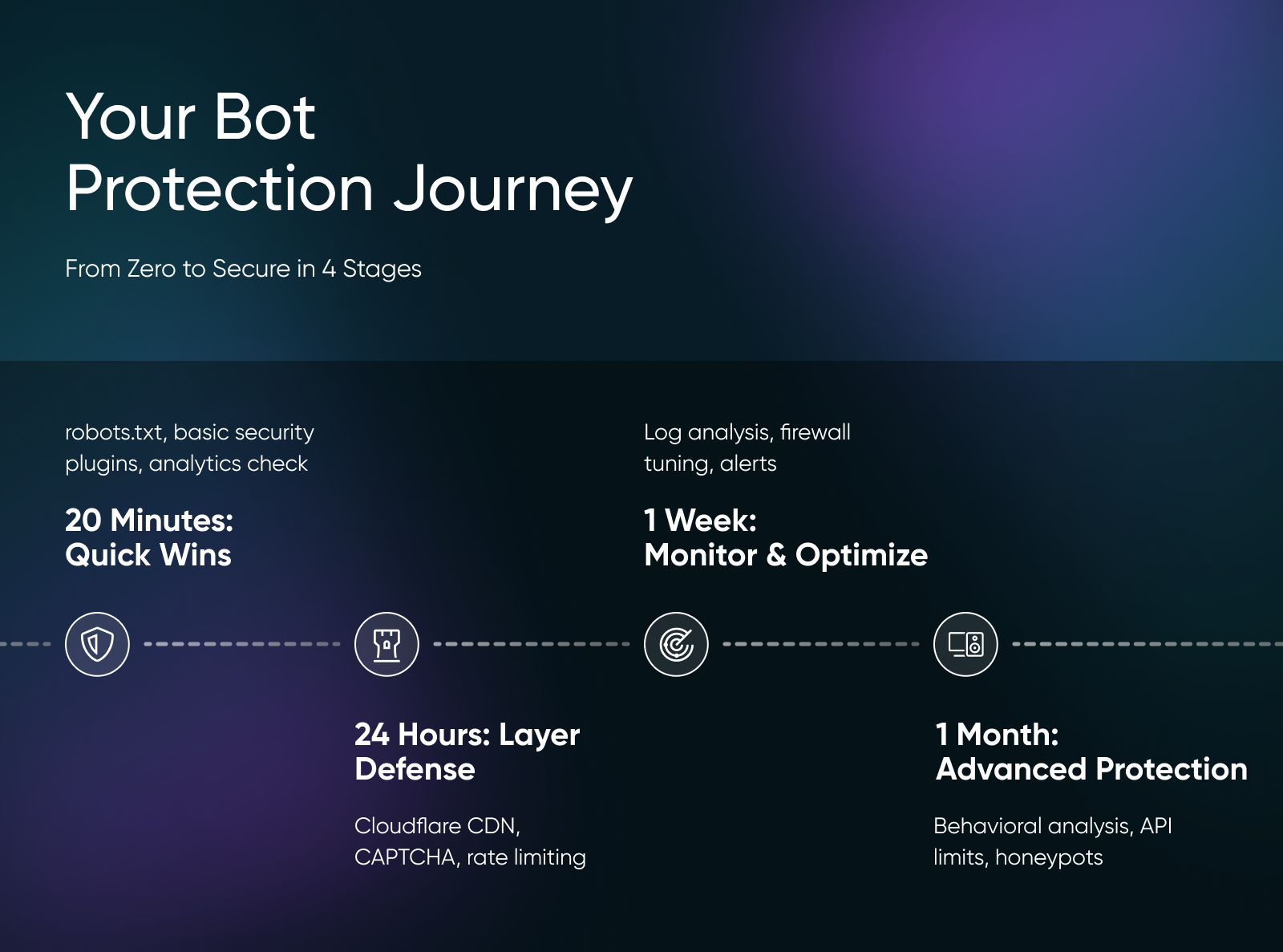

Dein Kompletter Umsetzungspfad Für Bot-Schutz

Ich habe diesen Implementierungsplan so aufgeteilt, dass er in enge Zeitpläne passt und dir hilft, von keiner Absicherung zu einer funktionierenden Bot-Abwehr in kurzer Zeit zu gelangen.

20 Minuten: Schnelle Erfolge

- Aktualisiere die robots.txt Datei

- Aktiviere grundlegende Sicherheits-Plugins

- Überprüfe Google Analytics auf Bot-Muster

Beginne mit deiner robots.txt-Datei, denn das ist der einfachste erste Schritt. Melde dich beim Dateimanager deiner Website an (oder verwende FTP) und erstelle oder aktualisiere die robots.txt-Datei in deinem Root-Verzeichnis. Kopiere die robots.txt-Konfiguration aus dem früheren Teil dieses Artikels und füge sie ein.

Wenn Du WordPress verwendest, installiere und aktiviere sofort das Wordfence Sicherheits-Plugin. Die kostenlose Version beinhaltet grundlegenden Bot-Schutz und beginnt sofort, offensichtlich böswilligen Verkehr zu blockieren.

Öffne Google Analytics, um Deine Traffic-Quellen auf ungewöhnliche Muster zu überprüfen. Suche nach Ländern, die Du nicht bedienst, plötzlichen Traffic-Spitzen oder hohen Absprungraten mit null Sitzungsdauer.

24 Stunden: Schichte Deine Verteidigung

- Richte ein kostenloses Cloudflare-Konto ein

- Konfiguriere die Ratenbegrenzung

- Füge CAPTCHA zu Formularen hinzu

- Aktiviere die Kommentarmoderation

Registriere dich für ein kostenloses Cloudflare-Konto und füge deine Website hinzu. Cloudflare steht zwischen deiner Website und den Besuchern und blockiert automatisch offensichtlichen Bot-Verkehr, bevor er deinen Server erreicht. Die Einrichtung dauert etwa 30 Minuten und beinhaltet das Ändern der DNS-Einstellungen, aber Cloudflare führt dich durch jeden Schritt.

Stelle die Ratenbegrenzung über Deinen Host ein, um automatisch IP-Adressen, die zu viele Anfragen stellen, zu verlangsamen oder zu blockieren. Konfiguriere Grenzen, die normales Surfen erlauben (einige Sekunden pro Seite), aber aggressive Crawler stoppen (mehrere Seiten pro Sekunde).

Füge CAPTCHA zu anfälligen Formularen mit dem reCAPTCHA Plugin für WordPress oder Cloudflare Turnstile hinzu. Füge unsichtbares CAPTCHA zu Kontaktformularen, Kommentarbereichen und Benutzerregistrierungsseiten hinzu, um automatisierte Einreichungen zu stoppen, ohne echte Nutzer zu stören.

Eine Woche: Überwachen und Optimieren

- Serverprotokolle analysieren

- Firewall-Regeln feinabstimmen

- Überwachungsalarme einrichten

- Problematische IP-Bereiche blockieren

Analyisiere die Zugriffsprotokolle deines Servers, um Bot-Muster zu identifizieren, die spezifisch für deine Webseite sind. Suche nach schnell aufeinanderfolgenden Anfragen von einzelnen IP-Adressen, Anfragen an nicht existierende Seiten und verdächtigen User-Agent-Strings. Die meisten Hosting-Kontrollpanels beinhalten Analysewerkzeuge für Protokolle, die dies erleichtern.

Verwende diese Daten, um benutzerdefinierte Firewall-Regeln in Cloudflare oder deinem Sicherheits-Plugin zu erstellen. Zum Beispiel, wenn Du bemerkst, dass Bots aus bestimmten Ländern immer wieder Probleme verursachen, kannst Du ganze geografische Regionen blockieren. Oder wenn bestimmte User-Agents deine Seite aggressiv angreifen, blockiere diese spezifischen Strings.

Richte Überwachungsalarme ein, damit Du weißt, wann Spitzen im Bot-Verkehr auftreten. Werkzeuge wie UptimeRobot oder Pingdom können Dich über ungewöhnliche Verkehrsmuster, langsame Ladezeiten oder Spitzen bei den Serverressourcen alarmieren, die auf einen Bot-Angriff hindeuten könnten.

Ein Monat: Erweiterter Schutz

- Verhaltensanalyse implementieren

- API-Anfragenbegrenzung einführen

- CDN-Caching einrichten

- Bot-Honeypots erstellen

Füge Verhaltensanalyse-Tools wie DataDome oder Imperva hinzu, die Bots durch die Analyse von Mausbewegungen, Tippmustern und der Interaktionszeit auf der Seite erkennen. Diese fangen ausgeklügelte Bots ab, die menschliches Verhalten nachahmen.

Verwende ein CDN, um statische Ressourcen aggressiv zu cachen. Auf diese Weise trifft der Bot-Verkehr auf den Cache und nicht auf deinen Host, was die Last durch wiederholte Anfragen reduziert.

Eine meiner Lieblingstechniken ist das Erstellen von Bot-Honeypots. Wenn Du viel Formular-Spam bemerkst, füge dem Formular ein zusätzliches, verstecktes Feld hinzu. Da Bots das HTML der Seite betrachten, während sie Formulare ausfüllen, werden sie dieses versteckte Feld sehen und einige Daten hinzufügen. Du kannst alle Formulareinträge, die Text im versteckten Feld haben, sicher löschen, da ein menschlicher Besucher es nicht sehen kann.

Die Zukunft Des Bot-Verkehrsmanagements

Der Bot-Verkehr verschwindet nicht. Mit 71,5% der Besuche in unserem Netzwerk, die von automatisierten Quellen stammen, übersteigt die Anzahl der Roboter die der Menschen im Internet nun 3 zu 1.

Aber während die meisten Website-Besitzer noch herausfinden, was passiert, hast Du alles, was Du brauchst, um dieses Bot-Chaos für Dein Geschäft zu wenden und sogar von den guten Bots zu profitieren.

Gehe also voran und beginne damit, Bot-Management-Systeme zu implementieren, während deine Konkurrenz immer noch in Panik über den gefälschten Traffic ist!