Na każdego człowieka odwiedzającego twoją stronę przypada 3 boty.

Zaskoczeni? My też.

Ale według naszych wewnętrznych danych, od stycznia 2025 roku obserwowaliśmy średnio 71,5% ruchu botów.

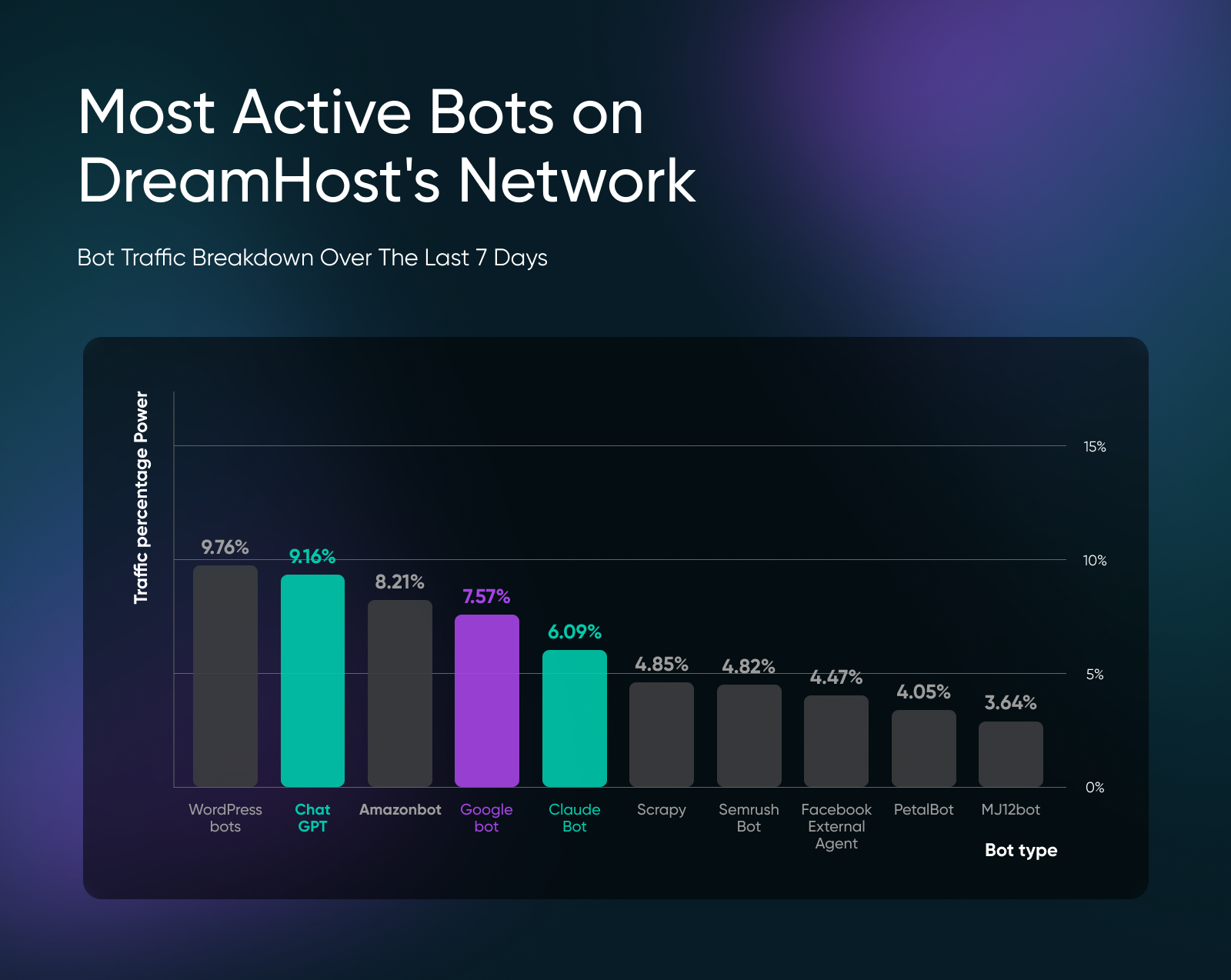

Roboty indeksujące od ChatGPT (9,16%), Claude (6,09%) oraz inne LLM regularnie pojawiają się w naszych danych ruchu botów, podczas gdy roboty wyszukiwarek takie jak Googlebot stanowią tylko 7,57% ruchu.

Nie możemy zablokować wszystkich, ponieważ większość botów jest niezbędna. Na przykład Googlebot pomaga Twojej stronie pojawiać się w wyszukiwaniu, a bot ChatGPT cytuję Twoją markę jako źródło w odpowiedziach.

Ale jeśli zauważasz wzrosty ruchu lub wpisy spamowe w formularzach kontaktowych, to wtedy musisz podjąć działania.

Jak Duży Jest Przyrost Ruchu od Botów?

Oto podział ruchu botów, który obserwujemy na stronach naszych klientów w sieci DreamHost:

Obserwowane przez nas wzorce geograficzne są również bardzo interesujące.

Irlandia przoduje w ruchu botów, stanowiąc 40,70% dziennych wizyt, a następnie Singapur – 13,04%. Ta geograficzna koncentracja nie jest przypadkowa.

Irlandia jest siedzibą europejskich głównych biur prawie każdej dużej amerykańskiej firmy technologicznej – Google, Apple, Microsoft, Amazon i Facebook – przyciąganych dostępem do UE, niskimi podatkami korporacyjnymi oraz anglojęzyczną siłą roboczą.

Tymczasem Singapur jest azjatycko-pacyficznym centrum danych, z głównymi obiektami prowadzonymi przez AWS, Microsoft Azure i Google Cloud, które obsługują rynki azjatyckie zapewniając niższe opóźnienia. Kiedy roboty indeksujące i usługi w chmurze skanują strony internetowe, często działają one z farm serwerów skoncentrowanych w tych dwóch strategicznych lokalizacjach.

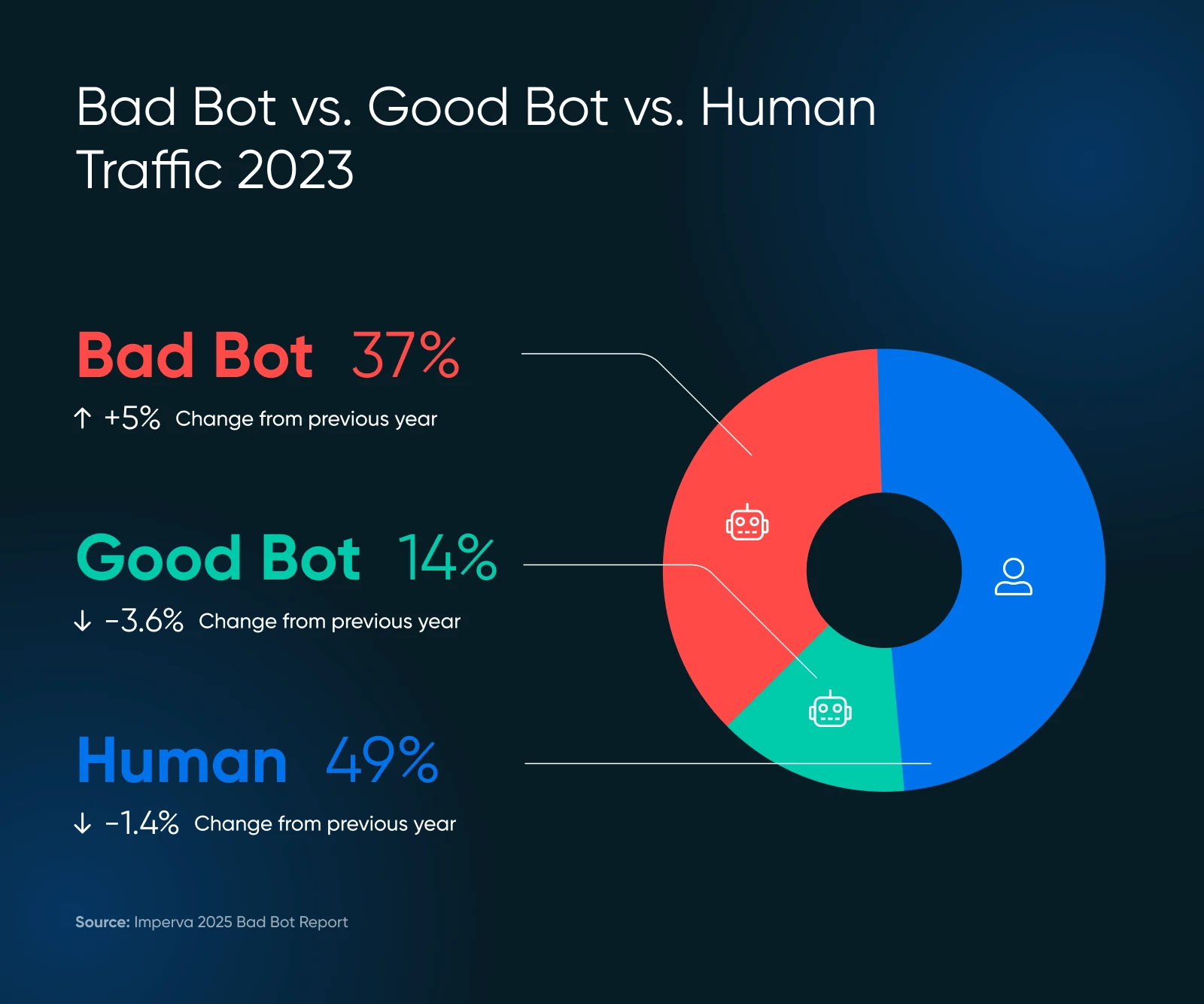

Nasze wyniki są całkiem zgodne z raportem Imperva na temat złych botów z 2025 roku, gdzie 51% całego ruchu internetowego pochodzi obecnie ze źródeł zautomatyzowanych, z czego 37% klasyfikuje się jako złośliwe boty.

Wyzwanie leży w szarej strefie.

Niektóre roboty indeksujące do trenowania SI (jak GPTBot) zbierają twoje treści, aby trenować modele językowe, nie przynosząc bezpośrednich korzyści z ruchu z powrotem na twoją stronę.

Ale czy te reprezentują „dobre” czy „złe” boty zależy od tego, jak czujesz się z tym, że firmy AI wykorzystują Twoje treści do celów komercyjnych.

Dobre Boty vs. Złe Boty: Jaka Jest Różnica

Nie wszystkie automatyczne ruchy zasługują na blokadę. Musisz wiedzieć, które boty pomagają Twojej firmie, a które jej szkodzą, zanim podejmiesz jakiekolwiek działania w celu zarządzania botami na swojej stronie.

Dobre Boty, Które Korzystają Na Twojej Stronie

- Roboty indeksujące wyszukiwarek: Na przykład Googlebot i Bingbot indeksują Twoje treści w wynikach wyszukiwania.

- Boty mediów społecznościowych: Jak FacebookExternalAgent, generują podglądy linków, gdy użytkownicy udostępniają Twoje treści.

- Usługi monitorujące: Sprawdzają dostępność i wydajność Twojej strony.

- AI roboty indeksujące: Jak ChatGPT-User i Perplexity-User, które cytują Twoje treści podczas odpowiadania na zapytania użytkowników.

Złe Boty, Które Wyczerpują Twoje Zasoby

- Roboty kopiące treści: Kradną twoje artykuły, opisy produktów oraz obrazy.

- Roboty spamujące formularze: Zalewają formularze kontaktowe niechcianymi zgłoszeniami.

- Roboty monitorujące ceny: Pochodzą od konkurentów śledzących twoje strategie cenowe.

- Roboty blokujące zapasy: Dodają produkty do koszyków bez dokonywania zakupu.

- Roboty atakujące dane logowania: Próbują włamać się na konta użytkowników.

Ukryte Koszty Uderzające w Twoją Małą Firmę

Niezależnie od rodzaju bota, automatyczny ruch wpływa na Twoją stronę w trzech kluczowych obszarach:

- Koszty hostingu

- Ryzyko bezpieczeństwa

- Dokładność danych

Każda wizyta bota zużywa zasoby serwera tak samo jak wizyta człowieka, ale bez żadnego potencjału na konwersje, zaangażowanie czy przychody.

1. Koszty Twojej Infrastruktury Nieustannie Rosną

Każde żądanie bota wykorzystuje twoją przepustowość, moc obliczeniową i pamięć.

Jeśli posiadasz stronę z dużą ilością treści lub platformę e-commerce, szybko odczujesz to w swoim portfelu.

Projekt Read the Docs zmniejszył ruch o 75% po zablokowaniu robotów indeksujących AI i przeszedł z serwowania 800GB do 200GB dziennie, oszczędzając 1500 dolarów miesięcznie na kosztach przepustowości.

Jeśli korzystasz z planu Shared Hosting, nie zobaczysz bezpośrednich kosztów.

Nadmierne ruchy botów mogą spowodować, że twój host ograniczy wydajność strony. Bardziej agresywne działanie botów może zmusić cię do wcześniejszego przechodzenia na rozwiązania VPS lub dedicated hosting niż planowałeś.

2. Problemy z Bezpieczeństwem i Spamem Nasilają Się

Złośliwe boty atakują twoje formularze kontaktowe, strony logowania i procesy zakupów.

Szukają luk w zabezpieczeniach, przeprowadzają ataki typu credential stuffing oraz zalewają formularze śmieciowymi zgłoszeniami. Ponieważ większość stron internetowych posiada tylko podstawowe zabezpieczenia, stają się atrakcyjnym celem.

Jeśli Twoje formularze kontaktowe lub komentarze na blogu mają wpisy ze spamem, sugeruję natychmiast zainstalować Askimet, aby zobaczyć, czy ilość spamu się zmniejszy. Pamiętaj jednak, że Askimet nie blokuje ruchu od botów.

Musisz sam podjąć kroki, aby zablokować boty (więcej na ten temat za chwilę).

3. Twoje dane analityczne zostają skażone

Ruch botów zakłóca analizy Twojej strony internetowej.

Gdy boty odwiedzają strony, nie angażują się w treści, generując sztucznie wysokie liczby ruchu przy zerowych wskaźnikach konwersji.

To zanieczyszczenie sprawia, że niemal niemożliwe jest zmierzenie rzeczywistego zachowania użytkowników, optymalizacja lejków konwersji czy podejmowanie decyzji marketingowych opartych na danych.

A nawet jeśli Google Analytics pozwala Ci filtrować ruch, aby zawęzić analizę, trudno jest odróżnić ruch botów od zwykłych ludzkich odwiedzających.

Gdzie szukać ruchu od botów na twojej stronie

Obecnie nie ma niezawodnego sposobu na znalezienie wszystkich ruchów botów, ponieważ zaawansowane boty są praktycznie nie do odróżnienia od ludzkich odwiedzających.

Ale są pewne kroki, które możesz podjąć, aby zacząć monitorowanie.

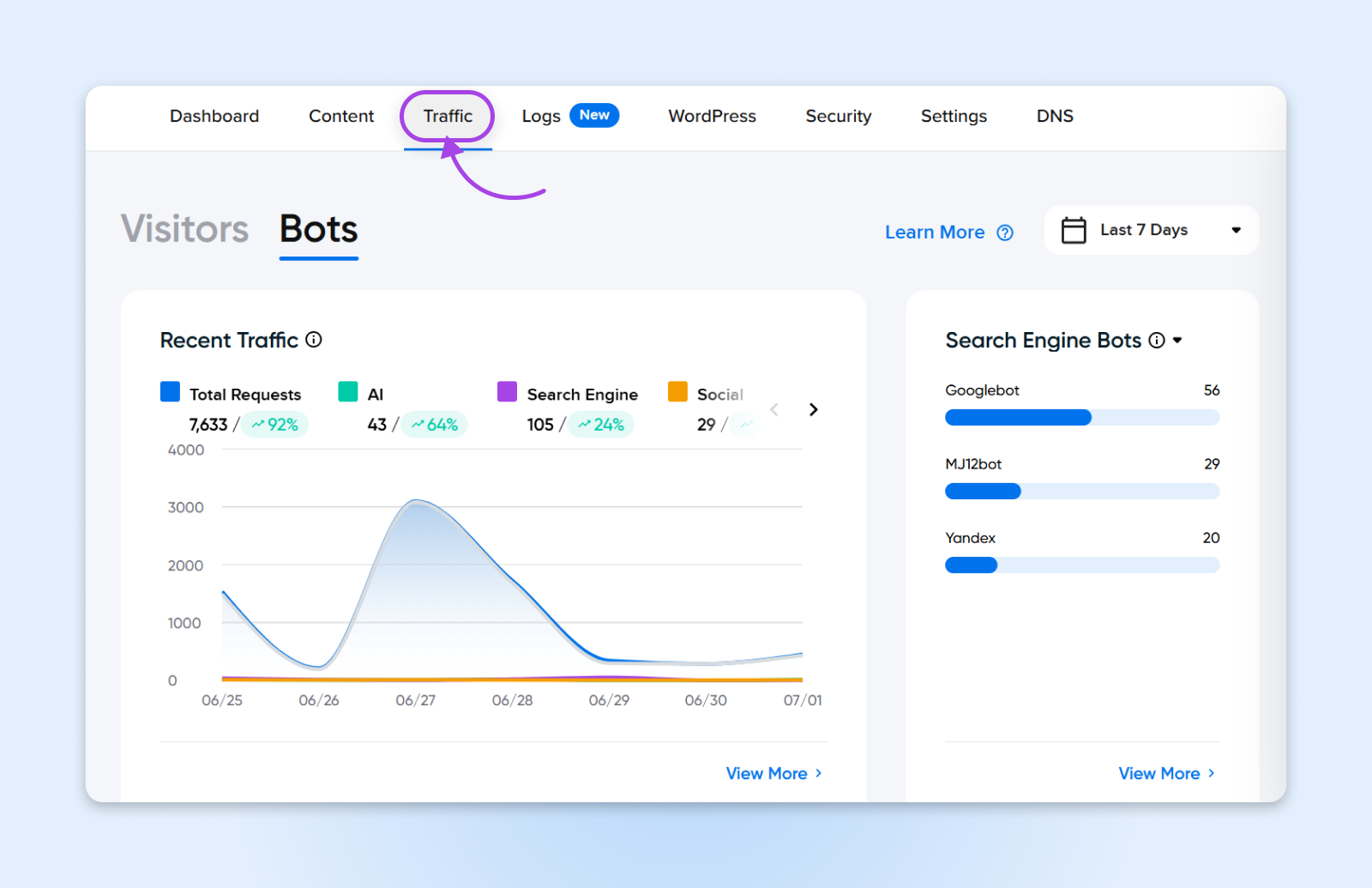

1. Zacznij od Panelu Sterowania Ruchem w DreamHost

Jeśli hostujesz z DreamHost, jesteś już o krok do przodu. Zakładka Traffic w twoim panelu DreamHost daje ci wyraźny obraz aktywności ruchu, w tym zachowania botów. Możesz monitorować szczyty, wykrywać anomalie i śledzić, ile botów może wpływać na twoją stronę, wszystko to bez potrzeby używania narzędzia stron trzecich.

Nasz panel pomaga ci:

- Rozróżnij ruch ludzi i botów na pierwszy rzut oka

- Przeglądaj ruch według IP, strony odsyłającej lub agenta użytkownika

- Dostrzegaj wzorce wcześnie, aby móc szybko podjąć działania

To jest szczególnie pomocne dla użytkowników, którzy wolą wbudowane narzędzia od skomplikowanych paneli sterowania. Dodatkowo – nie jest potrzebna żadna dodatkowa konfiguracja!

2. Zgłębiaj z Google Analytics

Spójrz na swój Google Analytics panel sterowania, aby zauważyć te charakterystyczne oznaki intensywnej aktywności botów:

- Skoki ruchu wraz ze wzrostem współczynnika odrzuceń

- Wysokie liczby wyświetleń strony przy zerowym czasie spędzonym na niej

- Nietypowe wzorce ruchu geograficznego (nagły ruch z krajów, w których nie działasz)

- Spam polecający z nieznanych domen

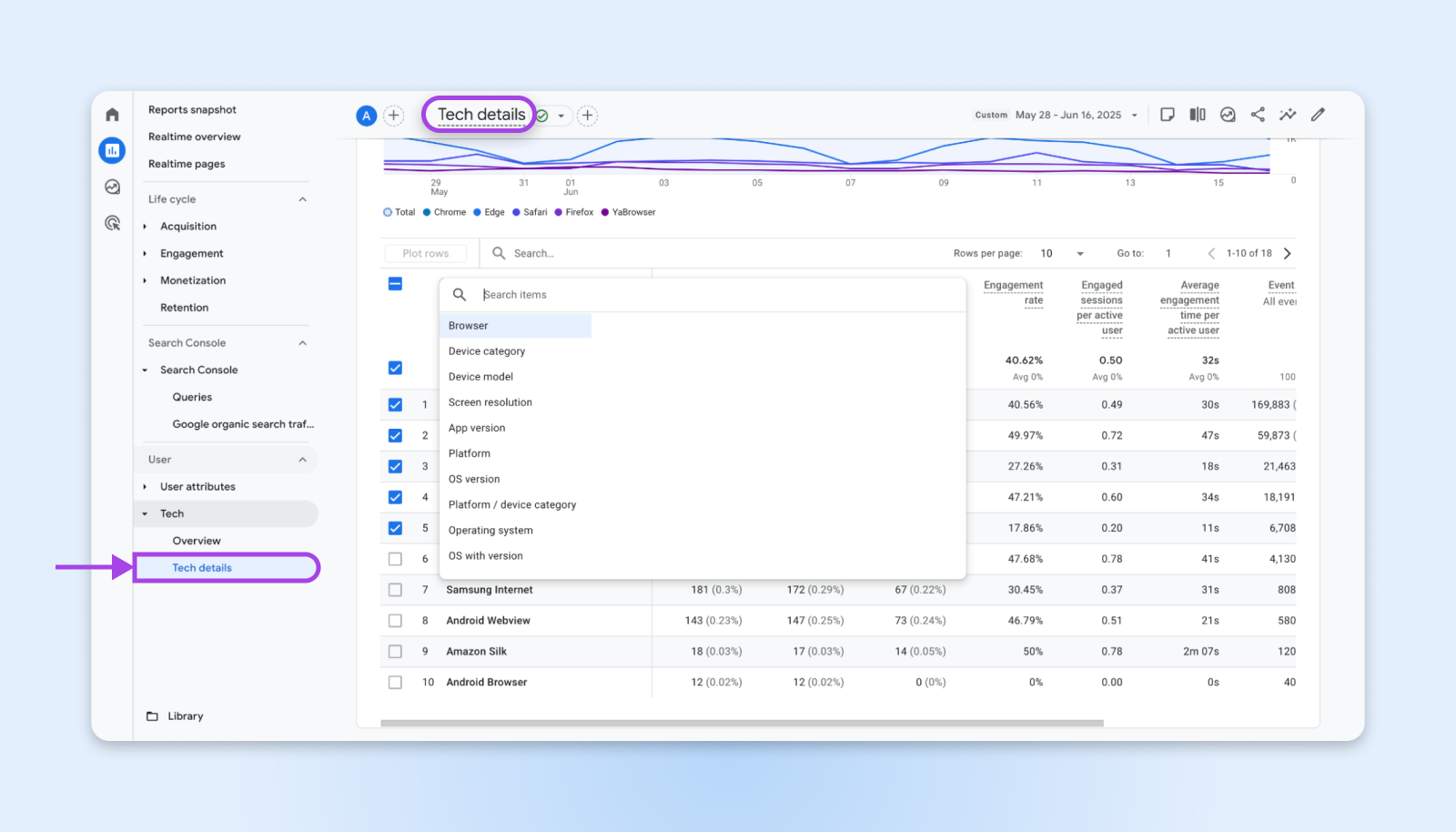

Przejdź do Raportów → Technicznych i użyj filtrowania technologicznego GA4, aby zawęzić do technologii użytkownika.

Tutaj możesz zacząć filtrować według przeglądarki i systemu operacyjnego, rozdzielczości ekranu, urządzenia, wersji aplikacji itp. Szukasz rzadkich przeglądarek, dziwnych systemów operacyjnych oraz niezwykłych rozdzielczości ekranów, takich jak:

- 1024 x 768

- 1366 x 768

- 1600 x 864

- 800 x 600

- 1600 x 1200

- 1024 x 667

- Nieokreślony

To spowoduje wyeliminowanie niektórych rzeczywistych odwiedzających z Twojego śledzenia, ale zobaczysz również znacznie mniej wpisów botów w danych analitycznych.

Uwaga: Zaawansowane boty mogą używać normalnych rozdzielczości i najnowszych wersji urządzeń, aby ukryć swoją aktywność. Są one niezwykle trudne do wyfiltrowania podczas analizy, chyba że zaczniesz przesiewać odwiedzających przed ich wejściem na Twoją stronę.

3. Sprawdź Dzienniki Serwera

Jeśli masz dostęp do swojego panelu sterowania hostingu, sprawdź dzienniki dostępu do serwera pod kątem wzorców wskazujących na automatyczny ruch:

- Szybkie żądania z pojedynczych adresów IP.

- Żądania dotyczące nieistniejących stron (często roboty szukające podatności).

- Agenci użytkownika identyfikujący się jako znane roboty indeksujące (zarówno dobre, jak i złe).

- Żądania bez informacji o źródle odniesienia.

Wiele firm hostingowych, w tym DreamHost, oferuje narzędzia do analizy dzienników w swoich panelach sterowania. Szukaj niezwykłych wzrostów zużycia przepustowości, które nie są związane z kampaniami marketingowymi lub aktualizacjami treści.

Kiedy już będziesz mieć listę adresów IP, które wydają się być powtarzającymi się sprawcami, możesz zacząć blokować te adresy IP albo z poziomu swojego serwera internetowego, jak NGINX lub Apache, albo z CDN.

CDN

CDN to skrót od u201cContent Delivery Networku201d. Odnosi się do geograficznie rozproszonej sieci serwerów internetowych (oraz ich centrów danych). Jednostki tworzące CDN współpracują, aby zapewnić szybką dostawę treści przez internet.

Czytaj Więcej4. Używaj Narzędzi Monitorujących Trzeciej Strony

Czasami można zidentyfikować tylko tyle ruchu. Dlatego istnieją darmowe narzędzia stron trzecich, takie jak Cloudflare Analytics (jeśli korzystasz z ich usługi), które dostarczają szczegółowe informacje o ruchu botów.

Są także inne kompleksowe aplikacje, takie jak:

- Wordfence: Dla stron WordPress; identyfikuje próby ataku złośliwych botów

- Sucuri: Oferuje usługi firewalla strony internetowej z wykrywaniem botów

- MonsterInsights: Zapewnia zaawansowane raportowanie Google Analytics z filtrowaniem botów

Zarządzanie i Blokowanie Złych Botów Bez Szkody Dla Dobrych

Polecam ostrożne blokowanie ruchu botów, ponieważ można przypadkowo zablokować również prawdziwych użytkowników. Potrzebujesz także zrównoważonego podejścia, które blokuje szkodliwy automatyczny ruch, jednocześnie zachowując korzystne roboty indeksujące.

Oto jak zaimplementowałbym zarządzanie botami, aby nie blokować przypadkowo wyszukiwarek lub legalnych usług.

Skonfiguruj Plik Robots.txt

Twój plik robots.txt stanowi pierwszą linię obrony przed niechcianymi robotami indeksującymi.

Utwórz lub zaktualizuj plik w katalogu głównym swojej strony internetowej z konkretnymi instrukcjami dla różnych typów botów:

# Blokuj szkoleniowe roboty AI

User-agent: GPTBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Google-Extended

Disallow: /

# Zezwalaj wyszukiwarkom

User-agent: Googlebot

Allow: /

User-agent: Bingbot

Allow: /

# Zezwalaj robotom AI wyszukującym z podaniem źródeł

User-agent: ChatGPT-User

Allow: /

User-agent: PerplexityBot

Allow: /Jeśli nie masz bezpośredniego dostępu do pliku robots.txt i korzystasz z WordPressa, możesz spróbować użyć wtyczki WP Robots Txt, która pozwala na edytowanie pliku z poziomu panelu sterowania WordPress.

Pamiętaj, że robots.txt działa na zasadzie systemu honorowego. Dobrze zachowujące się roboty przestrzegają tych dyrektyw, ale złośliwe boty często ignorują ten plik całkowicie.

Zaimplementuj Firewall Strony Internetowej

Dla bardziej zaawansowanego zabezpieczenia strony, wdrożenie Firewalla Aplikacji Webowej (WAF) może blokować Boty na poziomie serwera.

Jako właściciel małej firmy zarządzający stronami o niskim ruchu masz również kilka dodatkowych opcji.

Bezpłatny Plan Cloudflare:

- Oferuje podstawowe możliwości zwalczania botów

- Automatycznie blokuje oczywisty złośliwy ruch

- Umożliwia dostosowanie zasad firewalla dla konkretnych zagrożeń

Wordfence (Użytkownicy WordPressa):

- Zawiera funkcje wykrywania i blokowania botów

- Aktualizacje wywiadu dotyczącego zagrożeń w czasie rzeczywistym

- Dostosowywalne ograniczenie szybkości, aby zapobiegać zbyt szybkim żądaniom

Limitowanie Przepustowości na Poziomie Serwera

Wielu dostawców hostingu oferuje funkcje limitowania szybkości, które automatycznie spowalniają lub blokują adresy IP, które wysyłają zbyt wiele żądań w krótkim czasie. Możesz skonfigurować te limitery, aby blokowały adresy IP przeglądające zbyt wiele stron w bardzo krótkim czasie.

Na przykład, zwykły człowiek potrzebuje kilku sekund, aby rozejrzeć się po stronie przed kliknięciem w różne linki. Bot wykona to samo w milisekundach.

Rozwiązania Wtyczkowe Dla Stron WordPress

Jeśli używasz WordPressa, masz dodatkowe opcje zarządzania botami:

- Akismet: Automatycznie filtruje spam w komentarzach i formularzach z dokładnością 99,99% wykorzystując zaawansowane filtrowanie SI. Niezbędne dla każdej strony WordPress, która akceptuje zgłoszenia użytkowników.

- WP Cerber Security: Zapewnia kompleksową ochronę przed botami, w tym ograniczanie prób logowania, blokowanie IP oraz zaawansowane algorytmy wykrywania botów.

- All-In-One Security (AIOS): Oferuje funkcje zapory ogniowej oraz blokowanie botów, odpowiednie dla stron internetowych małych firm.

Twoja Kompletna Ścieżka Implementacji Ochrony Przed Botami

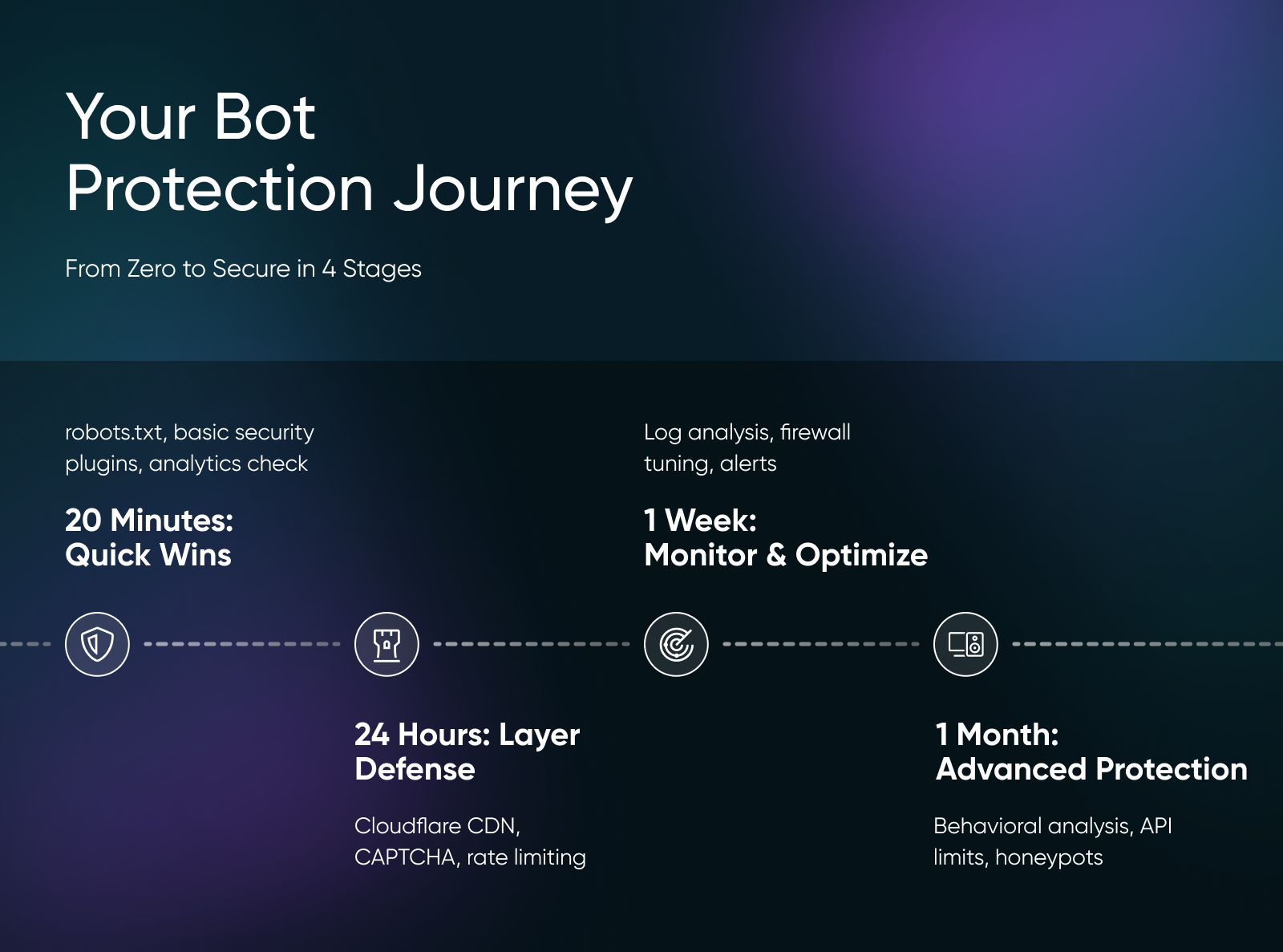

Podzieliłem ten plan wdrożenia tak, aby pasował do napiętych harmonogramów i pomógł przejść od braku ochrony do działającej obrony przed botami w krótkim czasie.

20 Minut: Szybkie Zwycięstwa

- Zaktualizuj plik robots.txt

- Włącz podstawowe wtyczki bezpieczeństwa

- Sprawdź Google Analytics pod kątem wzorców botów

Zacznij od pliku robots.txt, ponieważ to najprostszy pierwszy krok. Zaloguj się do menedżera plików swojej strony internetowej (lub użyj FTP) i utwórz lub zaktualizuj plik robots.txt w katalogu głównym. Skopiuj konfigurację robots.txt z wcześniejszej części tego artykułu i wklej ją.

Jeśli używasz WordPressa, zainstaluj i aktywuj wtyczkę zabezpieczającą Wordfence już teraz. Darmowa wersja zawiera podstawową ochronę przed botami i natychmiast zacznie blokować wyraźnie złośliwy ruch.

Otwórz Google Analytics, aby sprawdzić źródła ruchu pod kątem nietypowych wzorców. Szukaj krajów, do których nie świadczysz usług, nagłych wzrostów ruchu lub wysokich współczynników odrzuceń przy zerowym czasie trwania sesji.

24 Godziny: Warstwowa Obrona

- Załóż darmowe konto Cloudflare

- Konfiguruj ograniczenie częstotliwości

- Dodaj CAPTCHA do formularzy

- Włącz moderację komentarzy

Zarejestruj się na darmowe konto Cloudflare i dodaj swoją stronę. Cloudflare znajduje się między Twoją stroną a odwiedzającymi, automatycznie blokując oczywisty ruch botów, zanim dotrze on do Twojego serwera. Konfiguracja zajmuje około 30 minut i obejmuje zmianę ustawień DNS, ale Cloudflare prowadzi Cię przez każdy krok.

Ustaw ograniczenie szybkości na Twoim hoście, aby automatycznie spowalniać lub blokować adresy IP, które wysyłają zbyt wiele żądań. Skonfiguruj limity, które pozwalają na normalne przeglądanie (kilka sekund na stronę), ale zatrzymują agresywne roboty indeksujące (wiele stron na sekundę).

Dodaj CAPTCHA do podatnych formularzy, używając wtyczki reCAPTCHA dla WordPressa lub Cloudflare Turnstile. Dodaj niewidzialną CAPTCHĘ do formularzy kontaktowych, sekcji komentarzy i stron rejestracji użytkowników, aby zatrzymać automatyczne zgłoszenia bez denerwowania prawdziwych użytkowników.

Jeden Tydzień: Monitoruj i Optymalizuj

- Analizuj dzienniki serwera

- Dopracuj zasady firewalla

- Ustaw alerty monitoringu

- Blokuj problematyczne zakresy IP

Analizuj dzienniki dostępu do swojego serwera, aby zidentyfikować wzorce botów specyficzne dla twojej strony. Szukaj szybkich żądań z pojedynczych adresów IP, żądań do nieistniejących stron oraz podejrzanych ciągów agenta użytkownika. Większość paneli kontrolnych hostingu zawiera narzędzia do analizy dzienników, które ułatwiają to zadanie.

Użyj tych danych do stworzenia niestandardowych reguł zapory ogniowej w Cloudflare lub Twoim pluginie bezpieczeństwa. Na przykład, jeśli zauważysz, że boty z konkretnych krajów ciągle sprawiają problemy, możesz zablokować całe regiony geograficzne. Albo jeśli pewne agenty użytkownika stale agresywnie odwiedzają Twoją stronę, zablokuj te konkretne ciągi.

Skonfiguruj alerty monitorujące, aby wiedzieć, kiedy następuje wzrost ruchu botów. Narzędzia takie jak UptimeRobot lub Pingdom mogą powiadomić cię o nietypowych wzorcach ruchu, wolnych czasach ładowania lub skokach zasobów serwera, które mogą wskazywać na atak botów.

Jeden Miesiąc: Zaawansowana Ochrona

- Wprowadź analizę behawioralną

- Zaimplementuj limitowanie częstotliwości API

- Skonfiguruj pamięć podręczną CDN

- Stwórz pułapki na boty

Dodaj narzędzia do analizy zachowań takie jak DataDome czy Imperva, które wykrywają boty, analizując ruchy myszy, wzorce pisania i czas interakcji ze stroną. Pozwalają one wyłapać zaawansowane boty naśladujące zachowania ludzkie.

Korzystaj z CDN, aby agresywnie buforować zasoby statyczne. W ten sposób ruch botów trafia do pamięci podręcznej, a nie na twój host, co zmniejsza obciążenie wynikające z powtarzających się żądań.

Jedną z moich ulubionych technik jest tworzenie pułapek na boty. Jeśli zauważysz dużo spamu w formularzach, dodaj dodatkowe ukryte pole do formularza. Ponieważ boty analizują HTML strony podczas wypełniania formularzy, zobaczą to ukryte pole i wpiszą do niego jakieś dane. Możesz bezpiecznie usunąć wszystkie wpisy z formularza, które mają jakikolwiek tekst w ukrytym polu, ponieważ ludzki odwiedzający nie widzi go.

Przyszłość Zarządzania Ruchem Botów

Ruch botów nie zniknie. Z 71,5% odwiedzin naszej sieci pochodzących ze źródeł zautomatyzowanych, roboty przewyższają liczebnie ludzi 3 do 1 w internecie.

Ale podczas gdy większość właścicieli stron internetowych wciąż próbuje zrozumieć, co się dzieje, ty masz wszystko, czego potrzebujesz, aby odwrócić ten chaos botów na korzyść twojego biznesu i nawet skorzystać z dobrych botów.

Więc ruszaj i zacznij wdrażać systemy zarządzania botami, podczas gdy twoja konkurencja wciąż panikuje z powodu fałszywego ruchu!