Il tuo sito web è come un bar. Le persone entrano e guardano il menù. Alcuni ordinano latte, si siedono, sorseggiano e se ne vanno.

Ma cosa succede se metà dei tuoi “clienti” occupa solo i tavoli, fa perdere tempo ai tuoi baristi e non compra mai il caffè?

Nel frattempo, i clienti reali se ne vanno a causa della mancanza di tavoli e del servizio lento?

Beh, questo è il mondo dei crawler web e dei bot.

Questi programmi automatizzati consumano la tua larghezza di banda, rallentano il tuo sito e allontanano i veri clienti.

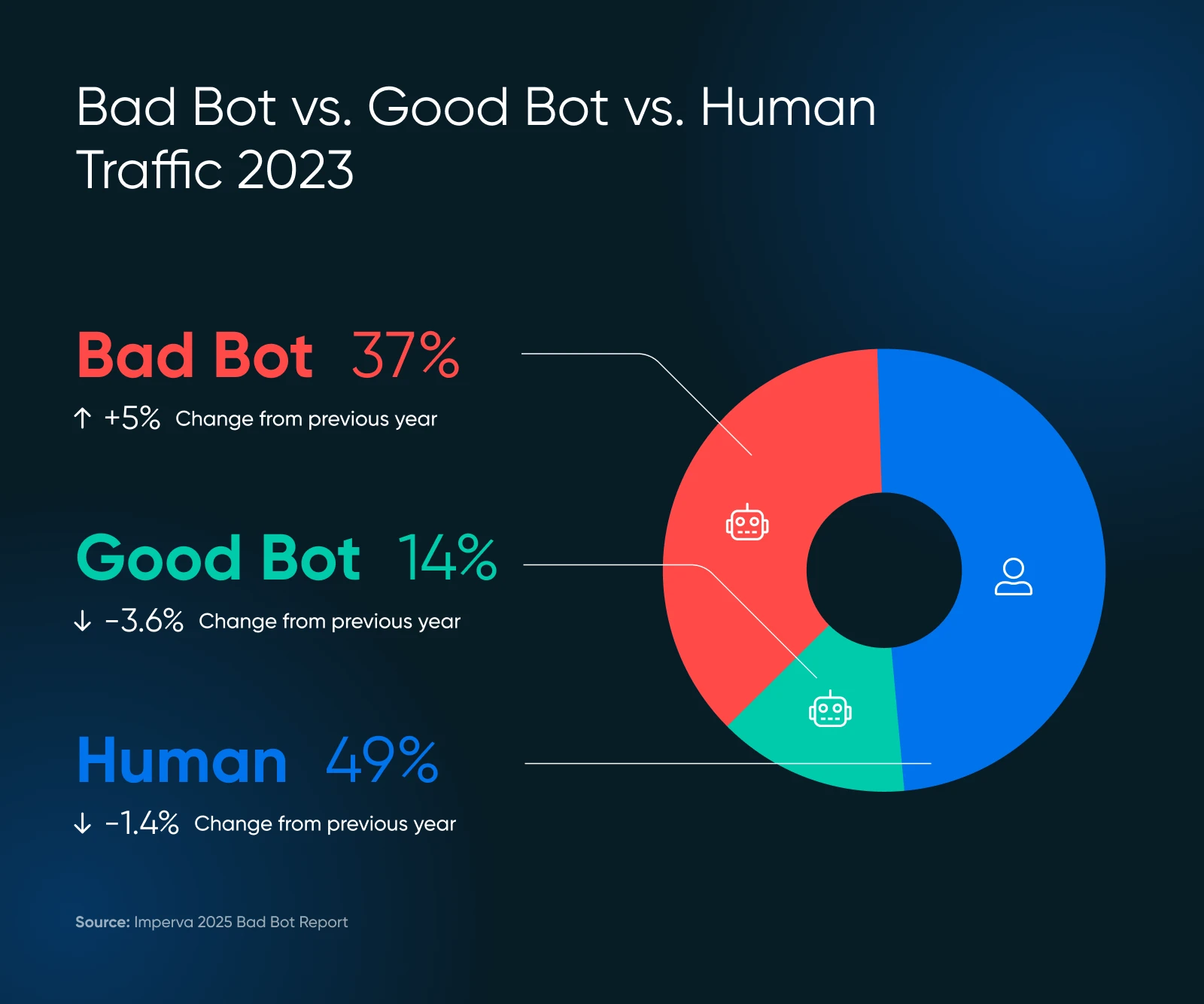

Recenti studi dimostrano che quasi il 51% del traffico internet proviene dai bot. Esatto — più della metà dei tuoi visitatori digitali potrebbero semplicemente sprecare le risorse del tuo server.

Ma non preoccuparti!

Questa guida ti aiuterà a individuare problemi e controllare le prestazioni del tuo sito, tutto senza programmare o chiamare tuo cugino tecnico.

Un Rapido Ripasso sui Bot

I Bot sono programmi software automatizzati che eseguono compiti su internet senza intervento umano. Essi:

- Visita siti web

- Interagisci con contenuti digitali

- E esegui funzioni specifiche basate sulla loro programmazione.

Alcuni bot analizzano e indicizzano il tuo sito (potenzialmente migliorando il posizionamento sui motori di ricerca.) Alcuni trascorrono il loro tempo a raschiare i tuoi contenuti per dataset di formazione AI — o peggio — pubblicando spam, generando recensioni false, o cercando exploit e vulnerabilità nel tuo sito web.

Certo, non tutti i bot sono creati uguali. Alcuni sono fondamentali per la salute e la visibilità del tuo sito web. Altri sono argomentabilmente neutrali, e alcuni sono decisamente nocivi. Conoscere la differenza — e decidere quali bot bloccare e quali permettere — è cruciale per proteggere il tuo sito e la sua reputazione.

Bot Buono, Bot Cattivo: Qual è Qual?

I Bot costituiscono internet.

Ad esempio, il bot di Google visita ogni pagina su internet e la aggiunge ai loro database per il posizionamento. Questo bot aiuta a fornire traffico di ricerca prezioso, che è importante per la salute del tuo sito web.

Ma, non tutti i bot sono utili, e alcuni sono decisamente dannosi. Ecco cosa mantenere e cosa bloccare.

I Bot VIP (Conservali)

- I crawler dei motori di ricerca come Googlebot e Bingbot sono esempi di questi crawler. Non bloccarli, altrimenti diventerai invisibile online.

- I Bot di analisi raccolgono dati sulle prestazioni del tuo sito, come il bot di Google Pagespeed Insights o il bot di GTmetrix.

I Guastafeste (Necessitano Gestione)

- Raschiatori di contenuti che rubano i tuoi contenuti per usarli altrove

- Bot dello Spam che inondano i tuoi moduli e commenti con spazzatura

- Individui malintenzionati che tentano di hackerare account o sfruttare vulnerabilità

La scala dei bot cattivi potrebbe sorprenderti. Nel 2024, i bot avanzati hanno rappresentato il 55% di tutto il traffico di bot cattivi avanzati, mentre quelli buoni hanno rappresentato il 44%.

Quei bot avanzati sono furtivi — possono imitare il comportamento umano, inclusi i movimenti del mouse e i clic, rendendoli più difficili da rilevare.

I Bot Stanno Rallentando Il Tuo Sito? Ecco I Segnali Di Allarme Da Cercare

Prima di passare alle soluzioni, assicurati che i bot siano effettivamente il tuo problema. Controlla i segni qui sotto.

Segnali di Allarme nelle Tue Analisi

- Picchi di traffico inspiegabili: Se il numero dei visitatori aumenta improvvisamente ma le vendite no, i bot potrebbero essere i colpevoli.

- Tutto rallenta: Le pagine impiegano più tempo a caricarsi, frustrando i veri clienti che potrebbero andarsene per sempre. Aberdeen mostra che il 40% dei visitatori abbandona i siti web che impiegano più di tre secondi a caricarsi, il che porta a…

- Tassi di abbandono elevati: sopra il 90% indicano spesso attività dei bot.

- Modelli di sessione strani: Gli umani tipicamente non visitano solo per millisecondi o rimangono su una pagina per ore.

- Inizi a ricevere molto traffico insolito: Specialmente da paesi in cui non fai affari. Questo è sospetto.

- Invii di moduli con testi casuali: Comportamento classico dei bot.

- Il tuo server viene sopraffatto: Immagina di vedere 100 clienti in una volta, ma 75 stanno solo guardando le vetrine.

Controlla i Tuoi Log del Server

I log del server del tuo sito web contengono i record di ogni visitatore.

Ecco cosa cercare:

- Troppe richieste consecutive dallo stesso indirizzo IP

- Stringhe di user-agent insolite (l’identificazione fornita dai bot)

- Richieste per URL insoliti che non esistono sul tuo sito

User Agent

Un user agent è un tipo di software che recupera e rende disponibili i contenuti web affinché gli utenti possano interagirvi. Gli esempi più comuni sono i browser web e i lettori di email.

Leggi di piùUna richiesta legittima di Googlebot potrebbe apparire così nei tuoi log:

66.249.78.17 - - [13/lug/2015:07:18:58 -0400] "GET /robots.txt HTTP/1.1" 200 0 "-" "Mozilla/5.0 (compatibile; Googlebot/2.1; +http://www.google.com/bot.html)"Se noti schemi che non corrispondono al normale comportamento di navigazione umano, è il momento di agire.

Il Problema GPTBot con l’Aumento dei Crawler IA

Recentemente, molti proprietari di siti web hanno segnalato problemi con crawler IA che generano modelli di traffico anomali.

Secondo la ricerca di Imperva, il GPTBot di OpenAI ha effettuato 569 milioni di richieste in un solo mese, mentre il bot di Claude ne ha fatte 370 milioni sulla rete di Vercel.

Cerca:

- Picchi di errori nei tuoi log: Se vedi improvvisamente centinaia o migliaia di errori 404, controlla se provengono da crawler IA.

- URL estremamente lunghi e privi di senso: I bot IA potrebbero richiedere URL bizzarri come i seguenti:

/Odonto-lieyectoresli-541.aspx/assets/js/plugins/Docs/Productos/assets/js/Docs/Productos/assets/js/assets/js/assets/js/vendor/images2021/Docs/...- Parametri Ricorsivi: Cerca parametri che si ripetono all’infinito, ad esempio:

amp;amp;amp;page=6&page=6- Picchi di Larghezza di Banda: Readthedocs, una rinomata azienda di documentazione tecnica, ha affermato che un crawler IA ha scaricato 73TB di file ZIP, con 10TB scaricati in un solo giorno, costando loro oltre $5,000 in spese di larghezza di banda.

Questi schemi possono indicare crawler IA che sono guasti o manipolati per causare problemi.

Quando Richiedere Assistenza Tecnica

Se noti questi segni ma non sai cosa fare dopo, è il momento di chiedere aiuto a un professionista. Chiedi al tuo sviluppatore di verificare specifici agenti utente come questo:

Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatibile; GPTBot/1.2; +https://openai.com/gptbot)

Ci sono molte stringhe degli agenti utente per altri crawler IA che puoi cercare su Google per bloccare. Fai attenzione al fatto che le stringhe cambiano, il che significa che potresti finire per avere una lista piuttosto lunga nel tempo.

👉 Non hai uno sviluppatore a portata di mano? Il team DreamCare di DreamHost può analizzare i tuoi log e implementare misure di protezione. Hanno già affrontato questi problemi e sanno esattamente come gestirli.

Il Tuo Kit Anti-Bot: 5 Passi Semplici Per Riprendere Il Controllo

Ora viene la parte interessante: come fermare questi bot che rallentano il tuo sito. Rimboccati le maniche e mettiamoci al lavoro.

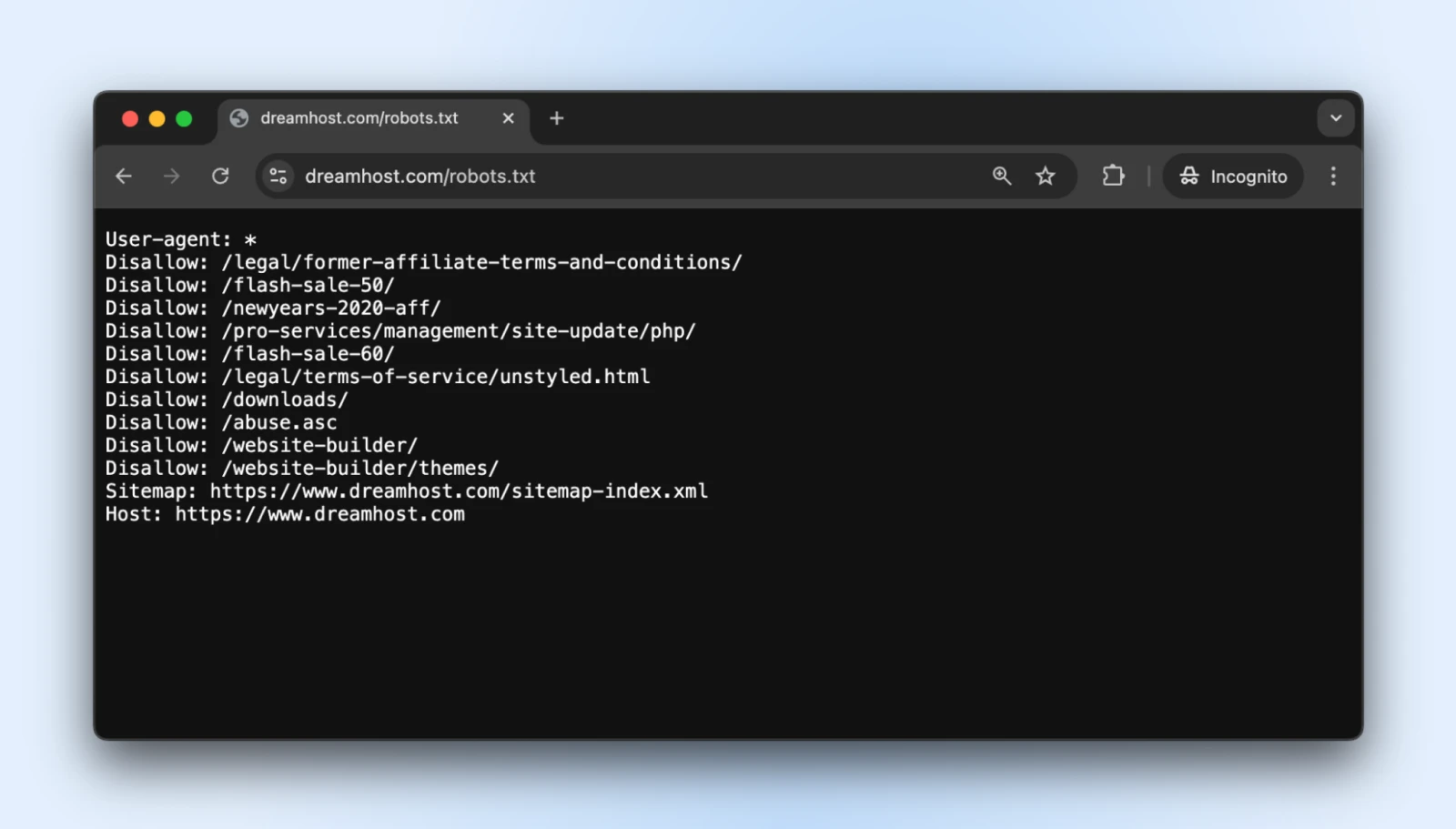

1. Crea un File robots.txt Appropriato

Il file di testo semplice robots.txt si trova nella tua directory principale e indica ai bot ben comportati quali parti del tuo sito non dovrebbero accedere.

Puoi accedere al robots.txt di praticamente qualsiasi sito web aggiungendo /robots.txt al suo dominio. Ad esempio, se vuoi vedere il file robots.txt di DreamHost, aggiungi robots.txt alla fine del dominio in questo modo: https://dreamhost.com/robots.txt

Non c’è nessun obbligo per i bot di accettare le regole.

Ma i bot educati lo rispetteranno, e i guastafeste possono scegliere di ignorare le regole. È comunque meglio aggiungere un robots.txt così i bot buoni non iniziano ad indicizzare l’accesso admin, le pagine post-acquisto, le pagine di ringraziamento, ecc.

Come Implementare

1. Crea un file di testo semplice chiamato robots.txt

2. Aggiungi le tue istruzioni utilizzando questo formato:

User-agent: * # Questa riga si applica a tutti i bot

Disallow: /admin/ # Non esplorare l'area amministrativa

Disallow: /private/ # Non accedere alle cartelle private

Crawl-delay: 10 # Attesa di 10 secondi tra le richieste

User-agent: Googlebot # Regole speciali solo per Google

Allow: / # Google può accedere a tutto3. Carica il file nella directory radice del tuo sito web (così che sia su yourdomain.com/robots.txt)

La direttiva “Crawl-delay” è la tua arma segreta qui. Costringe i bot ad attendere tra le richieste, impedendo loro di sovraccaricare il tuo server.

La maggior parte dei crawler principali rispettano questo, sebbene Googlebot segua il proprio sistema (che puoi controllare tramite Google Search Console).

Suggerimento professionale: Testa il tuo robots.txt con lo strumento di test di robots.txt di Google per assicurarti di non aver bloccato accidentalmente contenuti importanti.

2. Configura Il Limitatore di Frequenza

Il rate limiting limita il numero di richieste che un singolo visitatore può effettuare in un periodo specifico.

Impedisce ai bot di sovraccaricare il tuo server così che le persone normali possano navigare sul tuo sito senza interruzioni.

Come Implementare

Se stai utilizzando Apache (comune per i siti WordPress), aggiungi queste righe al tuo file .htaccess:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{REQUEST_URI} !(.css|.js|.png|.jpg|.gif|robots.txt)$ [NC]

RewriteCond %{HTTP_USER_AGENT} !^Googlebot [NC]

RewriteCond %{HTTP_USER_AGENT} !^Bingbot [NC]

# Consenti al massimo 3 richieste in 10 secondi per IP

RewriteCond %{REMOTE_ADDR} ^([0-9]+.[0-9]+.[0-9]+.[0-9]+)$

RewriteRule .* - [F,L]

</IfModule>.htaccess

u201c.htaccessu201d è un file di configurazione utilizzato dal software del server web Apache. Il file .htaccess contiene direttive (istruzioni) che indicano ad Apache come comportarsi per un determinato sito web o directory.

Leggi di piùSe usi Nginx, aggiungi questo alla tua configurazione del server:

limit_req_zone $binary_remote_addr zone=one:10m rate=30r/m;

server {

...

location / {

limit_req zone=one burst=5;

...

}

}Molti pannelli di controllo dell’hosting, come cPanel o Plesk, offrono anche strumenti di limitazione della velocità nelle loro sezioni di sicurezza.

Consiglio Pro: Inizia con limiti conservativi (come 30 richieste al minuto) e monitora il tuo sito. Puoi sempre intensificare le restrizioni se il traffico dei bot continua.

3. Utilizza Una Rete di Distribuzione dei Contenuti (CDN)

CDNs fanno due cose buone per te:

- Distribuisci il contenuto attraverso reti di server globali così il tuo sito web viene consegnato rapidamente in tutto il mondo

- Filtra il traffico prima che raggiunga il sito web per bloccare qualsiasi bot irrilevante e attacchi

La parte dei “bot irrilevanti” è quella che per noi conta ora, ma anche gli altri vantaggi sono utili. La maggior parte delle CDN include una gestione integrata dei bot che identifica e blocca automaticamente i visitatori sospetti.

Come Implementare

- Iscriviti a un servizio CDN come DreamHost CDN, Cloudflare, Amazon CloudFront o Fastly.

- Segui le istruzioni di configurazione (potrebbe richiedere la modifica dei Nameservers).

- Configura le impostazioni di sicurezza per abilitare la protezione dai Bot.

Se il tuo servizio di hosting offre un CDN di default, elimini tutti i passaggi poiché il tuo sito web sarà automaticamente ospitato su CDN.

Una volta configurata, la tua CDN:

- Memorizza nella cache i contenuti statici per ridurre il carico sul server.

- Filtra il traffico sospetto prima che raggiunga il tuo sito.

- Applica l’apprendimento automatico per distinguere tra richieste legittime e richieste dannose.

- Blocca automaticamente gli attori dannosi noti.

Consiglio professionale: Il livello gratuito di Cloudflare include protezione base contro i Bot che funziona bene per la maggior parte dei siti di piccole imprese. I loro piani a pagamento offrono opzioni più avanzate se ne hai bisogno.

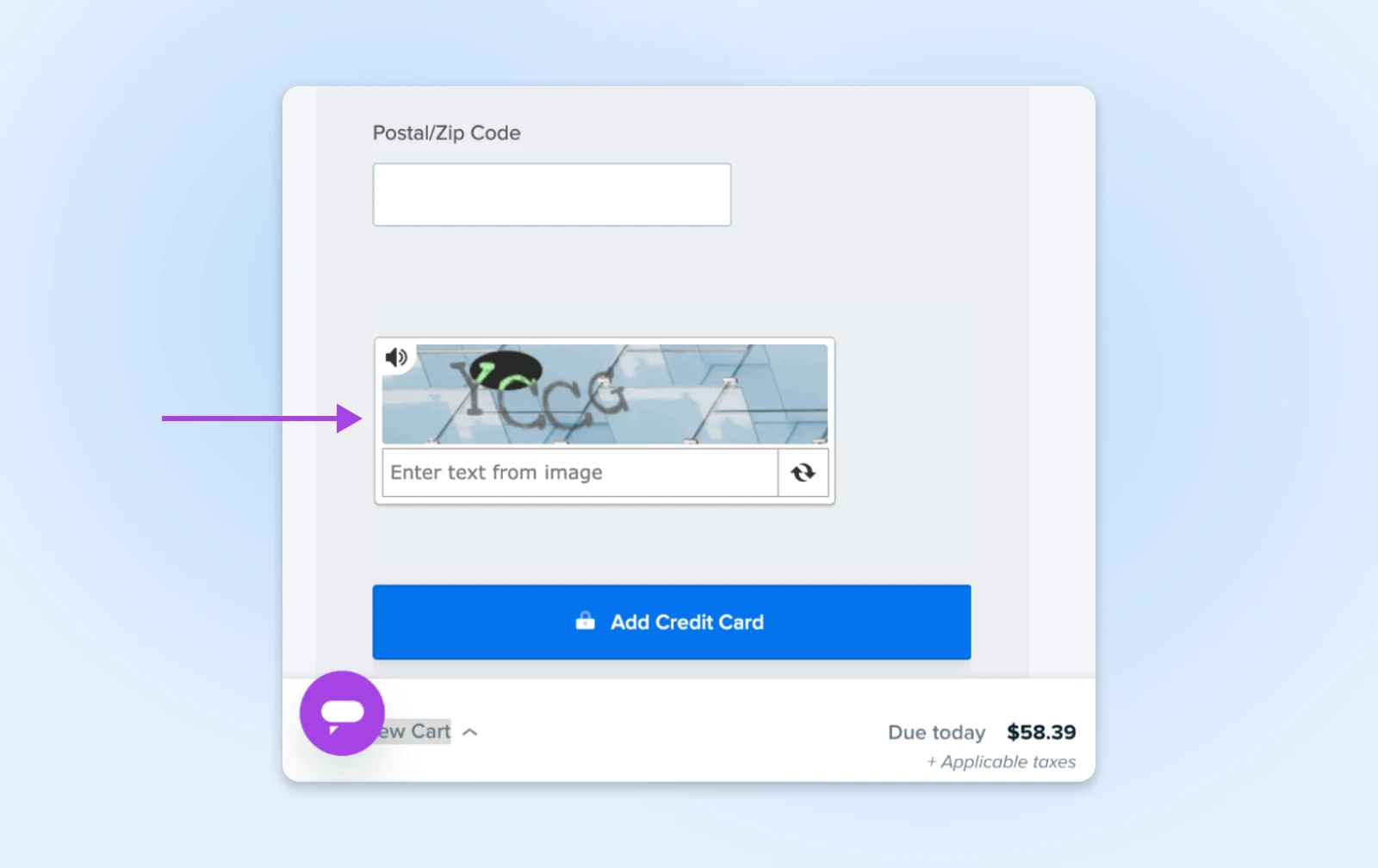

4. Aggiungi CAPTCHA per Azioni Sensibili

I CAPTCHA sono quei piccoli enigmi che ti chiedono di identificare i semafori o le biciclette. Sono fastidiosi per gli umani ma quasi impossibili per la maggior parte dei bot, rendendoli perfetti guardiani per le aree importanti del tuo sito.

Come Implementare

- Iscriviti a Google’s reCAPTCHA (gratuito) o hCaptcha.

- Aggiungi il codice CAPTCHA ai tuoi moduli sensibili:

- Pagine di accesso

- Moduli di contatto

- Processi di checkout

- Sezioni di commento

Per gli utenti di WordPress, plugin come Akismet possono gestire automaticamente questo per commenti e invii di form.

Consiglio Pro: I CAPTCHA invisibili moderni (come reCAPTCHA v3) funzionano dietro le quinte per la maggior parte dei visitatori, mostrando sfide solo agli utenti sospetti. Utilizza questo metodo per ottenere protezione senza infastidire i clienti legittimi.

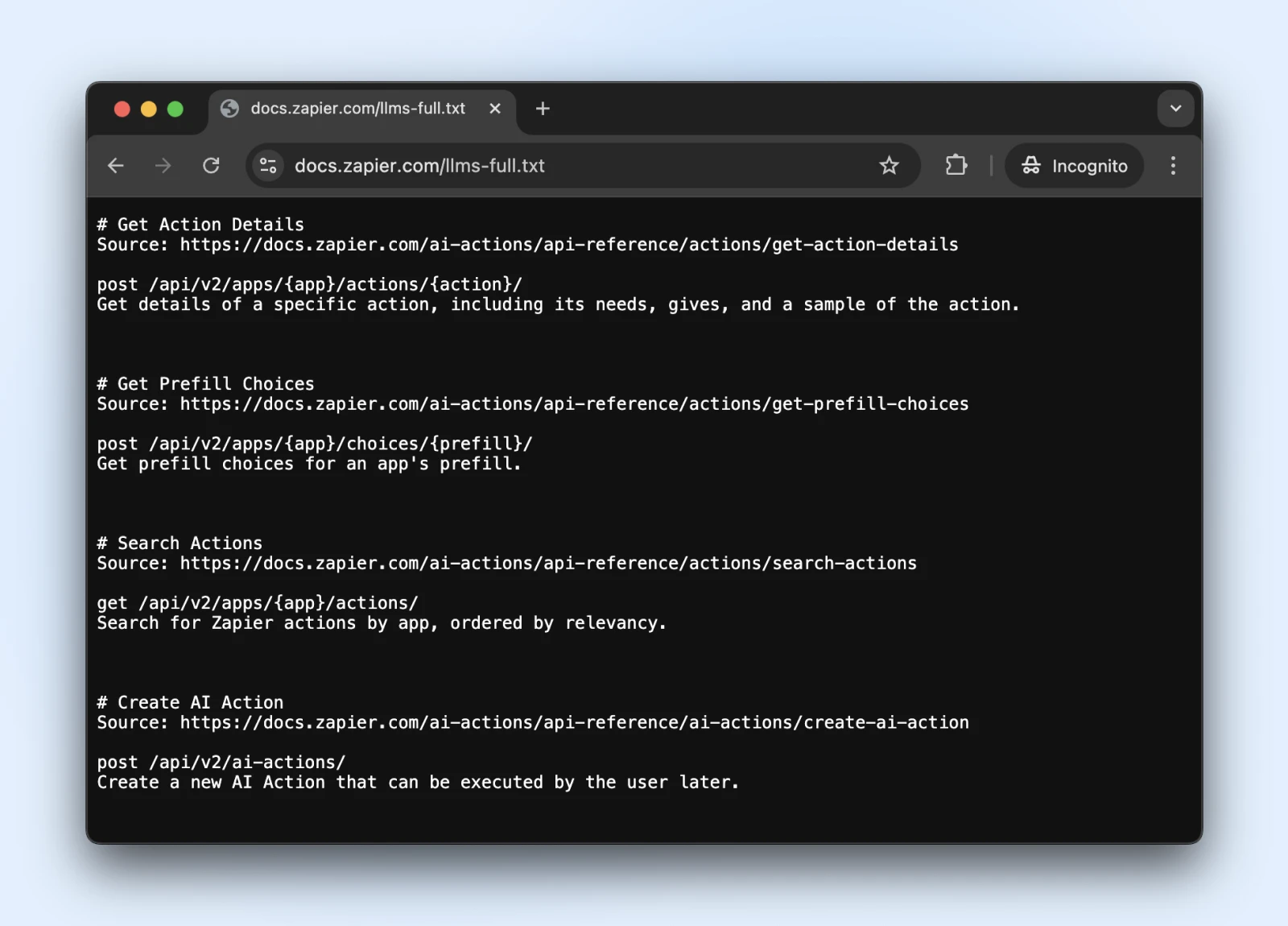

5. Considera il Nuovo Standard llms.txt

Lo standard llms.txt è uno sviluppo recente che regola come i crawler IA interagiscono con il tuo contenuto.

È come robots.txt ma specifico per indicare ai sistemi IA quali informazioni possono accedere e cosa devono evitare.

Come Implementare

1. Crea un file markdown chiamato llms.txt con questa struttura di contenuto:

# Il Nome del Tuo Sito Web

> Breve descrizione del tuo sito

## Aree di Contenuto Principali

- [Pagine dei Prodotti](https://yoursite.com/products): Informazioni sui prodotti

- [Articoli del Blog](https://yoursite.com/blog): Contenuti educativi

## Restrizioni

- Per favore, non utilizzare le nostre informazioni sui prezzi nella formazione2. Caricalo nella tua directory Root (su yourdomain.com/llms.txt) → Rivolgiti a uno sviluppatore se non hai accesso diretto al server.

Il llms.txt è lo standard ufficiale? Non ancora.

È uno standard proposto alla fine del 2024 da Jeremy Howard, che è stato adottato da Zapier, Stripe, Cloudflare e molte altre grandi aziende. Ecco una lista in crescita di siti web che adottano llms.txt.

Allora, se vuoi unirti, hanno la documentazione ufficiale su GitHub con linee guida per l’implementazione.

Suggerimento: Una volta implementato, verifica se ChatGPT (con la ricerca web abilitata) può accedere e comprendere il file llms.txt.

Verifica che il file llms.txt sia accessibile a questi bot chiedendo a ChatGPT (o un altro LLM) di “Controllare se puoi leggere questa pagina” o “Cosa dice la pagina”.

Non possiamo sapere se i bot rispetteranno llms.txt a breve. Tuttavia, se la ricerca IA può leggere e comprendere il file llms.txt ora, potrebbero iniziare a rispettarlo anche in futuro.

Monitoraggio E Manutenzione Della Protezione Da Bot Del Tuo Sito

Hai configurato le tue difese da bot — ottimo lavoro!

Tieni presente che la tecnologia dei bot è in continua evoluzione, il che significa che i bot tornano con nuovi trucchi. Facciamo in modo che il tuo sito rimanga protetto nel lungo periodo.

- Pianifica controlli di sicurezza regolari: Una volta al mese, controlla i tuoi log del server per rilevare eventuali anomalie e assicurati che i tuoi file robots.txt e llms.txt siano aggiornati con i nuovi link delle pagine che desideri che i bot possano accedere/non accedere.

- Mantieni aggiornata la tua blacklist dei bot: I bot cambiano continuamente le loro maschere. Segui i blog di sicurezza (o lascia che il tuo fornitore di hosting lo faccia per te) e aggiorna le tue regole di blocco a intervalli regolari.

- Controlla la tua velocità: Una protezione contro i bot che rallenta il tuo sito non ti fa alcun favore. Tieni d’occhio i tempi di caricamento delle tue pagine e regola la tua protezione se le cose iniziano a diventare lente. Ricorda, gli umani reali sono creature impazienti!

- Considera l’opzione autopilota: Se tutto ciò ti sembra troppo lavoro (capisco, hai un’attività da gestire!), esplora soluzioni automatizzate o hosting gestito che si occupa della sicurezza per te. A volte il miglior fai-da-te è DFPM — Fatto Per Me!

Un Sito Senza Bot Mentre Dormi? Sì, Grazie!

Datti una pacca sulla spalla. Hai coperto molto terreno qui!

Tuttavia, anche con la nostra guida passo dopo passo, queste cose possono diventare piuttosto tecniche. (Cos’è esattamente un file .htaccess?)

E mentre è certamente possibile gestire autonomamente i bot, potresti scoprire che il tuo tempo è meglio speso a gestire l’attività.

DreamCare è il pulsante “ci pensiamo noi” che stai cercando.

Il nostro team mantiene il tuo sito protetto con:

- Monitoraggio 24/7 che individua attività sospette mentre dormi

- Revisioni di sicurezza regolari per anticipare le minacce emergenti

- Aggiornamenti automatici del software che correggono le vulnerabilità prima che i bot possano sfruttarle

- Scansione e rimozione completa di malware se qualcosa dovesse sfuggire

Vedi, i bot sono qui per restare. E considerando il loro aumento negli ultimi anni, potremmo vedere più bot che umani nel prossimo futuro. Nessuno lo sa.

Ma, perché perderci il sonno?

Ci Occupiamo Noi delle Questioni Tecniche

Porta prestazioni e affidabilità di livello aziendale al tuo sito web. Lascia il backend agli esperti – tu concentrati sul tuo business.

Vedi di PiùQuesta pagina contiene link di affiliazione. Questo significa che potremmo guadagnare una commissione se acquisti servizi attraverso il nostro link senza alcun costo aggiuntivo per te.