Seu site é como uma cafeteria. As pessoas entram e olham o menu. Algumas pedem lattes, sentam, saboreiam e vão embora.

Mas e se metade dos teus “clientes” apenas ocuparem mesas, desperdiçarem o tempo dos teus baristas e nunca comprarem café?

Enquanto isso, clientes reais vão embora por falta de mesas e serviço lento?

Bem, esse é o mundo dos rastreadores e bots.

Estes programas automatizados consomem sua largura de banda, diminuem a velocidade do seu site e afastam clientes reais.

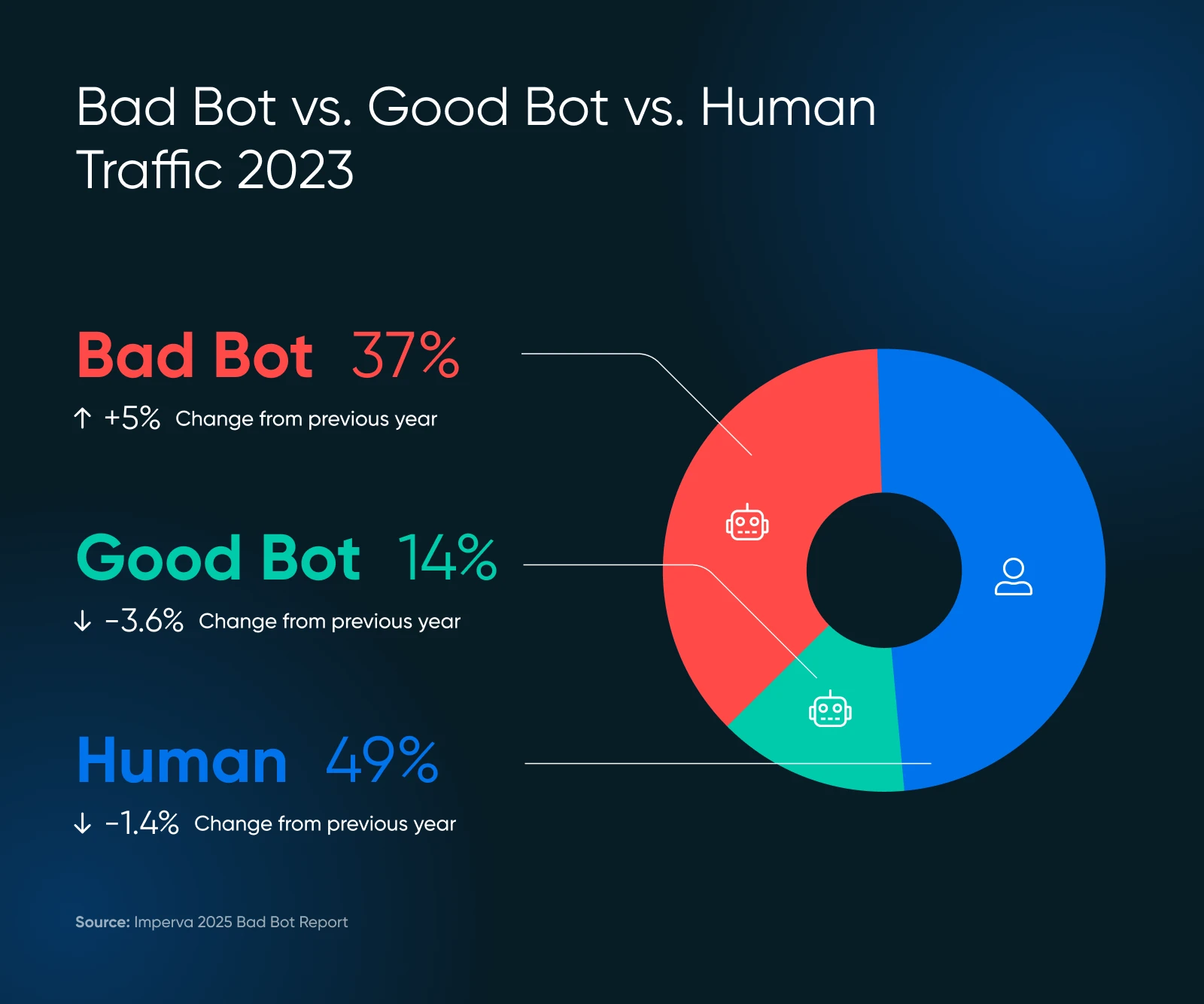

Estudos recentes mostram que quase 51% do tráfego da internet vem de bots. Isso mesmo — mais da metade dos seus visitantes digitais podem estar apenas desperdiçando os recursos do seu servidor.

Mas não entre em pânico!

Este guia ajudará você a identificar problemas e controlar o desempenho do seu site, tudo sem programar ou chamar seu primo técnico.

Uma Breve Revisão Sobre Bots

Bots são programas de software automatizados que realizam tarefas na internet sem intervenção humana. Eles:

- Visitar sites

- Interagir com conteúdo digital

- E executar funções específicas baseadas em sua programação.

Alguns bots analisam e indexam seu site (potencialmente melhorando o ranking nos motores de busca). Alguns passam seu tempo raspando seu conteúdo para conjuntos de dados de treinamento de IA — ou pior — postando spam, gerando avaliações falsas, ou procurando por brechas e falhas de segurança em seu site.

Claro, nem todos os bots são criados iguais. Alguns são essenciais para a saúde e visibilidade do seu site. Outros são, por assim dizer, neutros, e alguns são completamente tóxicos. Saber a diferença — e decidir quais bots bloquear e quais permitir — é crucial para proteger seu site e sua reputação.

Bom Bot, Mau Bot: O Que é O Que?

Os Bots compõem a internet.

Por exemplo, o bot do Google visita todas as páginas na internet e as adiciona aos seus bancos de dados para classificação. Este bot auxilia na oferta de tráfego de busca valioso, o que é importante para a saúde do seu site.

Mas, nem todo Bot vai proporcionar valor, e alguns são simplesmente ruins. Aqui está o que manter e o que bloquear.

Os Bots VIP (Mantenha Estes)

- Os rastreadores de motores de busca como o Googlebot e Bingbot são exemplos desses rastreadores. Não os bloqueie, ou você se tornará invisível online.

- Bots de análise coletam dados sobre o desempenho do seu site, como o bot do Google Pagespeed Insights ou o bot do GTmetrix.

Os Encrenqueiros (Necessitam Gestão)

- Scrapers de conteúdo que roubam seu conteúdo para uso em outro lugar

- Bots de Spam que inundam seus formulários e comentários com lixo

- Maus atores que tentam hackear contas ou explorar vulnerabilidades

A escala de bots maliciosos pode surpreender-te. Em 2024, bots avançados representaram 55% de todo o tráfego avançado de bots maliciosos, enquanto os bons corresponderam a 44%.

Esses bots avançados são sorrateiros — eles podem imitar o comportamento humano, incluindo movimentos do mouse e cliques, tornando-os mais difíceis de detectar.

Os Bots Estão Prejudicando Seu Site? Procure Por Estes Sinais de Alerta

Antes de pular para as soluções, vamos garantir que os bots realmente são o seu problema. Confira os sinais abaixo.

Sinais de Alerta em Sua Análise

- Picos de Tráfego Sem Explicação: Se a contagem de visitantes de repente aumenta mas as vendas não, bots podem ser os culpados.

- Tudo Fica L-e-n-t-o: Páginas demoram mais para carregar, frustrando clientes reais que podem ir embora de vez. Aberdeen mostra que 40% dos visitantes abandonam sites que demoram mais de três segundos para carregar, o que leva a…

- Taxas de Rejeição Altas: acima de 90% frequentemente indicam atividade de bots.

- Padrões de Sessão Estranhos: Humanos tipicamente não visitam por apenas milissegundos ou permanecem em uma página por horas.

- Você Começa a Receber Muito Tráfego Incomum: Especialmente de países onde você não faz negócios. Isso é suspeito.

- Submissões de Formulário com Texto Aleatório: Comportamento clássico de bots.

- Seu Servidor Fica Sobrecarregado: Imagine ver 100 clientes de uma vez, mas 75 estão apenas olhando as vitrines.

Verifique Seus Registros de Servidor

Os registros do servidor do seu site contêm registros de cada visitante.

Aqui está o que procurar:

- Muitos pedidos subsequentes do mesmo endereço IP

- Strings de user-agent estranhas (a identificação que os bots fornecem)

- Pedidos para URLs incomuns que não existem no seu site

Agente de Usuário

Um agente de usuário é um tipo de software que recupera e renderiza conteúdo web para que os usuários possam interagir com ele. Os exemplos mais comuns são navegadores web e leitores de email.

Leia MaisUma solicitação legítima do Googlebot pode parecer assim nos seus registros:

66.249.78.17 - - [13/Jul/2015:07:18:58 -0400] "GET /robots.txt HTTP/1.1" 200 0 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"Se você observar padrões que não correspondem ao comportamento normal de navegação humana, é hora de agir.

O Problema do GPTBot com o Aumento dos Rastreadores de IA

Recentemente, muitos proprietários de sites relataram problemas com rastreadores de IA gerando padrões de tráfego anormais.

De acordo com a pesquisa da Imperva, o GPTBot da OpenAI fez 569 milhões de solicitações em um único mês, enquanto o bot do Claude fez 370 milhões na rede da Vercel.

Procure por:

- Picos de Erros em Seus Registros: Se de repente você ver centenas ou milhares de erros 404, verifique se eles são provenientes de rastreadores de IA.

- URLs extremamente longas e sem sentido: Bots de IA podem solicitar URLs bizarras como as seguintes:

/Odonto-lieyectoresli-541.aspx/assets/js/plugins/Docs/Productos/assets/js/Docs/Productos/assets/js/assets/js/assets/js/vendor/images2021/Docs/...- Parâmetros Recursivos: Procure por parâmetros que se repetem infinitamente, por exemplo:

amp;amp;amp;page=6&page=6- Picos de Largura de Banda: Readthedocs, uma renomada empresa de documentação técnica, afirmou que um rastreador de IA baixou 73TB de arquivos ZIP, com 10TB baixados em um único dia, custando-lhes mais de $5,000 em tarifas de largura de banda.

Estes padrões podem indicar rastreadores de IA que estão com defeito ou sendo manipulados para causar problemas.

Quando Procurar Ajuda Técnica

Se você perceber esses sinais, mas não souber o que fazer em seguida, é hora de buscar ajuda profissional. Peça ao seu desenvolvedor para verificar agentes de usuário específicos como este:

Mozilla/5.0 AppleWebKit/537.36 (KHTML, como Gecko; compatível; GPTBot/1.2; +https://openai.com/gptbot)

Existem muitas strings de agentes de usuário para outros rastreadores de IA que você pode pesquisar no Google para bloquear. Note que as strings mudam, o que significa que você pode acabar com uma lista bastante grande ao longo do tempo.

👉 Não tens um desenvolvedor de prontidão? A equipe DreamCare da DreamHost pode analisar seus registros e implementar medidas de proteção. Eles já viram esses problemas antes e sabem exatamente como lidar com eles.

Seu Kit de Ferramentas Contra Bots: 5 Passos Simples Para Retomar o Controle

Agora para a parte boa: como parar esses bots de desacelerar seu site. Arregace as mangas e vamos ao trabalho.

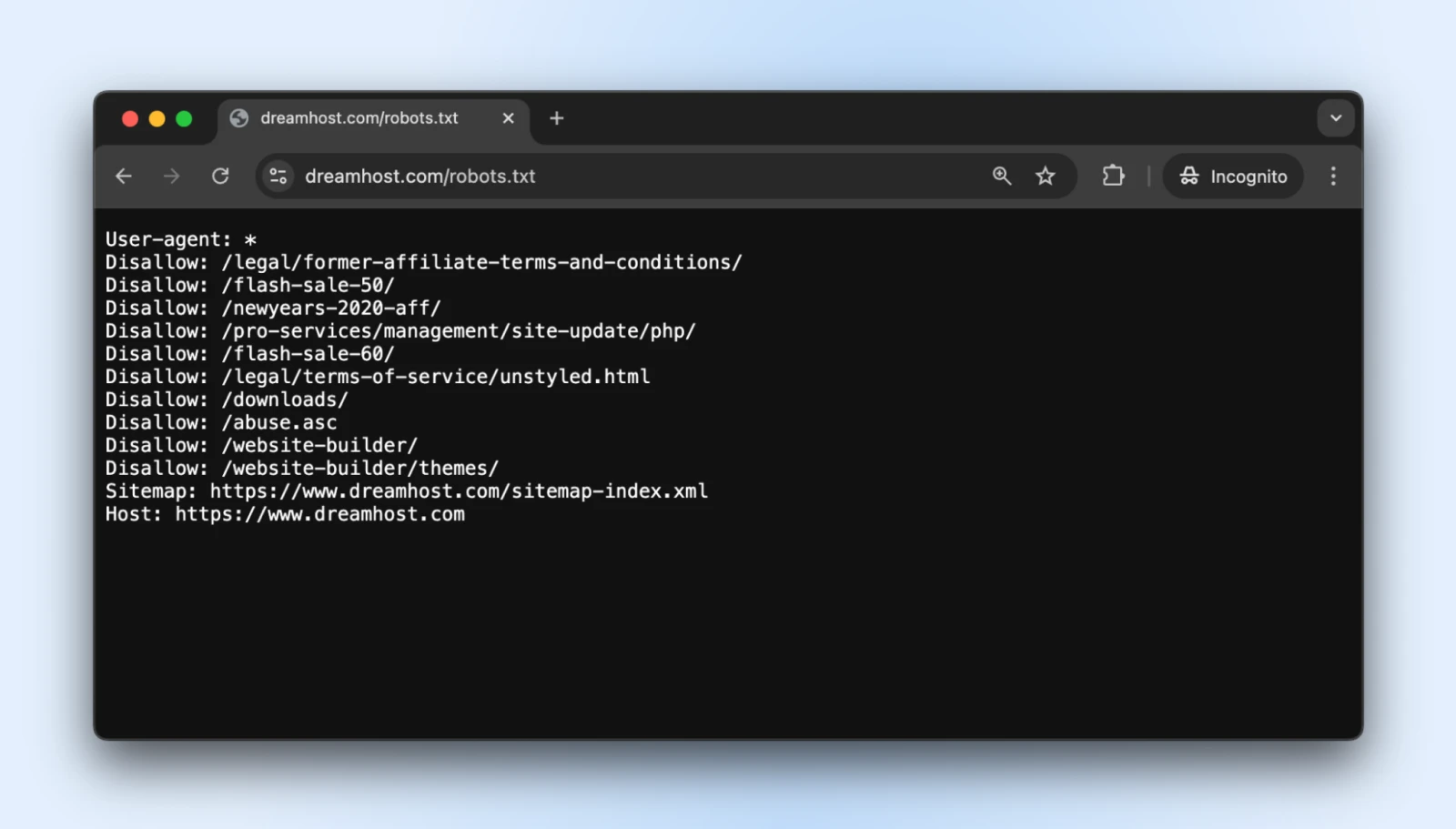

1. Crie Um Arquivo robots.txt Adequado

O arquivo de texto simples robots.txt fica no seu diretório Root e indica aos bots bem-comportados quais partes do seu site eles não devem acessar.

Você pode acessar o robots.txt de praticamente qualquer site adicionando um /robots.txt ao seu domínio. Por exemplo, se você quiser ver o arquivo robots.txt da DreamHost, adicione robots.txt ao final do domínio assim: https://dreamhost.com/robots.txt

Não há obrigação para nenhum dos bots aceitar as regras.

Mas os bots educados respeitarão isso, e os causadores de problemas podem escolher ignorar as regras. É melhor adicionar um robots.txt de qualquer forma, para que os bons bots não comecem a indexar login de admin, páginas pós-compra, páginas de agradecimento, etc.

Como Implementar

1. Crie um arquivo de texto simples chamado robots.txt

2. Adicione suas instruções usando este formato:

User-agent: * # Esta linha se aplica a todos os bots

Disallow: /admin/ # Não rastrear a área de administração

Disallow: /private/ # Fique fora das pastas privadas

Crawl-delay: 10 # Aguarde 10 segundos entre as solicitações

User-agent: Googlebot # Regras especiais apenas para o Google

Allow: / # O Google pode acessar tudo3. Faça o upload do arquivo para o diretório raiz do seu site (para que esteja em seu-dominio.com/robots.txt)

A diretiva “Crawl-delay” é sua arma secreta aqui. Ela obriga os bots a esperarem entre as solicitações, impedindo que eles sobrecarreguem seu servidor.

A maioria dos grandes rastreadores respeita isso, embora o Googlebot siga seu próprio sistema (que você pode controlar através do Google Search Console).

Dica profissional: Teste o seu robots.txt com a ferramenta de teste de robots.txt do Google para garantir que você não bloqueou acidentalmente conteúdos importantes.

2. Configurar Limitação de Taxa

O limite de taxa restringe quantas solicitações um único visitante pode fazer dentro de um período específico.

Ele impede que bots sobrecarreguem seu servidor para que pessoas normais possam navegar em seu site sem interrupções.

Como Implementar

Se você estiver usando Apache (comum para sites WordPress), adicione estas linhas ao seu arquivo .htaccess:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{REQUEST_URI} !(.css|.js|.png|.jpg|.gif|robots.txt)$ [NC]

RewriteCond %{HTTP_USER_AGENT} !^Googlebot [NC]

RewriteCond %{HTTP_USER_AGENT} !^Bingbot [NC]

# Permitir no máximo 3 solicitações em 10 segundos por IP

RewriteCond %{REMOTE_ADDR} ^([0-9]+.[0-9]+.[0-9]+.[0-9]+)$

RewriteRule .* - [F,L]

</IfModule>.htaccess

u201c.htaccessu201d é um arquivo de configuração usado pelo software de servidor web Apache. O arquivo .htaccess contém diretivas (instruções) que dizem ao Apache como se comportar para um site ou diretório específico.

Leia MaisSe você estiver usando Nginx, adicione isso à configuração do seu servidor:

limit_req_zone $binary_remote_addr zone=one:10m rate=30r/m;

server {

...

location / {

limit_req zone=one burst=5;

...

}

}Muitos painéis de controle de hospedagem, como cPanel ou Plesk, também oferecem ferramentas de limitação de taxa em suas seções de segurança.

Dica profissional: Comece com limites conservadores (como 30 solicitações por minuto) e monitore seu site. Você sempre pode reforçar as restrições se o tráfego de bots continuar.

3. Use Uma Rede de Distribuição de Conteúdo (CDN)

CDNs fazem duas coisas boas para você:

- Distribua o conteúdo através de redes de servidores globais para que seu site seja entregue rapidamente em todo o mundo

- Filtre o tráfego antes de chegar ao site para bloquear bots irrelevantes e ataques

A parte dos “bots irrelevantes” é o que importa para nós por agora, mas os outros benefícios também são úteis. A maioria dos CDNs inclui gerenciamento de bots integrado que identifica e bloqueia visitantes suspeitos automaticamente.

Como Implementar

- Inscreva-se em um serviço de CDN como DreamHost CDN, Cloudflare, Amazon CloudFront ou Fastly.

- Siga as instruções de configuração (pode ser necessário alterar os nameservers).

- Configure as definições de segurança para habilitar a proteção contra bots.

Se o seu serviço de hospedagem oferece um CDN por padrão, você elimina todas as etapas, pois seu site será automaticamente hospedado em CDN.

Uma vez configurado, seu CDN irá:

- Armazene conteúdo estático em cache para reduzir a carga do servidor.

- Filtre o tráfego suspeito antes que ele alcance seu site.

- Aplique aprendizado de máquina para diferenciar solicitações legítimas de maliciosas.

- Bloqueie automaticamente atores maliciosos conhecidos.

Dica profissional: O nível gratuito da Cloudflare inclui proteção básica contra bots que funciona bem para a maioria dos sites de pequenas empresas. Seus planos pagos oferecem opções mais avançadas se você precisar delas.

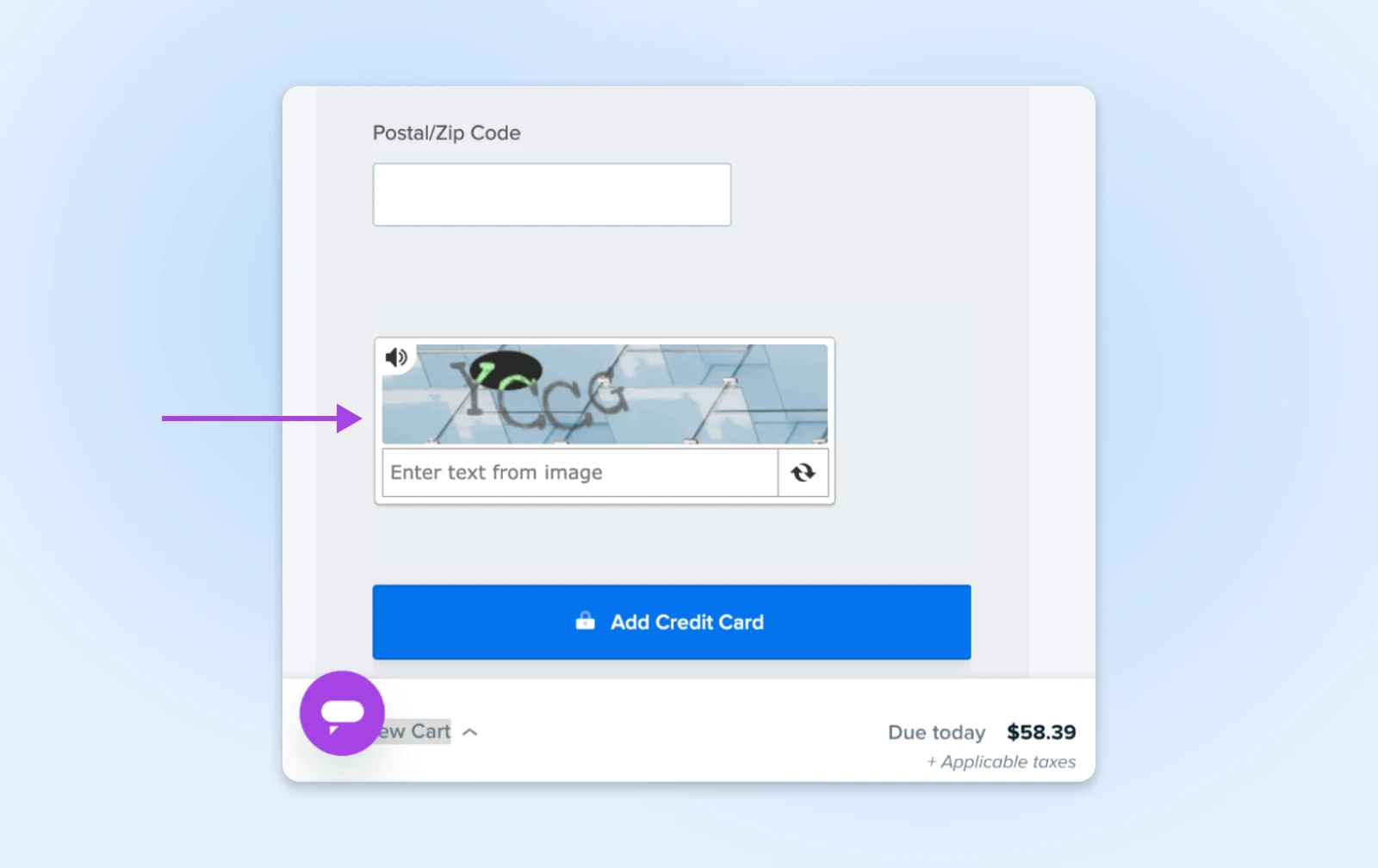

4. Adicione CAPTCHA para Ações Sensíveis

CAPTCHAs são aqueles pequenos quebra-cabeças que pedem para você identificar semáforos ou bicicletas. Eles são irritantes para humanos, mas quase impossíveis para a maioria dos bots, tornando-os guardiões perfeitos para áreas importantes do seu site.

Como Implementar

- Cadastre-se no reCAPTCHA do Google (gratuito) ou hCaptcha.

- Adicione o código CAPTCHA aos seus formulários sensíveis:

- Páginas de login

- Formulários de contato

- Processos de finalização de compra

- Seções de comentários

Para usuários do WordPress, plugins como Akismet podem lidar com isso automaticamente para comentários e submissões de formulários.

Dica Pro: CAPTCHAs invisíveis modernos (como o reCAPTCHA v3) funcionam nos bastidores para a maioria dos visitantes, mostrando desafios apenas para usuários suspeitos. Use este método para obter proteção sem incomodar os clientes legítimos.

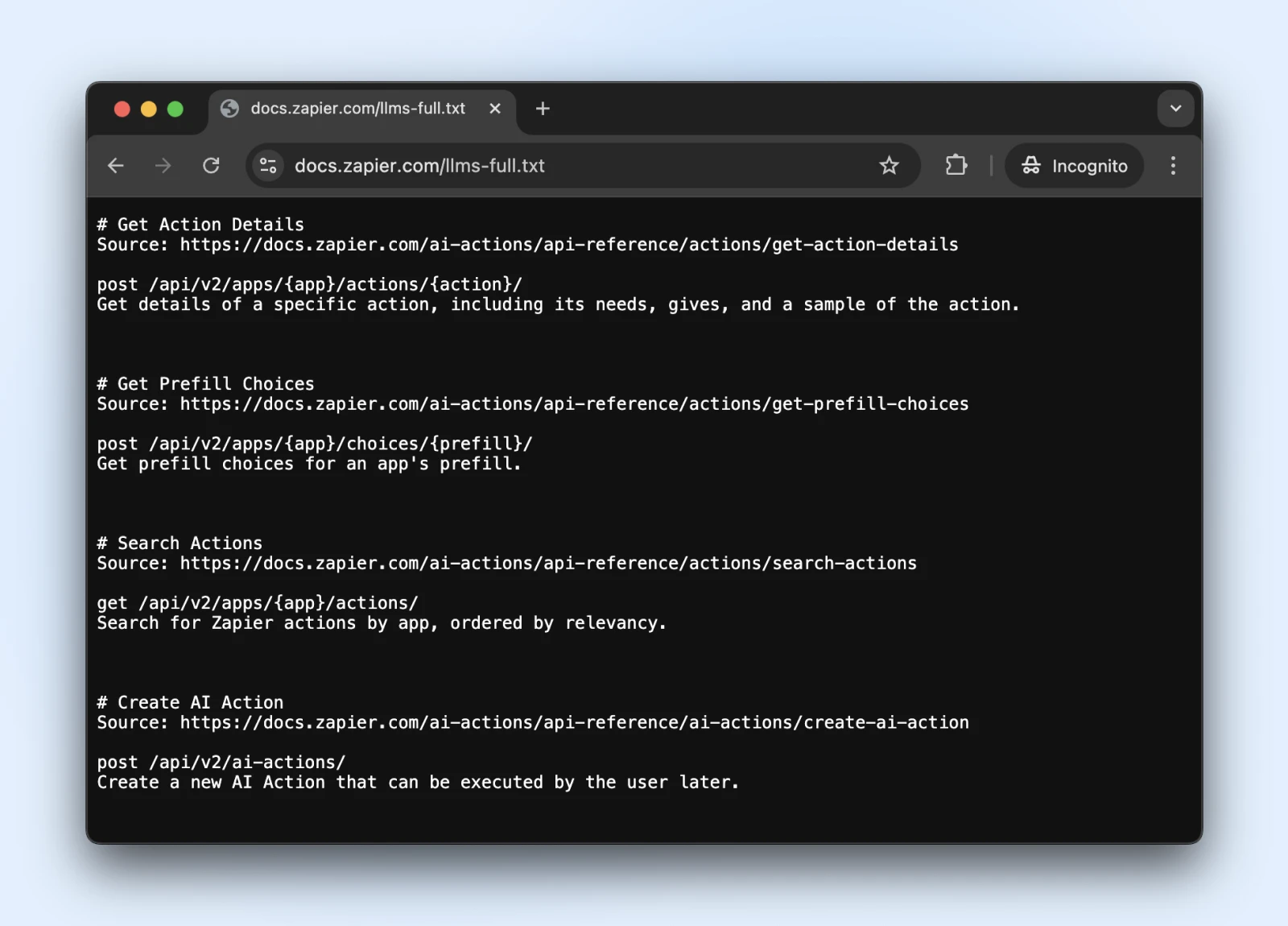

5. Considere o Novo Padrão llms.txt

O padrão llms.txt é um desenvolvimento recente que controla como os rastreadores de IA interagem com seu conteúdo.

É como robots.txt, mas especificamente para informar aos sistemas de IA quais informações eles podem acessar e o que devem evitar.

Como Implementar

1. Crie um arquivo markdown chamado llms.txt com esta estrutura de conteúdo:

# O Nome do Seu Site

> Breve descrição do seu site

## Principais Áreas de Conteúdo

- [Páginas de Produtos](https://yoursite.com/products): Informações sobre produtos

- [Artigos do Blog](https://yoursite.com/blog): Conteúdo educativo

## Restrições

- Por favor, não use nossa informação de preços em treinamentos2. Carregue-o no seu diretório raiz (em seudominio.com/llms.txt) → Entre em contato com um desenvolvedor se você não tiver acesso direto ao servidor.

O llms.txt é o padrão oficial? Ainda não.

É um padrão proposto no final de 2024 por Jeremy Howard, que foi adotado pela Zapier, Stripe, Cloudflare, e muitas outras grandes empresas. Aqui está uma lista crescente de sites adotando llms.txt.

Então, se quiser embarcar, eles possuem documentação oficial no GitHub com diretrizes de implementação.

Dica profissional: Uma vez implementado, veja se o ChatGPT (com pesquisa na web ativada) pode acessar e entender o arquivo llms.txt.

Verifica se o llms.txt está acessível para esses bots pedindo ao ChatGPT (ou outro LLM) para “Verificar se você pode ler esta página” ou “O que diz a página.”

Não podemos saber se os bots respeitarão o llms.txt em breve. No entanto, se a pesquisa de IA conseguir ler e entender o arquivo llms.txt agora, eles podem começar a respeitá-lo no futuro também.

Monitoramento e Manutenção da Proteção Contra Bots do Seu Site

Então você configurou suas defesas contra bots — ótimo trabalho!

Apenas tenha em mente que a tecnologia de Bot está sempre evoluindo, o que significa que os bots voltam com novos truques. Vamos garantir que seu site permaneça protegido a longo prazo.

- Agende verificações de segurança regulares: Uma vez por mês, olhe seus registros para qualquer coisa suspeita e certifique-se de que seus arquivos robots.txt e llms.txt estejam atualizados com quaisquer novos links de páginas que você gostaria que os bots acessassem ou não acessassem.

- Mantenha sua lista de bloqueio de bots atualizada: Os bots continuam mudando seus disfarces. Siga blogs de segurança (ou deixe seu provedor de hospedagem fazer isso por você) e atualize suas regras de bloqueio em intervalos regulares.

- Fique de olho na velocidade: Proteção contra bots que torna seu site lento não está te fazendo nenhum favor. Fique atento aos tempos de carregamento de suas páginas e ajuste sua proteção se as coisas começarem a ficar lentas. Lembre-se, seres humanos reais são criaturas impacientes!

- Considere usar o piloto automático: Se tudo isso parece muito trabalho (nós entendemos, você tem um negócio para gerenciar!), procure soluções automatizadas ou hospedagem gerenciada que cuida da segurança para você. Às vezes, o melhor faça-você-mesmo é o FAFA – Faça Alguém Fazer por Mim!

Um Site Livre de Bots Enquanto Dormes? Sim, Por Favor!

Dá-te uma palmadinha nas costas. Tu cobriste muita coisa aqui!

No entanto, mesmo com nossa orientação passo a passo, essas coisas podem se tornar bastante técnicas. (O que exatamente é um arquivo .htaccess?)

E embora a gestão de bots DIY seja certamente possível, você pode achar que seu tempo é melhor gasto gerenciando o negócio.

DreamCare é o botão “nós cuidamos disso para você” que estás procurando.

Nossa equipe mantém seu site protegido com:

- Monitoramento 24/7 que detecta atividades suspeitas enquanto você dorme

- Revisões de segurança regulares para se antecipar a ameaças emergentes

- Atualizações automáticas de software que corrigem vulnerabilidades antes que os bots possam explorá-las

- Verificação e remoção abrangente de malware se algo passar despercebido

Veja, os bots vieram para ficar. E considerando o aumento deles nos últimos anos, poderíamos ver mais bots do que humanos num futuro próximo. Ninguém sabe.

Mas, por que perder o sono com isso?

Nós Cuidamos da Parte Técnica

Traga desempenho e confiabilidade de nível empresarial para o seu site. Deixe o backend para os especialistas – você se concentra no seu negócio.

Saiba MaisEsta página contém links de afiliados. Isso significa que podemos ganhar uma comissão se você adquirir serviços através do nosso link sem nenhum custo extra para você.