Deine Website ist wie ein Café. Die Leute kommen rein und schauen sich die Speisekarte an. Einige bestellen Lattes, setzen sich, genießen und gehen.

Aber was ist, wenn die Hälfte deiner „Kunden“ nur Tische besetzt, die Zeit deiner Baristas verschwendet und nie Kaffee kauft?

Verlassen echte Kunden aufgrund fehlender Tische und langsamen Service?

Nun, das ist die Welt der Webcrawler und Bots.

Diese automatisierten Programme verbrauchen Deine Bandbreite, verlangsamen Deine Seite und vertreiben echte Kunden.

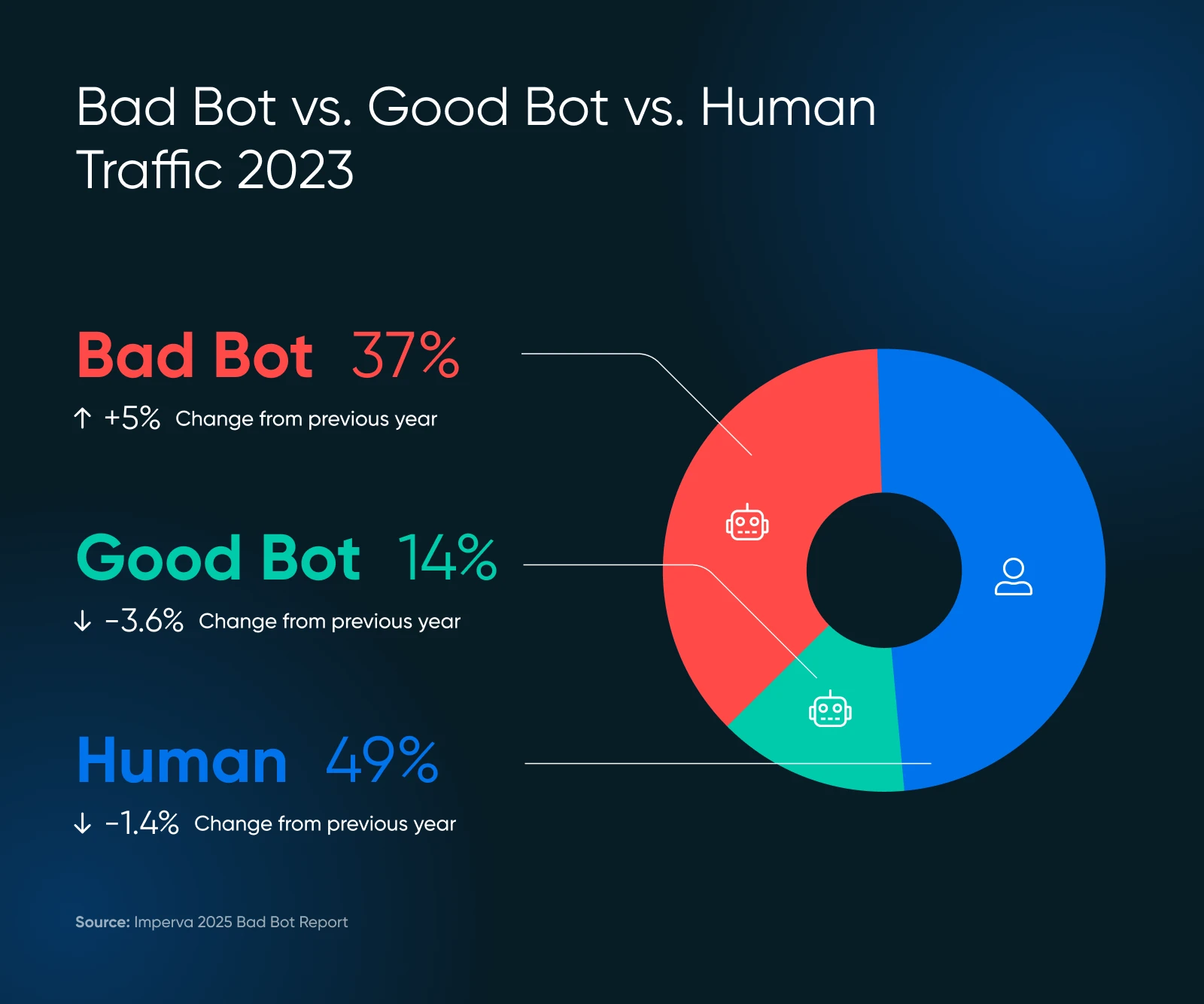

Aktuelle Studien zeigen, dass fast 51% des Internetverkehrs von Bots stammen. Das ist richtig — mehr als die Hälfte deiner digitalen Besucher könnte nur deine Serverressourcen verschwenden.

Aber keine Panik!

Dieser Leitfaden hilft Dir, Probleme zu erkennen und die Leistung Deiner Website zu steuern, ohne zu programmieren oder Deinen technikaffinen Cousin anzurufen.

Eine Schnelle Auffrischung Über Bots

Bots sind automatisierte Softwareprogramme, die Aufgaben im Internet ohne menschliches Zutun ausführen. Sie:

- Besuche Websites

- Interagiere mit digitalem Inhalt

- Und führe spezifische Funktionen basierend auf ihrer Programmierung aus.

Einige Bots analysieren und indizieren Deine Webseite (was potenziell die Suchmaschinen-Rankings verbessern kann.) Einige verbringen ihre Zeit damit, Deine Inhalte für AI-Trainingsdatensätze zu scrapen – oder schlimmer – Spam zu posten, gefälschte Bewertungen zu generieren oder nach Exploits und Sicherheitslücken auf Deiner Webseite zu suchen.

Natürlich sind nicht alle Bots gleich. Einige sind entscheidend für die Gesundheit und Sichtbarkeit deiner Website. Andere sind möglicherweise neutral, und einige sind regelrecht schädlich. Den Unterschied zu kennen — und zu entscheiden, welche Bots blockiert und welche zugelassen werden sollten — ist entscheidend, um deine Website und ihren Ruf zu schützen.

Guter Bot, Schlechter Bot: Was Ist Was?

Bots machen das Internet aus.

Zum Beispiel besucht Googles Bot jede Seite im Internet und fügt sie ihren Datenbanken zum Ranking hinzu. Dieser Bot hilft dabei, wertvollen Suchverkehr zu liefern, der für die Gesundheit deiner Website wichtig ist.

Aber nicht jeder Bot bietet einen Mehrwert, und einige sind einfach nur schlecht. Hier ist, was Du behalten und was Du blockieren solltest.

Die VIP-Bots (Behalten Diese)

- Suchmaschinen-Crawler wie Googlebot und Bingbot sind Beispiele für solche Crawler. Blockiere sie nicht, sonst wirst du online unsichtbar.

- Analytics-Bots sammeln Daten über die Leistung deiner Website, wie der Google Pagespeed Insights-Bot oder der GTmetrix-Bot.

Die Unruhestifter (Benötigen Verwaltung)

- Inhaltskratzer, die deine Inhalte stehlen, um sie anderswo zu verwenden

- Spam-Bots, die deine Formulare und Kommentare mit Müll überfluten

- Böswillige Akteure, die versuchen, Konten zu hacken oder Schwachstellen auszunutzen

Die Skala der schlechten Bots könnte dich überraschen. Im Jahr 2024 machten fortschrittliche Bots 55% des gesamten fortschrittlichen schlechten Bot-Traffics aus, während die guten für 44% verantwortlich waren.

Diese fortschrittlichen Bots sind hinterlistig — sie können menschliches Verhalten nachahmen, einschließlich Mausbewegungen und Klicks, was ihre Entdeckung erschwert.

Belasten Bots Deine Website? Achte Auf Diese Warnzeichen

Bevor wir uns den Lösungen zuwenden, stellen wir sicher, dass Bots tatsächlich das Problem sind. Sieh dir die untenstehenden Anzeichen an.

Warnsignale In Deiner Analyse

- Ungeklärte Traffic-Spitzen: Wenn deine Besucherzahlen plötzlich ansteigen, aber die Verkäufe nicht, könnten Bots die Ursache sein.

- Alles wird langsamer: Seiten laden langsamer, was echte Kunden frustriert, die möglicherweise für immer gehen. Aberdeen zeigt, dass 40% der Besucher Websites verlassen, die länger als drei Sekunden zum Laden brauchen, was zu…

- Hohe Absprungraten: Über 90% deuten oft auf Bot-Aktivitäten hin.

- Ungewöhnliche Sitzungsmuster: Menschen besuchen typischerweise nicht nur für Millisekunden oder bleiben stundenlang auf einer Seite.

- Du erhältst plötzlich viele ungewöhnliche Besuche: Besonders aus Ländern, in denen du keine Geschäfte machst. Das ist verdächtig.

- Formulareingaben mit zufälligem Text: Klassisches Bot-Verhalten.

- Dein Server wird überlastet: Stelle dir vor, 100 Kunden kommen gleichzeitig, aber 75 davon sind nur Schaufensterbummler.

Überprüfe Deine Serverprotokolle

Die Serverprotokolle Deiner Website enthalten Aufzeichnungen über jeden Besucher.

Hier ist, worauf Du achten solltest:

- Zu viele aufeinanderfolgende Anfragen von derselben IP-Adresse

- Seltsame User-Agent-Strings (die Identifikation, die Bots bereitstellen)

- Anfragen für ungewöhnliche URLs, die auf deiner Seite nicht existieren

User Agent

Ein User Agent ist eine Art Software, die Webinhalte abruft und darstellt, sodass Benutzer damit interagieren können. Die gängigsten Beispiele sind Webbrowser und E-Mail-Leser.

Mehr lesenEine legitime Googlebot-Anfrage könnte in deinen Protokollen so aussehen:

66.249.78.17 - - [13/Jul/2015:07:18:58 -0400] "GET /robots.txt HTTP/1.1" 200 0 "-" "Mozilla/5.0 (kompatibel; Googlebot/2.1; +http://www.google.com/bot.html)"Wenn Du Muster erkennst, die keinem normalen menschlichen Surfverhalten entsprechen, ist es Zeit zu handeln.

Das GPTBot-Problem durch den Anstieg der AI-Crawler

In letzter Zeit haben viele Website-Betreiber Probleme mit AI-Crawlern gemeldet, die ungewöhnliche Verkehrsmuster erzeugen.

Laut Imperva’s Forschung hat OpenAI’s GPTBot 569 Millionen Anfragen in einem einzigen Monat gemacht, während Claude’s Bot 370 Millionen im Netzwerk von Vercel gemacht hat.

Suche nach:

- Fehler-Spitzen in Deinen Protokollen: Wenn Du plötzlich hunderte oder tausende von 404-Fehlern siehst, überprüfe, ob sie von AI Crawlern stammen.

- Extrem lange, unsinnige URLs: AI-Bots könnten seltsame URLs wie die folgenden anfordern:

/Odonto-lieyectoresli-541.aspx/assets/js/plugins/Docs/Productos/assets/js/Docs/Productos/assets/js/assets/js/assets/js/vendor/images2021/Docs/...- Rekursive Parameter: Suche nach endlos wiederholenden Parametern, zum Beispiel:

amp;amp;amp;page=6&page=6- Bandbreitenspitzen: Readthedocs, ein renommiertes Unternehmen für technische Dokumentationen, gab an, dass ein AI Crawler 73TB an ZIP-Dateien heruntergeladen hat, wobei an einem einzigen Tag 10TB heruntergeladen wurden, was ihnen mehr als $5,000 an Bandbreitenkosten verursachte.

Diese Muster können auf AI Crawler hinweisen, die entweder fehlfunktionieren oder manipuliert werden, um Probleme zu verursachen.

Wann Du Technische Hilfe Holen Solltest

Wenn Du diese Anzeichen bemerkst, aber nicht weißt, was Du als Nächstes tun sollst, ist es Zeit, professionelle Hilfe hinzuzuziehen. Bitte Deinen Entwickler, spezifische User-Agents wie diesen zu überprüfen:

Mozilla/5.0 AppleWebKit/537.36 (KHTML, wie Gecko; kompatibel; GPTBot/1.2; +https://openai.com/gptbot)

Es gibt viele aufgezeichnete Benutzer-Agent-Strings für andere AI Crawler, die Du auf Google nachschlagen kannst, um sie zu blockieren. Bitte beachte, dass sich die Strings ändern, was bedeutet, dass Du mit der Zeit eine ziemlich große Liste bekommen könntest.

👉 Hast Du keinen Entwickler auf Kurzwahl? Das DreamCare-Team von DreamHost kann Deine Protokolle analysieren und Schutzmaßnahmen implementieren. Sie haben diese Probleme bereits gesehen und wissen genau, wie sie damit umgehen sollen.

Dein Bot-Bekämpfungs-Toolkit: 5 Einfache Schritte Zur Rückgewinnung Der Kontrolle

Jetzt zum guten Teil: wie man diese Bots davon abhält, deine Seite zu verlangsamen. Krempel die Ärmel hoch und lass uns an die Arbeit gehen.

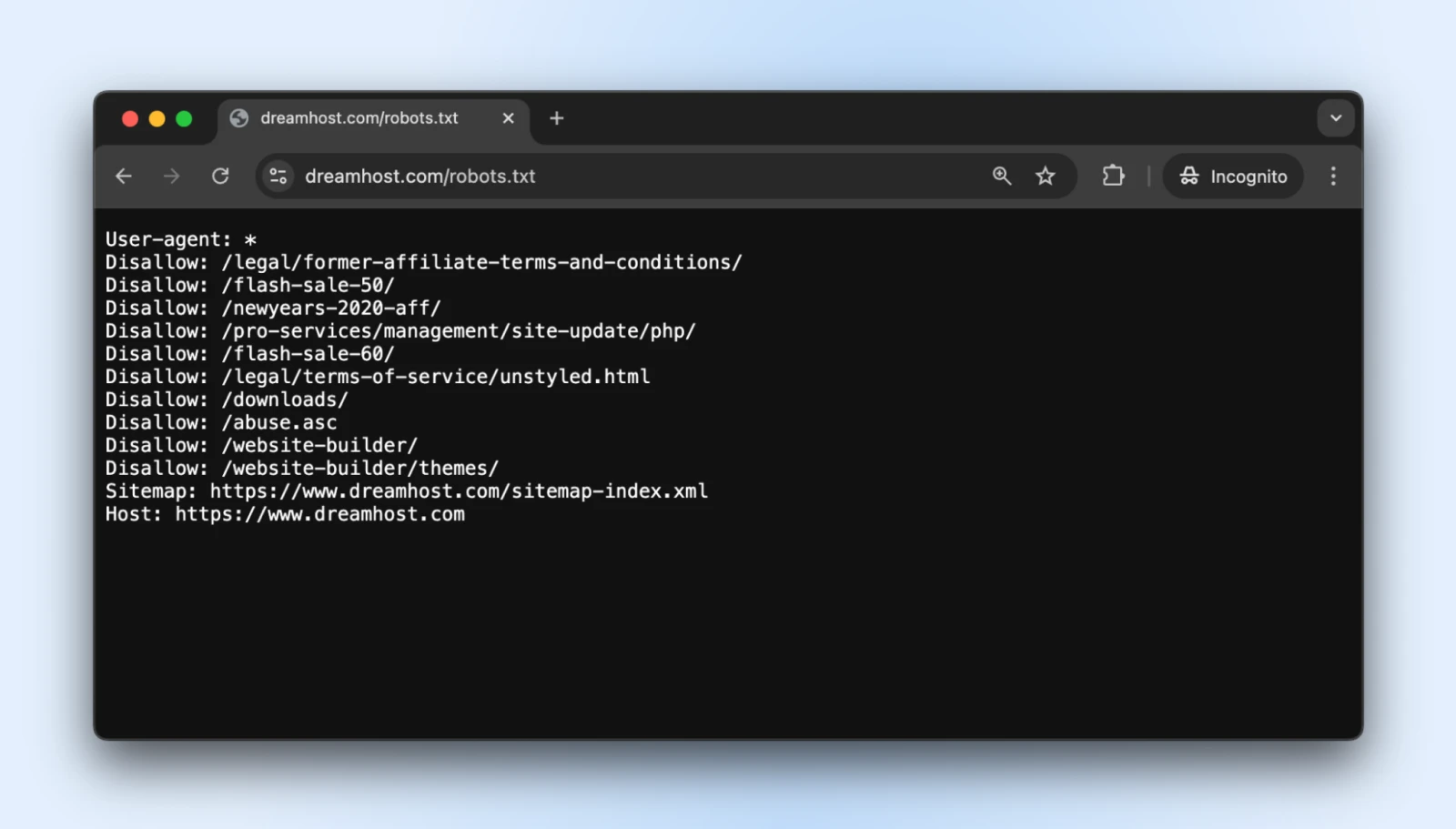

1. Erstelle Eine Richtige robots.txt-Datei

Die robots.txt einfache Textdatei befindet sich in deinem Root-Verzeichnis und teilt gutartigen Bots mit, welche Bereiche deiner Seite sie nicht zugreifen sollten.

Du kannst auf die robots.txt für so gut wie jede Website zugreifen, indem Du /robots.txt an deren Domain anhängst. Zum Beispiel, wenn Du die robots.txt-Datei für DreamHost sehen möchtest, füge robots.txt am Ende der Domain hinzu, so wie hier: https://dreamhost.com/robots.txt

Es besteht keine Verpflichtung für irgendwelche Bots, die Regeln zu akzeptieren.

Aber höfliche Bots werden es respektieren, und die Störenfriede können sich entscheiden, die Regeln zu ignorieren. Es ist am besten, trotzdem eine robots.txt hinzuzufügen, damit die guten Bots nicht beginnen, Admin-Login, Post-Checkout-Seiten, Dankesseiten usw. zu indizieren.

Wie Du Implementierst

1. Erstelle eine reine Textdatei mit dem Namen robots.txt

2. Füge deine Anweisungen in diesem Format hinzu:

User-agent: * # Diese Zeile gilt für alle Bots

Disallow: /admin/ # Durchsuche nicht den Admin-Bereich

Disallow: /private/ # Bleib aus privaten Ordnern fern

Crawl-delay: 10 # Warte 10 Sekunden zwischen den Anfragen

User-agent: Googlebot # Spezielle Regeln nur für Google

Allow: / # Google kann auf alles zugreifen3. Lade die Datei in das Stammverzeichnis deiner Website hoch (so dass sie unter deinedomain.com/robots.txt liegt)

Die „Crawl-delay“-Direktive ist hier Deine Geheimwaffe. Sie zwingt Bots dazu, zwischen Anfragen zu warten und verhindert, dass sie Deinen Server bombardieren.

Die meisten großen Crawler respektieren dies, obwohl Googlebot seinem eigenen System folgt (das Du über die Google Search Console steuern kannst).

Profi-Tipp: Teste deine robots.txt mit dem robots.txt Test-Tool von Google, um sicherzustellen, dass Du nicht versehentlich wichtige Inhalte blockiert hast.

2. Einrichten der Ratenbegrenzung

Das Ratelimiting beschränkt, wie viele Anfragen ein einzelner Besucher innerhalb eines bestimmten Zeitraums machen kann.

Es verhindert, dass Bots deinen Server überlasten, sodass normale Menschen deine Seite ohne Unterbrechungen durchsuchen können.

Wie Du Umsetzt

Wenn Du Apache verwendest (üblich für WordPress-Seiten), füge diese Zeilen zu Deiner .htaccess-Datei hinzu:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{REQUEST_URI} !(.css|.js|.png|.jpg|.gif|robots.txt)$ [NC]

RewriteCond %{HTTP_USER_AGENT} !^Googlebot [NC]

RewriteCond %{HTTP_USER_AGENT} !^Bingbot [NC]

# Erlaube maximal 3 Anfragen in 10 Sekunden pro IP

RewriteCond %{REMOTE_ADDR} ^([0-9]+.[0-9]+.[0-9]+.[0-9]+)$

RewriteRule .* - [F,L]

</IfModule>Wenn Du Nginx verwendest, füge dies zu Deiner Serverkonfiguration hinzu:

limit_req_zone $binary_remote_addr zone=one:10m rate=30r/m;

server {

...

location / {

limit_req zone=one burst=5;

...

}

}Viele Hosting-Control-Panels wie cPanel oder Plesk bieten auch Werkzeuge zur Ratenbegrenzung in ihren Sicherheitsbereichen an.

Profi-Tipp: Beginne mit konservativen Limits (wie 30 Anfragen pro Minute) und überwache Deine Website. Du kannst die Beschränkungen immer weiter verschärfen, wenn der Bot-Verkehr anhält.

3. Verwende Ein Content Delivery Network (CDN)

CDNs tun zwei gute Dinge für Dich:

- Verteile Inhalte über globale Servernetzwerke, damit deine Website weltweit schnell ausgeliefert wird

- Filtere den Traffic, bevor er die Website erreicht, um irrelevante Bots und Angriffe zu blockieren

Der Teil mit den „irrelevanten Bots“ ist für uns vorerst wichtig, aber auch die anderen Vorteile sind nützlich. Die meisten CDNs beinhalten ein eingebautes Bot-Management, das verdächtige Besucher automatisch identifiziert und blockiert.

Wie zu implementieren

- Melde Dich für einen CDN-Service wie DreamHost CDN, Cloudflare, Amazon CloudFront oder Fastly an.

- Folge den Einrichtungsanweisungen (kann Änderungen an den Nameservers erfordern).

- Konfiguriere die Sicherheitseinstellungen, um Bot-Schutz zu aktivieren.

Wenn dein Hosting-Dienst standardmäßig ein CDN anbietet, entfallen alle Schritte, da deine Website automatisch auf einem CDN gehostet wird.

Sobald eingerichtet, wird dein CDN:

- Statischen Inhalt cachen, um die Serverlast zu reduzieren.

- Verdächtigen Datenverkehr filtern, bevor er deine Seite erreicht.

- Machine Learning anwenden, um zwischen legitimen und bösartigen Anfragen zu unterscheiden.

- Bekannte bösartige Akteure automatisch blockieren.

Profi-Tipp: Die kostenlose Stufe von Cloudflare umfasst einfachen Bot-Schutz, der für die meisten kleinen Unternehmensseiten gut funktioniert. Ihre bezahlten Pläne bieten weitergehende Optionen, falls Du sie benötigst.

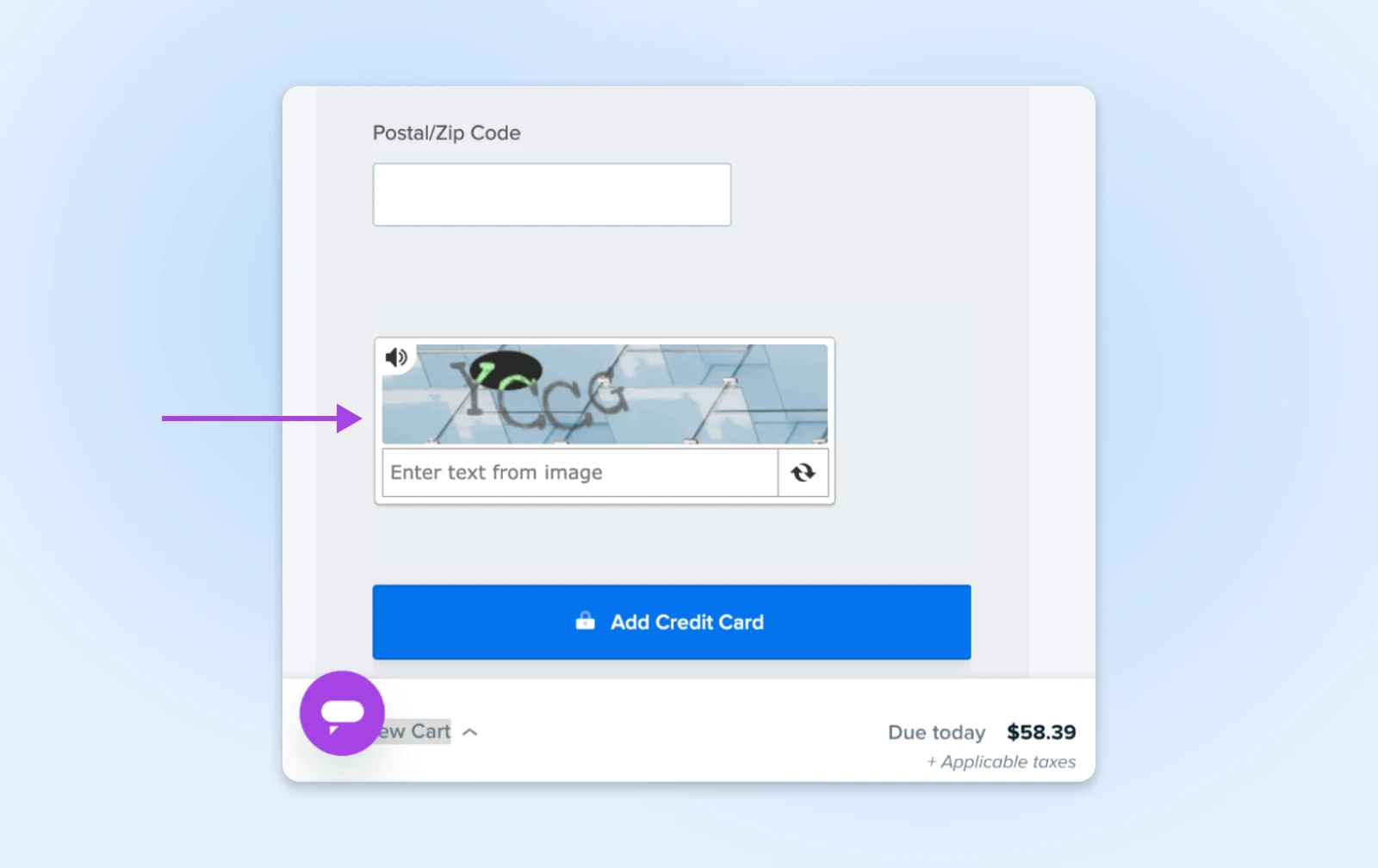

4. CAPTCHA Für Empfindliche Aktionen Hinzufügen

CAPTCHAs sind diese kleinen Rätsel, die dich bitten, Ampeln oder Fahrräder zu identifizieren. Sie sind lästig für Menschen, aber fast unmöglich für die meisten Bots zu lösen, was sie zu perfekten Wächtern für wichtige Bereiche deiner Website macht.

Wie Man Implementiert

- Melde Dich bei Google’s reCAPTCHA (kostenlos) oder hCaptcha an.

- Füge den CAPTCHA-Code Deinen sensiblen Formularen hinzu:

- Login-Seiten

- Kontaktformulare

- Checkout-Prozesse

- Kommentarbereiche

Für WordPress-Nutzer können Plugins wie Akismet dies automatisch für Kommentare und Formulareingaben handhaben.

Profi-Tipp: Moderne unsichtbare CAPTCHAs (wie reCAPTCHA v3) arbeiten im Hintergrund für die meisten Besucher und zeigen Herausforderungen nur verdächtigen Nutzern. Nutze diese Methode, um Schutz zu erhalten, ohne legitime Kunden zu verärgern.

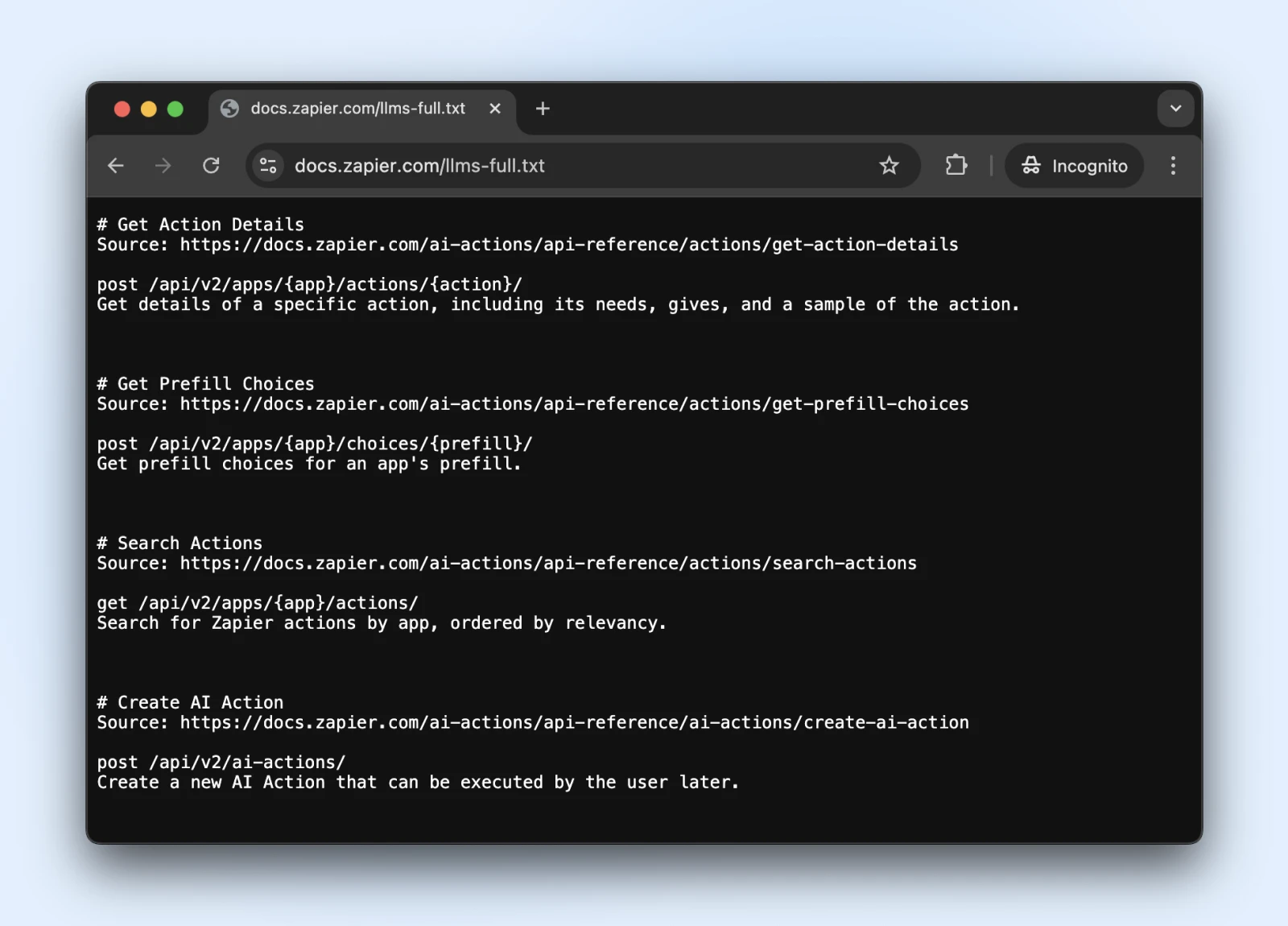

5. Den Neuen llms.txt Standard Berücksichtigen

Der llms.txt Standard ist eine neuere Entwicklung, die steuert, wie AI Crawler mit deinem Inhalt interagieren.

Es ist wie robots.txt, aber speziell dafür gedacht, KI-Systemen zu sagen, auf welche Informationen sie zugreifen können und was sie vermeiden sollten.

Wie Du Implementierst

1. Erstelle eine Markdown-Datei mit dem Namen llms.txt mit dieser Inhaltsstruktur:

# Dein Website-Name

> Kurze Beschreibung Deiner Seite

## Hauptinhaltsbereiche

- [Produktseiten](https://yoursite.com/products): Informationen zu Produkten

- [Blog-Artikel](https://yoursite.com/blog): Bildungsinhalte

## Einschränkungen

- Bitte nutze unsere Preisinformationen nicht in Schulungen2. Lade es in dein Root-Verzeichnis hoch (unter yourdomain.com/llms.txt) → Wende dich an einen Entwickler, wenn du keinen direkten Zugriff auf den Server hast.

Ist llms.txt der offizielle Standard? Noch nicht.

Es ist ein Standard, der Ende 2024 von Jeremy Howard vorgeschlagen wurde und von Zapier, Stripe, Cloudflare und vielen anderen großen Unternehmen übernommen wurde. Hier ist eine wachsende Liste von Websites, die llms.txt übernehmen.

Also, wenn Du an Bord kommen möchtest, gibt es offizielle Dokumentation auf GitHub mit Implementierungsrichtlinien.

Profi-Tipp: Nach der Implementierung prüfe, ob ChatGPT (mit aktivierter Websuche) auf die llms.txt-Datei zugreifen und verstehen kann.

Stelle sicher, dass die llms.txt für diese Bots zugänglich ist, indem Du ChatGPT (oder ein anderes LLM) bittest, „Überprüfe, ob Du diese Seite lesen kannst“ oder „Was sagt die Seite.“

Wir können nicht wissen, ob die Bots llms.txt bald respektieren werden. Wenn jedoch die AI-Suche die llms.txt-Datei jetzt lesen und verstehen kann, könnten sie sie auch in Zukunft respektieren.

Überwachung Und Wartung Des Bot-Schutzes Deiner Website

Also hast Du Deine Bot-Abwehr eingerichtet — großartige Arbeit!

Denk daran, dass die Bot-Technologie sich ständig weiterentwickelt, was bedeutet, dass Bots mit neuen Tricks zurückkommen. Lass uns sicherstellen, dass deine Seite auf lange Sicht geschützt bleibt.

- Regelmäßige Sicherheitsüberprüfungen Planen: Einmal im Monat solltest Du Deine Serverprotokolle auf verdächtige Aktivitäten prüfen und sicherstellen, dass Deine robots.txt und llms.txt Dateien mit neuen Seitenlinks aktualisiert werden, die Du den Bots erlauben oder verbieten möchtest zuzugreifen.

- Halte Deine Bot-Blockliste Aktuell: Bots ändern ständig ihre Tarnungen. Folge Sicherheitsblogs (oder lass es Deinen Hosting-Anbieter für Dich tun) und aktualisiere Deine Blockierungsregeln in regelmäßigen Abständen.

- Achte Auf Deine Geschwindigkeit: Bot-Schutz, der Deine Seite verlangsamt, ist nicht hilfreich. Behalte Deine Seitenladezeiten im Auge und justiere Deinen Schutz nach, wenn es anfängt, langsam zu werden. Denk daran, echte Menschen sind ungeduldige Kreaturen!

- Überlege, den Autopiloten Zu Aktivieren: Wenn Dir das alles zu viel Arbeit erscheint (wir verstehen das, Du hast ein Unternehmen zu führen!), solltest Du Dir automatisierte Lösungen oder verwaltetes Hosting ansehen, das die Sicherheit für Dich übernimmt. Manchmal ist das beste DIY DIFM — Mach es für mich!

Eine botfreie Website, während Du schläfst? Ja, bitte!

Klopf Dir selbst auf die Schulter. Du hast hier viel erreicht!

Allerdings kann das Ganze trotz unserer Schritt-für-Schritt-Anleitung ziemlich technisch werden. (Was ist eigentlich eine .htaccess-Datei?)

Und obwohl das DIY-Management von Bots durchaus möglich ist, wirst Du vielleicht feststellen, dass Deine Zeit besser investiert ist, wenn Du Dich auf das Geschäft konzentrierst.

DreamCare ist der „Wir kümmern uns darum“-Knopf, den Du suchst.

Unser Team hält deine Seite geschützt mit:

- 24/7-Überwachung, die verdächtige Aktivitäten erfasst, während Du schläfst

- Regelmäßige Sicherheitsüberprüfungen, um neuen Bedrohungen immer einen Schritt voraus zu sein

- Automatische Software-Updates, die Sicherheitslücken schließen, bevor Bots sie ausnutzen können

- Umfassende Malware-Scans und -Entfernung, falls doch etwas durchkommt

Siehe, Bots sind hier, um zu bleiben. Angesichts ihres Anstiegs in den letzten Jahren könnten wir in naher Zukunft mehr Bots als Menschen sehen. Niemand weiß es.

Aber, warum deswegen schlaflose Nächte haben?

Wir kümmern uns um die technische Seite

Bringen Sie Unternehmensqualität, Leistung und Zuverlässigkeit auf Ihre Website. Überlassen Sie das Backend den Experten – Sie konzentrieren sich auf Ihr Geschäft.

Mehr ErfahrenDiese Seite enthält Affiliate-Links. Das bedeutet, dass wir eine Provision verdienen können, wenn Du Dienstleistungen über unseren Link kaufst, ohne dass Dir zusätzliche Kosten entstehen.