Esta publicación es la Parte 3 de una serie de 4 partes. Asegúrate de revisar las otras publicaciones de la serie para profundizar en nuestro generador de planes de negocio impulsado por IA.

Parte 1: Cómo Construimos un Generador de Planes de Negocio Impulsado por IA Usando LangGraph & LangChain

Parte 2: Cómo Optimizamos la Generación de Planes de Negocio con IA: Compromisos entre Velocidad y Calidad

Parte 3: Cómo Creamos 273 Pruebas de Unidad en 3 Días Sin Escribir una Sola Línea de Código

Parte 4: Marco de Evaluación de IA — Cómo Construimos un Sistema para Puntuar y Mejorar los Planes de Negocio Generados por IA

En el paisaje en rápida evolución del desarrollo de software, el papel de la inteligencia artificial se está expandiendo más allá de la generación de código hacia la automatización de pruebas. Durante un período intensivo de tres días en febrero de 2025, realizamos un proyecto de investigación a fondo en DreamHost evaluando cuán efectivamente puede la IA escribir pruebas unitarias de manera autónoma con mínima intervención humana. Este artículo comparte hallazgos clave, métricas e ideas que podrían redefinir cómo abordamos la automatización de pruebas.

La Premisa de la Investigación

El objetivo principal estaba claro: evaluar si la IA puede crear de manera confiable pruebas unitarias de calidad de producción sin escribir código humano. Esto no fue solo un ejercicio académico — en DreamHost, estamos aplicando la IA para multiplicar por “100000x” nuestra productividad en el proyecto de Planificador de Negocios, y esta investigación estaba diseñada para expandir aún más esos límites. Este enfoque representa un cambio significativo respecto a los flujos de trabajo de pruebas unitarias tradicionales y podría impactar dramáticamente en la productividad del desarrollo.

Parámetros del Proyecto

Para esta investigación, establecimos una metodología estructurada:

- Entrada de IA: Proporciona a la IA el código fuente, archivos de prueba de ejemplo que muestran patrones/estilo, requisitos de prueba y el contexto del entorno de desarrollo

- Límites Humanos: Restringe la entrada humana a aclaraciones, corrección de conceptos erróneos y proporcionar contexto faltante — sin escritura directa de código

- Enfoque de Medición: Rastrea el tiempo hasta la finalización, iteraciones requeridas, tipos de errores encontrados, calidad de salida, cobertura alcanzada y esfuerzo humano requerido

Nuestros criterios de éxito fueron ambiciosos pero necesarios para la aplicabilidad en producción:

- Cobertura de pruebas del 100%

- Implementación segura de tipo

- Adherencia a las mejores prácticas de pruebas

- Intervención humana mínima

- Tiempo razonable de finalización

- Código de pruebas mantenible

Principales Hallazgos de la Investigación

En tan solo tres días, nuestro equipo añadió 273 nuevas pruebas al proyecto de Planificador de Negocios, aumentando dramáticamente nuestra cobertura de pruebas. Tras analizar múltiples implementaciones de pruebas generadas por IA en diferentes servicios y componentes, surgieron varios patrones que ofrecen valiosas percepciones sobre el estado actual de las pruebas unitarias impulsadas por IA.

1. Métricas De Eficiencia

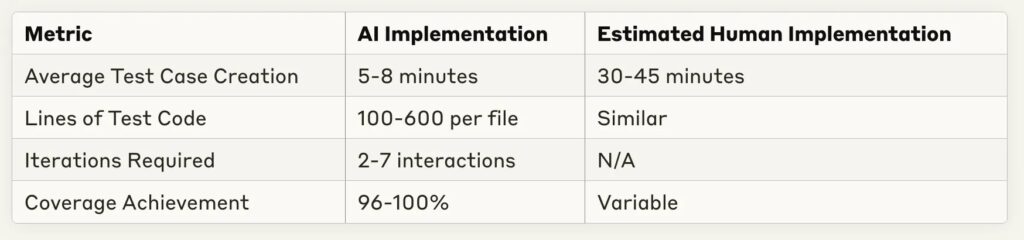

Uno de los hallazgos más sorprendentes fue la reducción dramática en el tiempo de implementación:

El ahorro de tiempo es sustancial — la mayoría de las implementaciones de prueba se completaron en menos de 10 minutos, con un equivalente humano estimado de 30–60 minutos para la misma tarea. Esto representa un aumento potencial de 4–6 veces en la productividad para la escritura de pruebas rutinarias.

2. Fortalezas de la Prueba de IA

A través de múltiples implementaciones, ciertas capacidades de IA destacaron consistentemente:

- Cobertura Integral: La IA logró consistentemente una cobertura de código del 96–100% en diferentes complejidades de servicios

- Reconocimiento de Patrones: La IA se destacó en reconocer patrones de prueba a partir de ejemplos y aplicarlos consistentemente

- Adaptación a Retroalimentación: La mayoría de los errores se pudieron resolver con mínimas aclaraciones

- Implementación de Simulaciones: La IA demostró fuertes capacidades en la creación de simulaciones y accesorios de prueba apropiados

- Consistencia Estructural: La organización de las pruebas siguió las mejores prácticas con patrones claros de organizar-actuar-afirmar

3. Limitaciones y Desafíos Observados

A pesar de los impresionantes resultados, surgieron varios desafíos recurrentes:

- Manejo de Tipos en TypeScript: La fuente más frecuente de errores involucra definiciones de tipos incompletas o suposiciones incorrectas sobre los tipos

- Comprensión de la Estructura del Proyecto: Las rutas de importación y las relaciones de dependencia a menudo requirieron correcciones por parte de humanos

- Cobertura de Casos Límite: Mientras que las rutas básicas estaban bien cubiertas, la lógica condicional compleja a veces necesitaba casos de prueba adicionales

- Suposiciones de la Plantilla: La IA ocasionalmente hacía suposiciones infundadas sobre plantillas o patrones específicos de la aplicación

- Requisitos de Iteración: Los servicios más complejos requerían más intercambios de ida y vuelta para lograr una cobertura completa

Instantáneas De Casos De Estudio

Examinemos algunas implementaciones representativas para entender mejor estos patrones.

Caso 1: Prueba de Exportación de Constantes Simples

Para probar archivos que contienen principalmente exportaciones constantes:

- Tiempo de Implementación: 1 minuto 30 segundos

- Casos de Prueba: 10

- Cobertura: 100%

- Iteraciones: 1 (no se necesitan correcciones)

- Metodología: Uso efectivo de pruebas de instantáneas para objetos constantes grandes

Este caso demuestra que para escenarios de prueba sencillos, la IA puede generar pruebas completas sin ninguna iteración — esencialmente “perfectas” en el primer intento.

Caso 2: Servicio Complejo con Dependencias de DI

Para un servicio más complejo con inyección de dependencias:

- Tiempo de Implementación: 4 minutos 50 segundos

- Casos de Prueba: 5

- Cobertura: 100%

- Iteraciones: 2

- Desafíos: Se requirió la implementación de pruebas de Bootstrap que necesitaban correcciones en la vinculación de dependencias

La IA abordó con éxito las pruebas de inyección de dependencias, necesitando solo ajustes menores para la inicialización del contenedor.

Caso 3: Servicio Altamente Complejo con Muchas Ramas

Para los servicios más complejos probados:

- Tiempo de Implementación: 24 minutos

- Casos de Prueba: 11

- Cobertura: 51.26% (por debajo del objetivo)

- Iteraciones: 5–6

- Desafíos: Dificultad para lograr cobertura completa de las ramas en lógica condicional compleja

Esto representa un caso límite importante donde la IA aún tiene dificultades con las pruebas exhaustivas de lógicas de ramificación muy complejas.

Implicaciones para el Proceso de Desarrollo

Estos hallazgos sugieren varios cambios en cómo podríamos abordar la implementación de pruebas:

1. Flujo de Trabajo Revisado

En lugar de que los desarrolladores escriban pruebas desde cero, un flujo de trabajo más eficiente parece ser:

- El desarrollador provee el código fuente y pruebas de ejemplo a la IA

- La IA genera una implementación inicial de las pruebas

- El desarrollador proporciona retroalimentación iterativa sobre problemas específicos

- La IA refina la implementación hasta alcanzar los objetivos de cobertura

- El desarrollador realiza la revisión final y hace los commits

Este enfoque permite a los desarrolladores centrarse en revisar la calidad de las pruebas y los casos límite en lugar de escribir código de prueba repetitivo.

2. Oportunidades de Optimización

Varias prácticas mejoraron significativamente el rendimiento de generación de pruebas de IA:

- Proporcionar ejemplos claros de pruebas en el mismo estilo/patrón

- Especificar los requisitos de cobertura exactos de antemano

- Incluir información sobre tipos complejos

- Identificar proactivamente casos límite potenciales

- Usar enfoques de prueba primero donde la IA tiene acceso tanto a la implementación como a las pruebas simultáneamente

3. Impacto Económico

Basado en la comparación entre el tiempo de implementación de IA y el tiempo estimado de implementación humana, las ganancias potenciales de productividad son sustanciales:

- Reducción del 70–85% en el tiempo dedicado a escribir pruebas unitarias rutinarias

- Mayor consistencia en la cobertura

- Ciclos de retroalimentación más rápidos durante el desarrollo

- Más casos de prueba para el mismo esfuerzo de desarrollo

Mirando Hacia Adelante: El Futuro de las Pruebas Impulsadas por IA

Esta investigación representa una exploración temprana de lo que probablemente se convertirá en una práctica estándar de desarrollo. Varias tendencias sugieren hacia dónde se dirige este campo:

Oportunidades Futuras

- Desarrollo Guiado por Pruebas: La IA podría generar tanto pruebas como código de implementación de manera iterativa

- Integración con CI/CD: Generación y mantenimiento de pruebas automatizadas durante el proceso de compilación

- Entrenamiento de Dominio Personalizado: Ajuste fino de modelos para bases de código específicas o patrones

- Pruebas Auto-Reparables: IA que actualiza las pruebas cuando cambia la implementación

- Modelos de Pruebas Especializadas: Modelos de IA específicamente optimizados para la generación de pruebas

Desafíos Restantes

A pesar de los significativos avances, quedan varios desafíos:

- Gestión de Estado Compleja: Pruebas de componentes con estados y interacciones complejas

- Conocimientos Especializados: Pruebas que requieren conocimientos específicos del dominio o reglas de negocio

- Pruebas de Integración: Avanzando más allá de las pruebas unitarias hacia pruebas de integración y de sistema

- Pruebas de Rendimiento: Identificación y ejecución de pruebas de rendimiento efectivas

- Pruebas de Seguridad: Encontrar y explotar vulnerabilidades de seguridad

Resumen del Proyecto: Los Números

Aquí tienes un resumen de lo que logramos en nuestro experimento de tres días:

- Adiciones de Pruebas: Se agregaron 273 pruebas nuevas (de 22 a 295 en total)

- Tasa de Éxito: ~90% de los intentos alcanzaron con éxito el 100% de cobertura

- Tiempo de Implementación: Promedio de 5–8 minutos por componente

- Suite de Pruebas Más Grande: 273 pruebas agregadas en un tiempo total de trabajo de aproximadamente 6 horas

- Implementación Más Rápida: 90 segundos para capturas del framework con 100% de cobertura

- Caso Más Complejo: Componente de gráficos con 13 dependencias, completado en 5 minutos

- Nivel de Calidad: Se mantuvo la calidad de código a nivel de desarrollador senior

- Entrada Humana: Cero líneas de código escritas por humanos

Desde una perspectiva de ROI, estimamos un ahorro de tiempo del 70–80% en comparación con la implementación manual, sin comprometer la calidad. El único fallo notable fue con RunsService, donde solo logramos un 51% de cobertura debido a una lógica de ramificación extremadamente compleja.

Conclusión: Recomendaciones Prácticas

Basado en esta investigación, recomendamos las siguientes prácticas para equipos que buscan aprovechar la IA para pruebas de unidad:

- Empieza Simple: Comienza con componentes sencillos que sigan patrones establecidos

- Proporciona Ejemplos: Incluye ejemplos representativos de tu estilo de prueba

- Retroalimentación Iterativa: Planea 2–3 ciclos de retroalimentación para lograr resultados óptimos

- Enfócate en Casos Límite: Utiliza tu conocimiento del dominio para sugerir casos límite que la IA podría pasar por alto

- Establece Pautas Claras: Define cómo se ve el “finalizado” para la cobertura y el estilo de prueba

- Actualizaciones Regulares: A medida que los modelos de IA mejoren, revisa tu enfoque para aprovechar nuevas capacidades

El aspecto más emocionante de esta investigación es que representa solo el principio. A medida que las capacidades de la IA continúan evolucionando, el potencial para las pruebas impulsadas por IA se expandirá a través de dominios de prueba más complejos, transformando finalmente cómo abordamos el aseguramiento de la calidad en el desarrollo de software.

Esta investigación se llevó a cabo durante tres días en febrero de 2025 en el proyecto de Planificador de Negocios de DreamHost, utilizando múltiples modelos de IA incluyendo GitHub Copilot, los modelos GPT de OpenAI y Claude de Anthropic. El entorno de prueba fue un servicio basado en TypeScript con Jest y ts-mockito para las pruebas, enfocándose en componentes de aplicaciones empresariales del mundo real. Lo más importante, no escribimos ninguna línea de código durante todo el proceso — toda la implementación de las pruebas fue realizada por IA con solo guía humana.

Esta publicación es la Parte 3 de una serie de 4 partes. Asegúrate de revisar las otras publicaciones de la serie para profundizar en nuestro generador de planes de negocio impulsado por IA.

Parte 1: Cómo Construimos un Generador de Planes de Negocio Impulsado por IA Usando LangGraph & LangChain

Parte 2: Cómo Optimizamos la Generación de Planes de Negocio con IA: Compromisos entre Velocidad y Calidad

Parte 3: Cómo Creamos 273 Pruebas de Unidad en 3 Días Sin Escribir una Sola Línea de Código

Parte 4: Marco de Evaluación de IA — Cómo Construimos un Sistema para Evaluar y Mejorar Planes de Negocio Generados por IA